抓取预算优化:停止浪费抓取预算的 8 个技巧

已发表: 2022-07-26底线:如果 Google 无法抓取您的重要页面,它们将不会出现在搜索结果中。 这可能导致自然流量低于预期和排名下降。

抓取预算优化使 Google 可以更轻松地访问、抓取和索引您的每个重要页面,以便您可以通过搜索吸引更多客户。 以下是您需要了解的有关抓取预算、如何识别抓取预算浪费以及您可以采取哪些措施来优化您的网站以避免任何可能的 SEO 抓取预算问题。

什么是抓取预算?

您的抓取预算是指 Google 在任何一天抓取的您网站的网页数。 它基于您的抓取速率限制和抓取需求。

您的抓取速度限制是 Google 在不影响您网站的用户体验的情况下可以抓取的页面数量。 从本质上讲,Google 不想让您的服务器因请求而过载,因此它在您的服务器可以处理的内容(您的服务器资源)和它“想要”抓取您的网站的程度之间找到了一个令人满意的媒介。

您的抓取需求取决于 URL 的受欢迎程度及其新鲜度。 如果一个 URL 是陈旧的并且很少有人搜索它,那么 Google 将不那么频繁地抓取它。

虽然您无法影响抓取速度,但您可以通过创建新鲜内容、使用 SEO 最佳实践优化您的网站以及解决 404 和不必要的重定向等 SEO 问题来影响您的抓取需求。

什么是爬网预算优化?

抓取预算优化是通过提高搜索抓取工具的可导航性和减少抓取预算浪费,使 Googlebot 更容易访问、抓取和索引您的网站的过程。 这包括减少错误和断开的链接、改进内部链接、不索引重复内容等等。

当 Google 没有抓取您网站上足够多的页面或没有足够频繁地抓取它们时,抓取预算可能会成为一个问题。

因为它只有一定数量的资源可供使用,所以谷歌在任何一天只能将这么多的抓取分配给任何给定的网站。 如果您有一个大型网站,这意味着 Google 可能只有资源来每天抓取您网站的一小部分页面。 这可能会影响您的网页被编入索引或内容更新反映在 Google 排名中所需的时间。

值得庆幸的是,如果您认为您的网站可能存在 Google 抓取预算问题,您可以采取某些措施来优化您的网站并充分利用您的抓取预算。

如何检查您的抓取统计报告

您可以通过在 Google Search Console 中检查您的抓取统计信息或分析您的服务器文件日志来确定抓取预算问题。

在 Google Search Console 中查看您的抓取统计报告可以帮助您更好地了解 Googlebot 如何与您的网站进行交互。 以下是您如何使用它来查看 Google 的爬虫在做什么。

打开 Google Search Console,登录并选择您的网站。 然后从 Search Console 菜单中选择“设置”选项。

您可以在抓取统计信息部分下查看过去 90 天的抓取报告。 单击“打开报告”将其打开。

您的抓取统计报告的含义

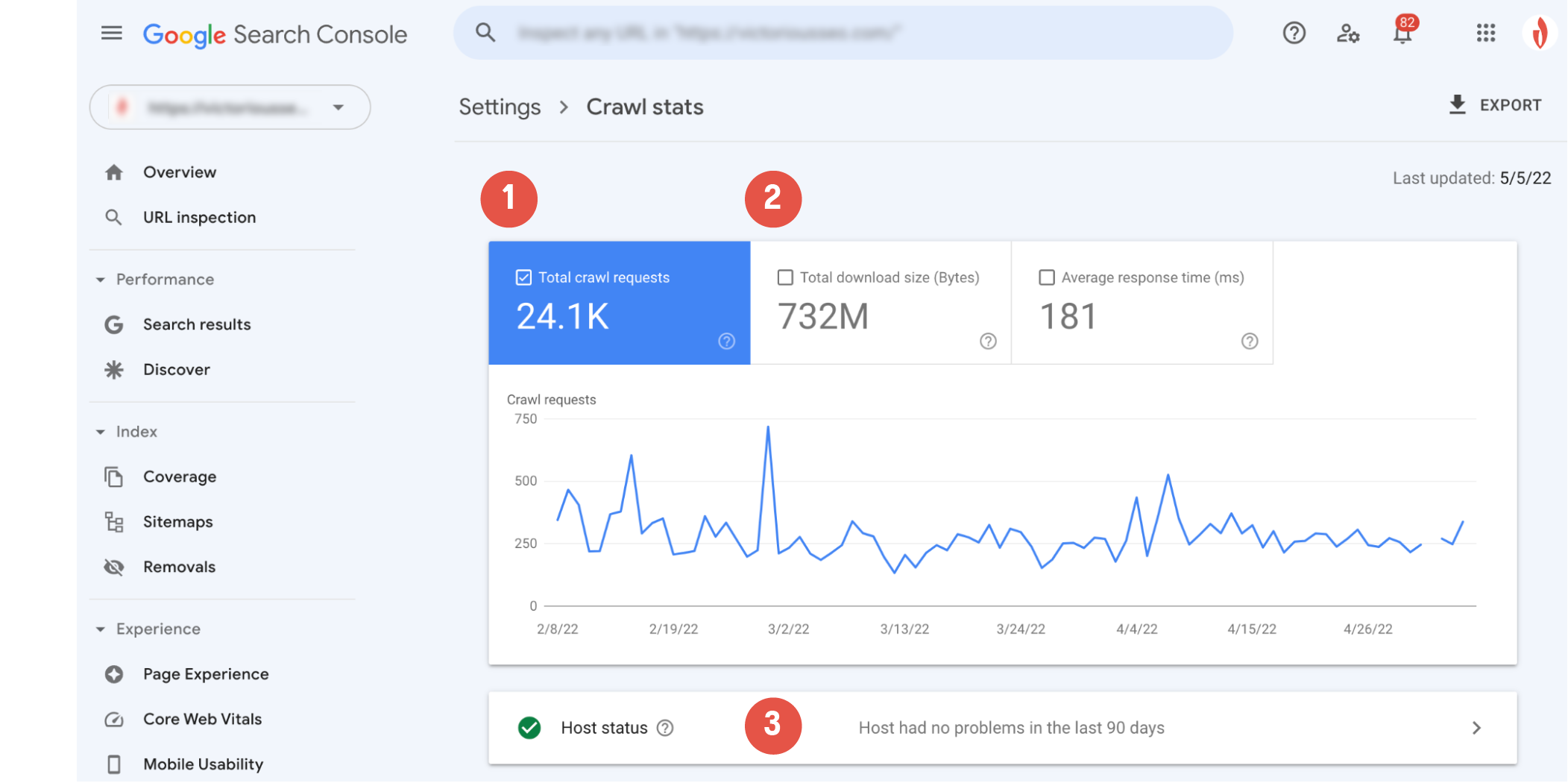

现在您可以看到 Googlebot 的活动,是时候解码数据了。 以下是您可以从抓取报告中获得的信息类型的快速细分。

主抓取图表将向您展示 Googlebot 抓取活动的直观表示。 在这里,您可以看到 (1) Google 在过去 90 天内发出了多少抓取请求,以及 (2) 您网站服务器的平均响应时间以及抓取时下载的总字节数。

“主机状态”部分 (3) 将让您知道爬虫在访问您的网站时是否遇到任何可用性问题。

带有白色复选标记的绿色圆圈表示 Googlebot 没有遇到任何问题,表明您的主机运行顺利。

带有绿色复选标记的白色圆圈表示 Googlebot 在一周前遇到了问题,但现在一切正常。

带有白色感叹号的红色圆圈表示 Googlebot 在过去一周内至少遇到了一个重大问题。

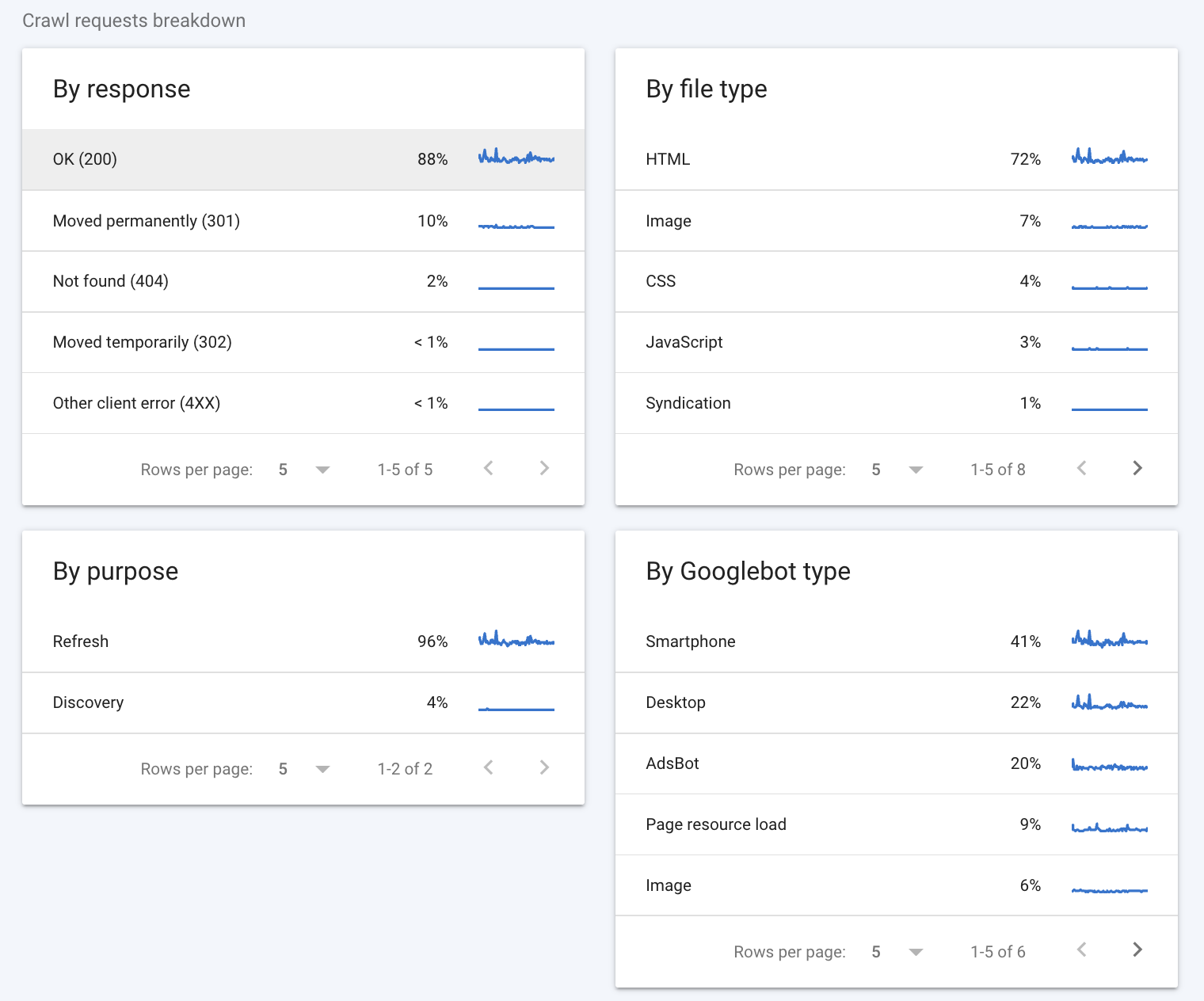

抓取请求细分提供了一些关于 Google 抓取工具如何与您的网站交互的更详细信息。

通过响应

要查看的第一部分是“按响应”部分。 本节介绍 Googlebot 在尝试抓取您网站上的网页时收到的响应类型。 谷歌认为以下是很好的回应:

- 好的 (200)

- 永久搬迁 (301)

- 临时搬家 (302)

- 搬家(其他)

- 未修改 (304)

理想情况下,大多数响应应该是 200(一些 301 也可以)。 诸如“未找到 (404)”之类的代码提醒您,您的网站上可能存在死胡同,这可能会影响您的抓取预算。

文件类型

“按文件类型”部分会告诉您 Googlebot 在抓取过程中遇到的文件类型。 您看到的百分比值代表该类型响应的百分比,而不是每种文件类型的字节百分比。

按目的

“按目的”部分指示爬取的页面是爬虫以前见过的页面(刷新)还是对爬虫来说是新的(发现)。

按 Googlebot 类型

最后,“按 Googlebot 类型”部分会告诉您用于发出请求和抓取您的网站的 Googlebot 抓取代理的类型。 例如,“智能手机”类型表示 Google 的智能手机抓取工具进行的访问,而“AdsBot”类型表示 Google 的 AdsBot 抓取工具之一进行的抓取。 附带说明一下,您始终可以通过编辑 robots.txt 文件来禁止特定类型的 Googlebot 抓取您的网站。

如果您想详细了解如何解释抓取报告中的数据,请查看 Google 的 Search Console 抓取报告指南。

如何判断您是否在浪费您的抓取预算

确定优化抓取预算是否有助于 Googlebot 抓取更多网页的一种快速方法是查看每天实际抓取的网站网页的百分比。

找出您网站上有多少独特页面,然后将其除以“平均每天抓取”数字。 如果您的页面总数是每天抓取的页面数量的十倍或更多,您应该考虑抓取预算优化。

如果您认为自己遇到了抓取预算问题,请先查看“按响应”部分,了解抓取工具可能遇到的错误类型。 您可能需要进行更深入的分析,以准确了解您的预算消耗了什么。 查看您的服务器日志可以为您提供有关爬虫如何与您的站点交互的更多信息。

检查您的服务器日志

检查您是否浪费抓取预算的另一种方法是查看您网站的服务器日志。 这些日志会存储对您的网站发出的每一个请求,包括 Googlebot 在抓取您的网站时发出的请求。 分析您的服务器日志可以告诉您 Google 抓取您网站的频率、抓取工具最常访问的页面以及抓取工具机器人遇到的错误类型。

您可以手动检查这些日志,尽管挖掘这些数据可能有点乏味。 值得庆幸的是,几种不同的日志分析器工具可以帮助您对日志数据进行排序和理解,例如 SEMRush 日志文件分析器或 Screaming Frog SEO 日志文件分析器。

抓取预算 SEO:优化抓取预算的 8 种方法

您是否发现浪费的抓取预算? 抓取预算 SEO 优化策略可以帮助您减少浪费。 这里有八个技巧可以帮助您优化 SEO 抓取预算以获得更好的性能。

1. Finetune Robots.txt & Meta Robots 标签

抑制浪费的抓取预算的一种方法是首先阻止 Google 的抓取工具抓取某些页面。 通过让 Googlebot 远离您不想编入索引的页面,您可以将注意力集中在更重要的页面上。

robots.txt 文件为搜索爬虫设置边界,声明您要爬取哪些页面以及哪些页面是禁区。 在 robots.txt 文件中添加禁止命令将阻止爬虫访问、爬取和索引指定的子目录,除非有指向这些页面的链接。

在页面级别,您可以使用元机器人标签对特定页面进行无索引。 noindex 标记允许 Googlebot 访问您的页面并跟踪其上的链接,但它告诉 Googlebot 避免将页面本身编入索引。 此标记直接进入 HTML 代码的 <head> 元素,如下所示:

<meta name=”robots” content=”noindex” />2. 修剪内容

在您的网站上托管低价值 URL 或重复内容可能会拖累您的抓取预算。 深入了解您网站的页面可以帮助您识别不必要的页面,这些页面可能会占用抓取预算并防止更有价值的内容被抓取和编入索引。

什么是低价值 URL? 根据 Google 的说法,低价值 URL 通常属于以下几类之一:

- 重复内容

- 会话标识符

- 软错误页面

- 被黑页面

- 低质量和垃圾邮件内容

重复的内容并不总是很容易识别。 如果一个页面上的大部分内容与另一个页面的内容相同——即使您添加了更多内容或更改了一些字词——Google 也会将其视为明显相似。 利用 noindex 元标记和规范标记来指示哪个页面是应该被索引的原始页面。

通过更新、删除或不对可能注册为低价值的内容编制索引,您可以让 Googlebot 有更多机会抓取您网站上真正重要的网页。

推荐阅读

- 重复内容 SEO:如何检查重复内容

- 为什么内容修剪有助于您的 SEO(以及如何做到这一点)

3. 移除或渲染 JavaScript

Googlebot 读取 HTML 没有问题,但是,它必须先呈现 JavaScript,然后才能读取它并将其编入索引。 因此,Google 不会抓取页面上的 JavaScript 元素并将其编入索引,而是抓取页面上的 HTML 内容,然后将页面放入呈现队列中。 当它有时间和资源用于渲染时,它会渲染 JavaScript 并“读取”它,然后最终索引它。 这个额外的步骤不仅需要更多时间——还需要更多的抓取预算。

JavaScript 也会影响您的页面加载时间,并且由于网站速度和服务器负载会影响您的抓取预算,如果您的网站因过多的 JavaScript 而陷入困境,Google 可能会降低您的网站的抓取频率。

为了节省抓取预算,您可以不使用 JavaScript 索引页面,删除 JavaScript 元素,或使用 Prerender 之类的工具将动态 JavaScript 内容呈现为静态 HTML,让 Google 更容易理解和抓取。

4.删除301重定向链

301 重定向是一种有用且对 SEO 友好的方式,可以将流量和链接资产从您要删除的 URL 转移到另一个相关 URL。

但是,如果您不跟踪重定向,很容易意外创建重定向链。 这不仅会导致网站访问者的加载时间增加,而且还会导致爬虫爬取多个 URL,只是为了访问一页实际内容。 这意味着 Google 需要抓取重定向链中的每个 URL 才能到达目标页面,在此过程中会耗尽您的抓取预算。

为防止这种情况,请确保您的所有重定向都指向其最终目的地。 尽可能避免使用重定向链总是好的做法。 尽管如此,还是会发生错误,因此请花一些时间手动浏览您的网站或使用重定向检查工具来发现和清理任何 301 重定向链。

5. 遵循 XML 站点地图最佳实践

您的站点地图与搜索爬虫共享所有重要页面——或者至少应该如此。 搜索引擎抓取站点地图以轻松找到页面。 虽然谷歌说它不需要一个来找到你的页面,但维护一个仍然是一个好主意。

为了正常运行,您的站点地图应该只包含您想要编入索引的页面。 您应该从您的站点地图中删除所有未编入索引或重定向的 URL。 一个简单的方法是使用动态生成的 XML 站点地图。 动态生成的站点地图会自行更新,因此您不必担心在每次实施 301 后编辑您的站点地图。

如果您的网站上有多个子目录,请使用包含指向每个子目录的站点地图的链接的站点地图索引。 这有助于展示您的网站架构,并为搜索爬虫提供一个简单的路线图。

6.创建内部链接策略

内部链接不仅可以帮助网站访问者四处走动; 它们还为爬虫机器人创造了更清晰的移动路径。

完善的内部链接策略可以将爬虫指向您想要爬取的页面。 因为爬虫使用链接来查找其他页面,将更深的页面与更高级别的内容相互链接可以帮助爬虫更快地访问它们。 同时,从您不希望占用爬网预算的低优先级页面中删除链接可能有助于将它们推到队列的最后,并确保您的重要页面首先被爬网。

7.修复网站错误

网站错误可能会绊倒搜索爬虫并浪费宝贵的爬虫预算。 理想情况下,您希望爬虫遇到实际页面或单个重定向到该页面。 如果它遇到重定向链或 404 错误页面,那么您就是在浪费抓取预算。

使用您的 Google Search Console 抓取报告来确定抓取工具在哪里遇到错误以及它们是什么类型的错误。 消除任何可识别的错误将为 Googlebot 创造更流畅的抓取体验。

8.检查损坏的链接

URL 基本上是两个页面之间的桥梁。 它为搜索引擎爬虫提供了一条寻找新页面的途径——但有些 URL 无处可去。 断开的链接是搜索引擎爬虫的死胡同,浪费了您有限的爬虫预算。

花一些时间检查您的网站是否存在损坏的链接,这些链接可能会将搜索爬虫发送到死页并更正或删除它们。 除了减少抓取预算浪费外,您还将通过删除损坏的链接来改善访问者的浏览体验,因此定期检查链接始终是一个好主意。

通过 SEO 审计停止浪费的抓取预算

感到不知所措或不确定从哪里开始优化网站的抓取预算或一般 SEO? 没必要一个人去。 立即与 Victorious 预约咨询,让我们的专家帮助您完成执行 SEO 审核并制定优化网站 SEO 的策略。