社交帖子的自我分类会改善调节在线言论的关键问题吗?

已发表: 2022-12-16内容审核是目前社交媒体圈的热门话题,埃隆·马斯克 (Elon Musk) 着手改革 Twitter,同时发布过去的审核操作,以此说明社交媒体应用程序如何获得过多的权力来控制某些讨论。

但是,尽管马斯克强调了过程中的缺陷,但现在的问题是,你如何解决它? 如果内容决策不能有效地交由负责平台本身的小型执行团队处理,那么还有什么选择呢?

Meta 与外部专家小组的实验总体上取得了成功,但即便如此,其监督委员会也无法对每项内容决策做出裁决,尽管采用了这种替代方法,Meta 仍然因感知审查和偏见而受到严厉批评上诉。

在某种程度上,一些决策因素将不可避免地落在平台管理上,除非可以设想出另一种途径。

基于个人喜好的替代提要是否可以作为解决此类问题的另一种方式?

一些平台正在研究这一点。 据《华盛顿邮报》报道, TikTok 目前正在探索一种称为“内容级别”的概念,以防止“成人”内容出现在年轻观众的信息流中。

TikTok 在这方面受到越来越多的审查,特别是在危险的挑战趋势方面,已经看到一些年轻人因参与危险行为而丧生。

埃隆·马斯克 (Elon Musk) 也吹捧了一种类似的内容控制方法,作为他对“Twitter 2.0”的更广泛愿景的一部分。

好点子。

- 埃隆·马斯克 (@elonmusk) 2022 年 10 月 29 日

能够选择你想要的 Twitter 版本可能更好,就像电影成熟度评级一样。

推文本身的评级可以自行选择,然后根据用户反馈进行修改。

在马斯克的变体中,用户会在上传推文时对推文进行自我分类,然后读者也可以应用他们自己的成熟度评级,以帮助将潜在的有害内容转移到一个单独的类别中。

这两种情况的最终结果都意味着用户可以在应用程序中选择不同级别的体验——从“安全”到“未过滤”(马斯克可能会去与'硬核'),这将为您提供完整的体验。

这在理论上听起来很有趣——但在现实中,用户是否真的会对他们的推文进行自我分类,他们是否会经常获得这些评级的正确性,使其成为此类过滤的可行选择?

当然,该平台可以对不分类或未能正确分类您的推文进行惩罚。 也许,对于惯犯来说,他们所有的推文都会自动过滤到更极端的细分中,而其他人则可以通过在两个或所有流中显示他们的内容来获得最大的受众范围。

在组合过程中选择分类时,用户需要做更多的手动工作,但这也许可以减轻一些担忧?

但话又说回来,这仍然无法阻止社交平台被用来放大仇恨言论和助长危险运动。

在大多数情况下,Twitter 或其他社交应用程序已被转移到审查用户,这是因为受到伤害的威胁,而不是因为人们一定会被所发表的评论冒犯。

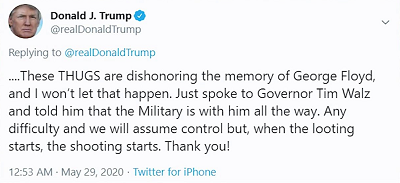

例如,当前总统唐纳德特朗普发布时:

与其说人们会被他“抢劫开始,枪击开始”的评论冒犯,不如说人们担心,更多的是特朗普的支持者可能会把这当成杀戮的许可证,而总统实际上支持使用致命武力威慑抢劫者。

从逻辑上讲,社交平台不希望他们的工具被用来以这种方式传播潜在的危害,在这方面,自我审查或为您的帖子选择成熟度评级不会解决这个关键问题,它会只是对选择不看的用户隐藏此类评论。

换句话说,它比提高安全性更令人困惑——但许多人似乎认为核心问题不在于人们在网上说和想说这样的话,而是其他人被冒犯了。

这不是问题所在,虽然隐藏潜在的冒犯性材料可能在减少曝光率方面具有一定价值,尤其是在 TikTok 的情况下,对于年轻的观众来说,它仍然不会阻止人们利用社交应用程序的巨大影响力来传播仇恨和危险的行动呼吁,这确实会导致现实世界的伤害。

从本质上讲,这是一种零碎的提供,稀释的责任在某些情况下会产生一些影响,但不会解决社交平台的核心责任,以确保他们创建的工具和系统不会被用于危险的目的目的。

因为他们是,而且他们将继续是。 社交平台已被用来助长内乱、政治起义、骚乱、军事政变等。

就在本周,对 Meta 发起了新的法律诉讼,原因是 Meta 允许“埃塞俄比亚的暴力和仇恨帖子在 Facebook 上泛滥,煽动该国的血腥内战”。 该诉讼要求为由此产生的暴力行为的受害者赔偿 20 亿美元。

这不仅仅是关于您不同意的政治观点,社交媒体平台还可以用来助长真实的、危险的运动。

在这种情况下,再多的自我认证也无济于事——平台总是有责任制定规则,以确保这些类型的最坏情况得到解决。

或者规则需要由政府和机构在更高级别制定,旨在衡量此类影响并采取相应行动。

但归根结底,这里的核心问题并不是社交平台允许人们说出他们想说的话,分享他们喜欢的东西,正如许多“言论自由”倡导者所推动的那样。 在某种程度上,总会有限制,总会有护栏,有时,考虑到社会职位的放大潜力,它们可能会超出土地法则。

没有简单的答案,但听任人民的意愿决定,不太可能在所有方面都产生更好的局面。