Auto-clasificarea postărilor sociale ar îmbunătăți problemele cheie în moderarea vorbirii online?

Publicat: 2022-12-16Moderarea conținutului este un subiect fierbinte în cercurile rețelelor de socializare în prezent, deoarece Elon Musk încearcă să reformeze Twitter, publicând simultan acțiunile anterioare de moderare, ca o ilustrare a modului în care aplicațiile de rețele sociale au câștigat prea multă putere pentru a controla anumite discuții.

Dar, în ciuda faptului că Musk evidențiază defecte percepute în proces, întrebarea este acum, cum o remediați? Dacă nu se poate avea încredere în deciziile privind conținutul în mâinile unor echipe mici de directori care se ocupă de platformele în sine, atunci care este alternativa?

Experimentul lui Meta cu un grup de experți externi a fost, în general, un succes, dar chiar și atunci, Consiliul său de Supraveghere nu se poate pronunța cu privire la fiecare decizie de conținut, iar Meta este încă criticată pentru cenzură și părtinire percepută, în ciuda acestor mijloace alternative. de recurs.

La un anumit nivel, un element de luare a deciziilor va cădea inevitabil pe managementul platformei, cu excepția cazului în care poate fi concepută o altă cale.

Ar putea feed-urile alternative, bazate pe preferințele personale, să fie o altă modalitate de a aborda acest lucru?

Unele platforme analizează acest lucru. După cum a raportat The Washington Post, TikTok explorează în prezent un concept pe care îl numește „Niveluri de conținut”, într-un efort de a împiedica conținutul „matur” să apară în feedurile spectatorilor mai tineri.

TikTok a fost din ce în ce mai analizat pe acest front, în special în ceea ce privește tendințele de provocări periculoase, care au văzut unii tineri uciși ca urmare a participării la acte riscante.

Elon Musk a promovat, de asemenea, o abordare similară a controlului conținutului, ca parte a viziunii sale mai ample pentru „Twitter 2.0”.

Buna observatie.

— Elon Musk (@elonmusk) 29 octombrie 2022

A fi capabil să selectezi ce versiune de Twitter vrei este probabil mai bine, așa cum ar fi pentru un rating de maturitate a filmului.

Evaluarea tweet-ului în sine ar putea fi auto-selectată, apoi modificată de feedback-ul utilizatorului.

În varianta lui Musk, utilizatorii și-ar autoclasifica tweet-urile pe măsură ce le încarcă, cititorii putând, de asemenea, să-și aplice propriul rating de maturitate, pentru a ajuta la mutarea conținutului potențial dăunător într-o categorie separată.

Rezultatul final în ambele cazuri ar însemna că utilizatorii ar putea apoi să aleagă din diferite niveluri de experiență în aplicație – de la „sigur”, care ar filtra comentariile și discuțiile mai extreme, la „nefiltrate” (Musk ar merge probabil cu „hardcore”), care ți-ar oferi experiența completă.

Ceea ce sună interesant, în teorie - dar, în realitate, utilizatorii și-ar auto-clasifica de fapt tweet-urile și ar obține aceste evaluări corecte suficient de des pentru a o face o opțiune viabilă pentru acest tip de filtrare?

Desigur, platforma ar putea implementa pedepse pentru neclasificarea sau neclasificarea corectă a tweet-urilor. Poate că, pentru recidivitorii, toate tweet-urile lor sunt filtrate automat în segmentarea mai extremă, în timp ce altele pot obține o acoperire maximă a audienței afișând conținutul lor în ambele sau în toate fluxurile.

Ar necesita mai multă muncă manuală pentru utilizatori, în selectarea unei clasificări în cadrul procesului de compunere, dar poate că asta ar putea atenua unele preocupări?

Dar, din nou, acest lucru nu ar împiedica platformele sociale să fie folosite pentru a amplifica discursul instigator la ură și pentru a alimenta mișcări periculoase.

În majoritatea cazurilor în care Twitter, sau alte aplicații sociale, au fost mutate pentru a cenzura utilizatorii, aceasta a fost din cauza amenințării cu un rău, nu pentru că oamenii sunt neapărat jigniți de comentariile făcute.

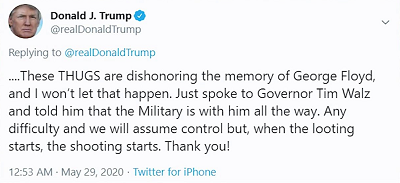

De exemplu, când fostul președinte Donald Trump a postat:

Preocuparea nu a fost atât de mult că oamenii ar fi jignit de comentariul său „când încep jefuirea, începe împușcătura”, îngrijorarea era mai mult că susținătorii lui Trump ar putea considera asta, în esență, o licență de a ucide, președintele aprobând efectiv. folosirea forței mortale pentru a descuraja jefuitorii.

Platformele sociale, în mod logic, nu doresc ca instrumentele lor să fie folosite pentru a răspândi potențialele daune în acest fel și, în acest sens, autocenzura sau selectarea unui rating de maturitate pentru postările tale, nu va rezolva problema cheie, va ascundeți astfel de comentarii de la utilizatorii care aleg să nu le vadă.

Cu alte cuvinte, este mai mult o ofucare decât o securitate îmbunătățită - dar mulți par să creadă că problema principală nu este că oamenii spun și vor să spună astfel de lucruri online, ci că alții sunt jigniți de astfel de lucruri.

Nu aceasta este problema și, deși ascunderea materialului potențial ofensator ar putea avea o anumită valoare în reducerea expunerii, în special, în cazul TikTok, pentru publicul mai tânăr, încă nu îi va împiedica pe oameni să folosească potențialul masiv de acoperire al aplicațiilor sociale pentru a răspândi ura. și îndemnuri periculoase la acțiune, care într-adevăr pot duce la vătămări în lumea reală.

În esență, este o ofertă fragmentată, o diluare a responsabilității care va avea un anumit impact, în unele cazuri, dar nu va aborda responsabilitatea de bază pentru platformele sociale pentru a se asigura că instrumentele și sistemele pe care le-au creat nu sunt folosite pentru scop.

Pentru că sunt și vor continua să fie. Platformele sociale au fost folosite pentru a alimenta tulburări civile, revolte politice, revolte, lovituri de stat militare și multe altele.

Chiar în această săptămână, au fost lansate noi acțiuni legale împotriva lui Meta pentru că a permis „ postări violente și pline de ură în Etiopia să înflorească pe Facebook, incendiind sângerosul război civil al țării ”. Procesul dă în judecată pentru 2 miliarde de dolari daune pentru victimele violenței rezultate.

Nu este vorba doar de opiniile politice cu care nu sunteți de acord, platformele de socializare pot fi folosite pentru a alimenta mișcări reale și periculoase.

În astfel de cazuri, nicio auto-certificare nu este de natură să ajute – va exista întotdeauna o anumită sarcină pe platforme de a stabili regulile, pentru a se asigura că aceste tipuri de scenarii de cel mai rău caz sunt abordate.

Acestea sau regulile trebuie stabilite la un nivel superior, de guverne și agenții menite să măsoare impactul acestora și să acționeze în consecință.

Dar, în cele din urmă, problema de bază aici nu este despre platformele sociale care le permit oamenilor să spună ceea ce doresc și să împărtășească ceea ce le place, așa cum susțin mulți susținători ai „libertăţii de exprimare”. La un anumit nivel, vor exista întotdeauna limite, vor exista întotdeauna balustrade și, uneori, acestea se pot extinde dincolo de legile pământului, având în vedere potențialul de amplificare al posturilor sociale.

Nu există răspunsuri ușoare, dar lăsarea în voia oamenilor nu este de natură să conducă la o situație mai bună pe toate fronturile.