Desmascarando 3 mitos comuns por trás do rastreamento de sites, indexação e mapas de site XML

Publicados: 2018-03-07Muitos de nós acreditam erroneamente que o lançamento de um site equipado com um sitemap XML fará com que todas as suas páginas sejam rastreadas e indexadas automaticamente.

Nesse sentido, alguns mitos e equívocos se acumulam. Os mais comuns são:

- O Google rastreia automaticamente todos os sites e faz isso rapidamente.

- Ao rastrear um site, o Google segue todos os links e visita todas as suas páginas e as inclui imediatamente no Índice.

- Adicionar um sitemap XML é a melhor maneira de obter todas as páginas do site rastreadas e indexadas.

Infelizmente, colocar seu site no índice do Google é uma tarefa um pouco mais complicada. Continue lendo para ter uma ideia melhor de como funciona o processo de rastreamento e indexação e qual a função de um sitemap XML nele.

Antes de começarmos a desmascarar os mitos mencionados acima, vamos aprender algumas noções essenciais de SEO:

O rastreamento é uma atividade implementada pelos mecanismos de pesquisa para rastrear e coletar URLs de toda a Web.

A indexação é o processo que segue o rastreamento. Basicamente, trata-se de analisar e armazenar dados da Web que são usados posteriormente ao fornecer resultados para consultas de mecanismos de pesquisa. O Search Engine Index é o local onde todos os dados da Web coletados são armazenados para uso posterior.

Rank de rastreamento é o valor que o Google atribui ao seu site e suas páginas. Ainda não se sabe como essa métrica é calculada pelo mecanismo de busca. O Google confirmou várias vezes que a frequência de indexação não está relacionada à classificação, portanto, não há correlação direta entre uma autoridade de classificação de sites e sua classificação de rastreamento.

Sites de notícias, sites com conteúdo valioso e sites atualizados regularmente têm maiores chances de serem rastreados regularmente.

O orçamento de rastreamento é uma quantidade de recursos de rastreamento que o mecanismo de pesquisa aloca a um site. Normalmente, o Google calcula esse valor com base na classificação de rastreamento do seu site.

Profundidade de rastreamento é uma extensão em que o Google detalha um nível de site ao explorá-lo.

A prioridade de rastreamento é um número ordinal atribuído a uma página do site que significa sua importância em relação ao rastreamento.

Agora, conhecendo todos os fundamentos do processo, vamos acabar com esses 3 mitos por trás dos sitemaps XML, rastreamento e indexação!

Índice

- Mito 1. O Google rastreia automaticamente todos os sites e faz isso rápido.

- Aprendizado

- Mito 2. Adicionar um sitemap XML é a melhor maneira de obter todas as páginas do site rastreadas e indexadas.

- Aprendizado

- Mito 3. Um sitemap XML pode resolver todos os problemas de rastreamento e indexação.

- Aprendizado

Mito 1. O Google rastreia automaticamente todos os sites e faz isso rápido.

O Google afirma que, quando se trata de coletar dados da Web, está sendo ágil e flexível.

Mas verdade seja dita, porque no momento existem trilhões de páginas na Web, tecnicamente, o mecanismo de busca não pode rastrear todas elas rapidamente.

Selecionando sites para alocar orçamento de rastreamento

O algoritmo inteligente do Google (também conhecido como Crawl Budget) distribui os recursos do mecanismo de pesquisa e decide quais sites valem a pena rastrear e quais não valem.

Normalmente, o Google prioriza sites confiáveis que correspondem aos requisitos definidos e servem como base para definir a avaliação de outros sites.

Portanto, se você tiver um site recém-saído do forno ou um site com conteúdo copiado, duplicado ou fino, as chances de ele ser rastreado corretamente são bem pequenas.

Os fatores importantes que também podem influenciar a alocação do orçamento de rastreamento são:

- tamanho do site,

- sua integridade geral (esse conjunto de métricas é determinado pelo número de erros que você pode ter em cada página),

- e o número de links internos e de entrada.

Para aumentar suas chances de obter o orçamento de rastreamento, verifique se seu site atende a todos os requisitos do Google mencionados acima, além de otimizar a eficiência do rastreamento (consulte a próxima seção do artigo).

Previsão de programação de rastreamento

O Google não anuncia seus planos para rastrear URLs da Web. Além disso, é difícil adivinhar a periodicidade com que o mecanismo de pesquisa visita alguns sites.

Pode ser que, para um site, ele execute rastreamentos pelo menos uma vez por dia, enquanto para outros seja visitado uma vez por mês ou com menos frequência.

- A periodicidade dos rastreamentos depende de:

- a qualidade do conteúdo do site,

- a novidade e a relevância das informações que um site oferece,

- e sobre a importância ou a popularidade que o mecanismo de pesquisa considera os URLs do site.

Levando esses fatores em consideração, você pode tentar prever com que frequência o Google pode visitar seu site.

O papel dos links externos/internos e dos mapas de site XML

Como caminhos, os Googlebots usam links que conectam as páginas do site e o site entre si. Assim, o buscador alcança trilhões de páginas interconectadas que existem na web.

O mecanismo de pesquisa pode começar a verificar seu site a partir de qualquer página, não necessariamente da página inicial. A seleção do ponto de entrada de rastreamento depende da origem de um link de entrada. Digamos que algumas de suas páginas de produtos tenham muitos links provenientes de vários sites. O Google liga os pontos e visita essas páginas populares no primeiro turno.

Um sitemap XML é uma ótima ferramenta para construir uma estrutura de site bem pensada. Além disso, pode tornar o processo de rastreamento de sites mais direcionado e inteligente.

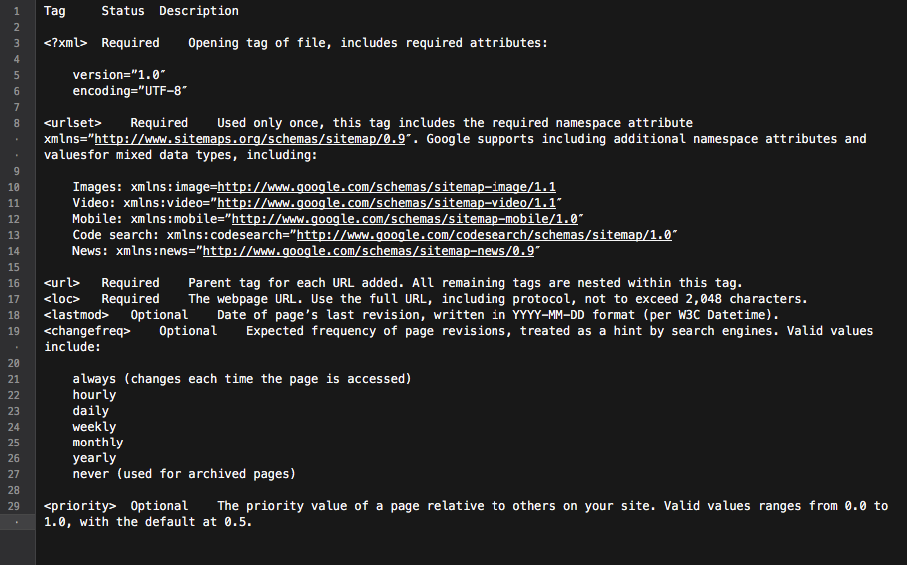

Basicamente, o mapa do site é um hub com todos os links do site. Cada link incluído nele pode ser equipado com algumas informações extras: a data da última atualização, a frequência de atualização, sua relação com outras URLs do site, etc.

Tudo isso fornece ao Googlebots um roteiro detalhado de rastreamento de sites e torna o rastreamento mais informado. Além disso, todos os principais mecanismos de pesquisa dão prioridade aos URLs listados em um mapa do site.

Tudo isso fornece ao Googlebots um roteiro detalhado de rastreamento de sites e torna o rastreamento mais informado. Além disso, todos os principais mecanismos de pesquisa dão prioridade aos URLs listados em um mapa do site.

Resumindo, para colocar as páginas do seu site no radar do Googlebot, você precisa construir um site com ótimo conteúdo e otimizar sua estrutura de links internos.

Aprendizado

• O Google não rastreia automaticamente todos os seus sites.

• A periodicidade do rastreamento do site depende de quão importante ou popular o site e suas páginas são.

• A atualização de conteúdo faz com que o Google visite um site com mais frequência.

• Os sites que não correspondem aos requisitos do mecanismo de pesquisa provavelmente não serão rastreados corretamente.

• Websites e páginas de sites que não possuem links internos/externos são geralmente ignorados pelos robôs do mecanismo de busca.

• Adicionar um sitemap XML pode melhorar o processo de rastreamento do site e torná-lo mais inteligente.

Mito 2. Adicionar um sitemap XML é a melhor maneira de obter todas as páginas do site rastreadas e indexadas.

Todo proprietário de site deseja que o Googlebot visite todas as páginas importantes do site (exceto aquelas ocultas da indexação), além de explorar instantaneamente conteúdo novo e atualizado.

No entanto, o mecanismo de pesquisa tem sua própria visão das prioridades de rastreamento do site.

Quando se trata de verificar um site e seu conteúdo, o Google usa um conjunto de algoritmos chamado orçamento de rastreamento. Basicamente, ele permite que o mecanismo de pesquisa verifique as páginas do site, enquanto usa seus próprios recursos.

Como verificar um orçamento de rastreamento de site

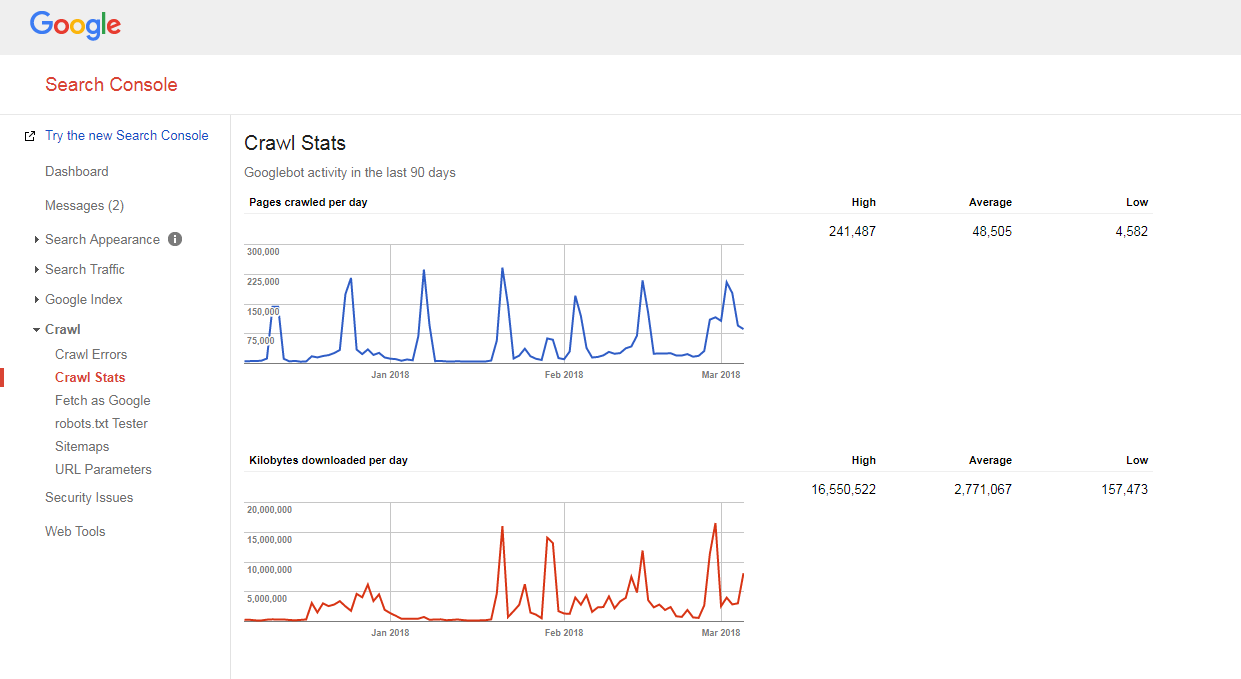

É muito fácil descobrir como seu site está sendo rastreado e se você tem algum problema de orçamento de rastreamento.

Você só precisa:

- contar o número de páginas em seu site e em seu sitemap XML,

- visite o Google Search Console, vá para a seção Rastreamento -> Estatísticas de rastreamento e verifique quantas páginas são rastreadas em seu site diariamente,

- divida o número total de páginas do seu site pelo número de páginas rastreadas por dia.

Se o número que você obteve for maior que 10 (há 10 vezes mais páginas em seu site do que o Google rastreia diariamente), temos más notícias para você: seu site tem problemas de rastreamento.

Se o número que você obteve for maior que 10 (há 10 vezes mais páginas em seu site do que o Google rastreia diariamente), temos más notícias para você: seu site tem problemas de rastreamento.

Mas antes de aprender como consertá-los, você precisa entender outra noção, que é…

Profundidade do rastreamento

A profundidade do rastreamento é a extensão em que o Google continua explorando um site até um determinado nível.

Geralmente, a página inicial é considerada como nível 1, uma página que está a 1 clique de distância é nível 2, etc.

As páginas de nível profundo têm um Pagerank mais baixo (ou não o têm) e são menos propensas a serem rastreadas pelo Googlebot. Normalmente, o mecanismo de pesquisa não aprofunda mais do que o nível 4.

No cenário ideal, uma página específica deve estar a 1-4 cliques de distância da página inicial ou das principais categorias do site. Quanto maior o caminho para essa página, mais recursos os mecanismos de pesquisa precisam alocar para alcançá-la.

Se estiver em um site, o Google estima que o caminho é muito longo, ele interrompe o rastreamento.

Otimizando a profundidade e o orçamento do rastreamento

Para evitar que o Googlebot fique lento, otimize o orçamento e a profundidade do rastreamento do seu site, você precisa:

- corrigir todos os erros 404, JS e outros de página;

Uma quantidade excessiva de erros de página pode diminuir significativamente a velocidade do rastreador do Google. Para encontrar todos os principais erros do site, faça login no painel de Ferramentas do Google para webmasters do Google (Bing, Yandex) e siga todas as instruções fornecidas aqui.

- otimizar a paginação;

Caso você tenha listas de paginação muito longas ou seu esquema de paginação não permita clicar mais do que algumas páginas na lista, o rastreador do mecanismo de pesquisa provavelmente irá parar de escavar uma pilha de páginas.

Além disso, se houver poucos itens por essa página, ela poderá ser considerada de conteúdo fino e não será rastreada.

- verifique os filtros de navegação;

Alguns esquemas de navegação podem vir com vários filtros que geram novas páginas (por exemplo, páginas filtradas por navegação em camadas). Embora essas páginas possam ter potencial de tráfego orgânico, elas também podem criar carga indesejada nos rastreadores do mecanismo de pesquisa.

A melhor maneira de resolver isso é limitar os links sistemáticos às listas filtradas. Idealmente, você deve usar 1-2 filtros no máximo. Por exemplo, se você tiver uma loja com 3 filtros LN (cor/tamanho/gênero), você deve permitir a combinação sistemática de apenas 2 filtros (por exemplo, tamanho da cor, tamanho do gênero). Caso você precise adicionar combinações de mais filtros, você deve adicionar links manualmente para eles.

- Otimize os parâmetros de rastreamento em URLs;

Vários parâmetros de rastreamento de URL (por exemplo, '?source=thispage') podem criar armadilhas para os rastreadores, pois geram uma grande quantidade de novos URLs. Esse problema é típico de páginas com blocos de “produtos semelhantes” ou “histórias relacionadas”, onde esses parâmetros são usados para rastrear o comportamento dos usuários.

Para otimizar a eficiência do rastreamento nesse caso, é recomendável transmitir as informações de rastreamento por trás de um '#' no final do URL. Dessa forma, esse URL permanecerá inalterado. Além disso, também é possível redirecionar URLs com parâmetros de rastreamento para os mesmos URLs, mas sem rastreamento.

- remover redirecionamentos 301 excessivos;

Digamos que você tenha um grande pedaço de URLs vinculados sem uma barra final. Quando o bot do mecanismo de pesquisa visita essas páginas, ele é redirecionado para a versão com uma barra.

Assim, o bot precisa fazer o dobro do que deveria e, eventualmente, pode desistir e parar de rastrear. Para evitar isso, tente atualizar todos os links do seu site sempre que alterar os URLs.

Prioridade de rastreamento

Como dito acima, o Google prioriza o rastreamento de sites. Portanto, não é de admirar que faça o mesmo com as páginas de um site rastreado.

Para a maioria dos sites, a página com maior prioridade de rastreamento é a página inicial.

No entanto, como dito anteriormente, em alguns casos, essa também pode ser a categoria mais popular ou a página de produto mais visitada. Para encontrar as páginas que recebem um número maior de rastreamentos do Googlebot, basta verificar os registros do seu servidor.

Embora o Google não anuncie oficialmente que os fatores que podem influenciar a prioridade de rastreamento de uma página do site são:

- inclusão em um mapa do site XML (e adicione as tags de prioridade* para as páginas mais importantes),

- o número de links de entrada,

- o número de links internos,

- popularidade da página (nº de visitas),

- Ranking da página.

Mas mesmo depois de abrir o caminho para os bots do mecanismo de pesquisa rastrearem seu site, eles ainda podem ignorá-lo. Leia para saber o porquê.

Para entender melhor como rastrear a prioridade, assista a esta palestra virtual de Gary Illyes.

Falando sobre as tags de prioridade em um sitemap XML, elas podem ser adicionadas manualmente ou com a ajuda da funcionalidade integrada da plataforma na qual seu site é baseado. Além disso, algumas plataformas oferecem suporte a extensões/aplicativos de sitemap XML de terceiros que simplificam o processo.

Usando a tag de prioridade do mapa do site XML, você pode atribuir os seguintes valores a diferentes categorias de páginas do site:

- 0.0-0.3 para páginas utilitárias, conteúdo desatualizado e quaisquer páginas de menor importância,

- 0.4-0.7 aos artigos do seu blog, perguntas frequentes e páginas de conhecimento, páginas de categoria e subcategoria de importância secundária e

- 0.8-1.0 para as categorias principais do seu site, principais páginas de destino e a página inicial.

Aprendizado

• O Google tem sua própria visão sobre as prioridades do processo de rastreamento.

• Uma página que deve entrar no índice do mecanismo de pesquisa deve estar a 1-4 cliques da página inicial, das principais categorias do site ou das páginas mais populares do site.

• Para evitar que o Googlebot reduza a velocidade e otimize o orçamento e a profundidade do rastreamento do site, você deve encontrar e corrigir erros 404, JS e outros erros de página, otimizar a paginação do site e os filtros de navegação, remover redirecionamentos 301 excessivos e otimizar os parâmetros de rastreamento em URLs.

• Para aumentar a prioridade de rastreamento de uma página importante do site, certifique-se de que eles estejam incluídos em um mapa do site XML (com tags de prioridade) e bem vinculados a outras páginas do site, tenham links provenientes de outros sites relevantes e confiáveis.

Mito 3. Um sitemap XML pode resolver todos os problemas de rastreamento e indexação.

Embora seja uma boa ferramenta de comunicação que alerta o Google sobre os URLs do seu site e as formas de alcançá-los, um sitemap XML NÃO garante que seu site será visitado pelos bots do mecanismo de pesquisa (para não falar da inclusão de todas as páginas do site no Índice) .

Além disso, você deve entender que os sitemaps não o ajudarão a melhorar as classificações do seu site. Mesmo que uma página seja rastreada e incluída no índice do mecanismo de pesquisa, seu desempenho de classificação depende de vários outros fatores (links internos e externos, conteúdo, qualidade do site etc.).

No entanto, quando usado corretamente, um sitemap XML pode melhorar significativamente a eficiência do rastreamento do site. Abaixo estão alguns conselhos sobre como maximizar o potencial de SEO desta ferramenta.

Ser consistente

Ao criar um sitemap, lembre-se de que ele será usado como um roteiro para os rastreadores do Google. Portanto, é importante não enganar o mecanismo de pesquisa fornecendo as direções erradas.

Por exemplo, você pode ocasionalmente incluir em seu sitemap XML algumas páginas de utilitários ( Fale Conosco ou páginas TOS, páginas para login, página de recuperação de senha perdida, páginas para compartilhamento de conteúdo , etc.).

Essas páginas geralmente ficam ocultas da indexação com metatags robots noindex ou não são permitidas no arquivo robots.txt.

Portanto, incluí-los em um sitemap XML só confundirá os Googlebots, o que pode influenciar negativamente o processo de coleta de informações sobre seu site.

Atualize regularmente

A maioria dos sites na Web muda quase todos os dias. Especialmente o site de comércio eletrônico com produtos e categorias entrando e saindo regularmente do site.

Para manter o Google bem informado, você precisa manter seu sitemap XML atualizado.

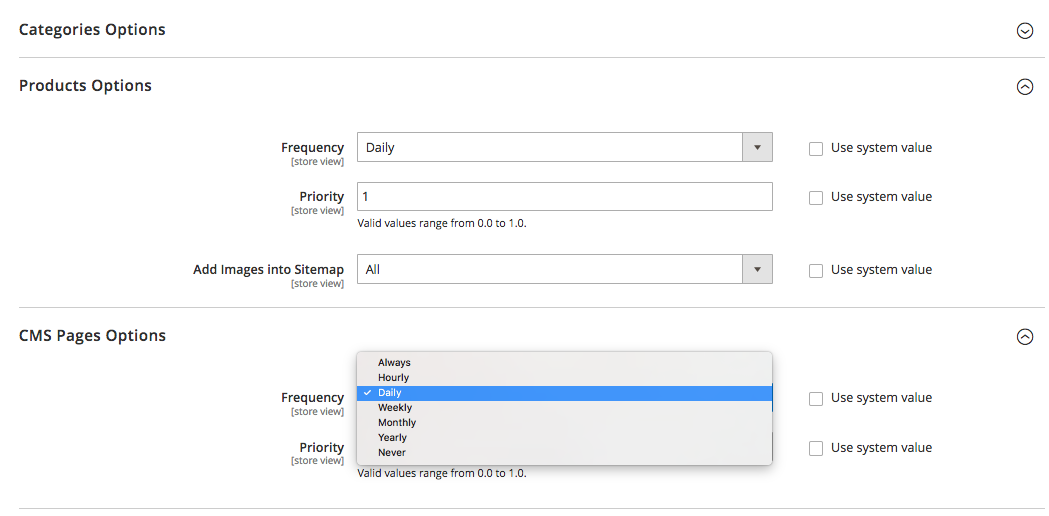

Algumas plataformas (Magento, Shopify) possuem funcionalidades integradas que permitem atualizar periodicamente seus mapas de site XML ou oferecem suporte a algumas soluções de terceiros que são capazes de realizar essa tarefa.

Por exemplo, no Magento 2, você pode determinar a periodicidade dos ciclos de atualização do sitemap. Ao defini-lo nas configurações da plataforma, você sinaliza ao rastreador que as páginas do seu site são atualizadas em um determinado intervalo de tempo (por hora, semanalmente, mensalmente) e seu site precisa de outro rastreamento.

Clique aqui para saber mais sobre ele.

Mas lembre-se de que, embora a definição de prioridade e frequência para atualizações do sitemap ajude, elas podem não acompanhar as mudanças reais e às vezes não fornecer uma imagem verdadeira.

É por isso que certifique-se de que seu sitemap reflita todas as alterações feitas recentemente.

Segmente o conteúdo do site e defina as prioridades de rastreamento corretas

Segmente o conteúdo do site e defina as prioridades de rastreamento corretas

O Google está trabalhando duro para medir a qualidade geral do site e exibir apenas os melhores e mais relevantes sites.

Mas, como muitas vezes acontece, nem todos os sites são criados iguais e capazes de entregar valor real.

Digamos, um site pode consistir em 1.000 páginas, e apenas 50 delas são de nota «A». Os outros são puramente funcionais, têm conteúdo desatualizado ou nenhum conteúdo.

Se o Google começar a explorar um site assim, provavelmente decidirá que é bastante inútil devido à alta porcentagem de páginas de baixo valor, spam ou desatualizadas.

É por isso que, ao criar um sitemap XML, é aconselhável segmentar o conteúdo do site e guiar os bots do mecanismo de pesquisa apenas para as áreas do site dignas.

E como você deve se lembrar, as tags Priority, atribuídas às páginas mais importantes do site em seu sitemap XML, também podem ser de grande ajuda.

Aprendizado

• Ao criar um sitemap, certifique-se de não incluir páginas ocultas da indexação com metatags de robôs noindex ou não permitidas no arquivo robots.txt.

• Atualize os mapas do site XML (manualmente ou automaticamente) logo após fazer alterações na estrutura e no conteúdo do site.

• Segmente o conteúdo do seu site para incluir apenas páginas de grau «A» no mapa do site.

• Defina a prioridade de rastreamento para diferentes tipos de página.

É basicamente isso.

Tem algo a dizer sobre o tema? Sinta-se à vontade para compartilhar sua opinião sobre rastreamento, indexação ou sitemaps na seção de comentários abaixo.