A autoclassificação de postagens sociais melhoraria os principais problemas na moderação do discurso online?

Publicados: 2022-12-16A moderação de conteúdo é um tópico importante nos círculos de mídia social no momento, já que Elon Musk está reformando o Twitter, ao mesmo tempo em que publica ações de moderação anteriores, como uma ilustração de como os aplicativos de mídia social ganharam muito poder para controlar certas discussões.

Mas, apesar de Musk destacar as falhas percebidas no processo, a questão agora é: como consertar isso? Se as decisões de conteúdo não podem ser confiadas nas mãos de, efetivamente, pequenas equipes de executivos responsáveis pelas próprias plataformas, qual é a alternativa?

A experiência da Meta com um painel de especialistas externos foi, em geral, um sucesso, mas mesmo assim, seu Conselho de Supervisão não pode julgar todas as decisões de conteúdo, e a Meta ainda sofre fortes críticas por censura e preconceito percebidos, apesar desses meios alternativos. de apelação.

Em algum nível, algum elemento da tomada de decisão inevitavelmente recairá sobre o gerenciamento da plataforma, a menos que outro caminho possa ser concebido.

Os feeds alternativos, baseados em preferências pessoais, podem ser outra maneira de lidar com isso?

Algumas plataformas estão analisando isso. Conforme relatado pelo The Washington Post, o TikTok está atualmente explorando um conceito que está chamando de 'Níveis de conteúdo', em um esforço para impedir que o conteúdo 'maduro' apareça nos feeds dos espectadores mais jovens.

O TikTok está sob crescente escrutínio nessa frente, principalmente no que diz respeito às tendências de desafios perigosos, que levaram alguns jovens a serem mortos como resultado da participação em atos arriscados.

Elon Musk também divulgou uma abordagem de controle de conteúdo semelhante como parte de sua visão mais ampla para o 'Twitter 2.0'.

Bom ponto.

— Elon Musk (@elonmusk) 29 de outubro de 2022

Ser capaz de selecionar qual versão do Twitter você deseja provavelmente é melhor, assim como seria para a classificação de maturidade de um filme.

A classificação do tweet em si pode ser selecionada automaticamente e depois modificada pelo feedback do usuário.

Na variação de Musk, os usuários autoclassificariam seus tweets à medida que os carregassem, com os leitores também podendo aplicar sua própria classificação de maturidade, de certa forma, para ajudar a mudar o conteúdo potencialmente prejudicial para uma categoria separada.

O resultado final em ambos os casos significaria que os usuários seriam capazes de selecionar diferentes níveis de experiência no aplicativo – de 'seguro', que filtraria os comentários e discussões mais extremos, a 'não filtrado' (Musk provavelmente iria com 'hardcore'), o que lhe daria a experiência completa.

O que parece interessante, em teoria - mas, na realidade, os usuários realmente autoclassificariam seus tweets e obteriam essas classificações corretas com frequência suficiente para torná-lo uma opção viável para esse tipo de filtragem?

Obviamente, a plataforma pode implementar punições por não classificar ou não classificar seus tweets corretamente. Talvez, para infratores reincidentes, todos os seus tweets sejam filtrados automaticamente para a segmentação mais extrema, enquanto outros podem obter o alcance máximo do público tendo seu conteúdo exibido em ambos ou em todos os fluxos.

Isso exigiria mais trabalho manual para os usuários, na seleção de uma classificação dentro do processo de composição, mas talvez isso pudesse aliviar algumas preocupações?

Mas, novamente, isso ainda não impediria que as plataformas sociais fossem usadas para amplificar o discurso de ódio e alimentar movimentos perigosos.

Na maioria dos casos em que o Twitter ou outros aplicativos sociais foram movidos para censurar os usuários, foi por causa da ameaça de danos, não porque as pessoas ficaram necessariamente ofendidas com os comentários feitos.

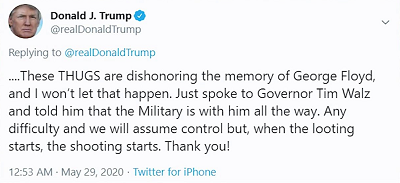

Por exemplo, quando o ex-presidente Donald Trump postou:

A preocupação não era tanto que as pessoas ficassem ofendidas com seu comentário 'quando o saque começa, o tiroteio começa', a preocupação era mais que os apoiadores de Trump pudessem entender isso como, essencialmente, uma licença para matar, com o presidente efetivamente endossando o uso de força letal para deter saqueadores.

As plataformas sociais, logicamente, não querem que suas ferramentas sejam usadas para espalhar danos potenciais dessa maneira e, a esse respeito, a autocensura ou a seleção de uma classificação de maturidade para suas postagens não resolverá esse problema-chave, apenas oculte esses comentários dos usuários que optam por não vê-los.

Em outras palavras, é mais ofuscação do que segurança aprimorada - mas muitos parecem acreditar que o problema central não é que as pessoas estão dizendo e querem dizer essas coisas online, mas que outras pessoas se ofendem com isso.

Esse não é o problema e, embora ocultar material potencialmente ofensivo possa ter algum valor na redução da exposição, principalmente, no caso do TikTok, para o público mais jovem, ainda não impedirá as pessoas de usar o potencial de alcance maciço dos aplicativos sociais para espalhar o ódio e chamadas de ação perigosas, que podem de fato levar a danos no mundo real.

Em essência, é uma oferta fragmentada, uma diluição de responsabilidade que terá algum impacto, em alguns casos, mas não abordará a responsabilidade principal das plataformas sociais de garantir que as ferramentas e sistemas que criaram não sejam usados para fins perigosos propósito.

Porque são, e continuarão a ser. As plataformas sociais têm sido usadas para alimentar distúrbios civis, levantes políticos, motins, golpes militares e muito mais.

Ainda nesta semana, uma nova ação legal foi lançada contra a Meta por permitir que ' postagens violentas e odiosas na Etiópia floresçam no Facebook, inflamando a sangrenta guerra civil do país '. O processo está processando $ 2 bilhões em danos para as vítimas da violência resultante.

Não se trata apenas de opiniões políticas das quais você discorda, as plataformas de mídia social podem ser usadas para alimentar movimentos reais e perigosos.

Nesses casos, nenhuma autocertificação provavelmente ajudará – sempre haverá algum ônus nas plataformas para definir as regras, a fim de garantir que esses tipos de cenários de pior caso sejam resolvidos.

Isso, ou as regras precisam ser definidas em um nível superior, por governos e agências destinadas a medir o impacto disso e agir de acordo.

Mas, no final, a questão central aqui não é sobre as plataformas sociais permitirem que as pessoas digam o que quiserem e compartilhem o que quiserem, como muitos defensores da 'liberdade de expressão' estão defendendo. Em algum nível, sempre haverá limites, sempre haverá grades de proteção e, às vezes, podem muito bem se estender para além das leis da terra, dado o potencial de ampliação dos postos sociais.

Não há respostas fáceis, mas deixar isso a cargo da vontade das pessoas provavelmente não resultará em uma situação melhor em todas as frentes.