Co to jest drapanie stron internetowych i jak to zrobić?

Opublikowany: 2022-06-04Spis treści

- Co to jest zbieranie stron internetowych?

- Dlaczego potrzebujesz skrobania stron internetowych?

- Jak działa web scraping?

- Jakie są najlepsze praktyki związane ze skrobaniem stron internetowych?

- 5 najlepszych narzędzi do skrobania sieci

- Ciesz się skrobaniem sieci… z ostrożnością!

Jeśli obecnie nie korzystasz ze skrobania sieci w ramach swojego arsenału, zdecydowanie pomijasz ogromną szansę na zdobycie przewagi nad konkurencją.

Jeśli jesteś jak większość sprzedawców, zawsze szukasz przewagi nad konkurencją. Chcesz znaleźć nowych leadów, wzmocnić relacje z obecnymi klientami i lepiej zrozumieć swoją branżę jako całość.

Skrobanie stron internetowych może pomóc w wykonaniu wszystkich tych rzeczy i nie tylko. Pomyśl o wszystkich przypadkach, kiedy chciałeś otrzymać listę wszystkich firm z Twojej branży, które znajdują się w określonym mieście. A może chciałeś otrzymać listę wszystkich kontaktów w danej firmie.

Web scraping może pomóc w szybkim i łatwym uzyskaniu tych informacji. Ale co to jest i jak działa? W tym poście na blogu odpowiemy na te pytania i nie tylko. Czytaj dalej, aby dowiedzieć się wszystkiego, co musisz wiedzieć o tym potężnym narzędziu!

Co to jest zbieranie stron internetowych?

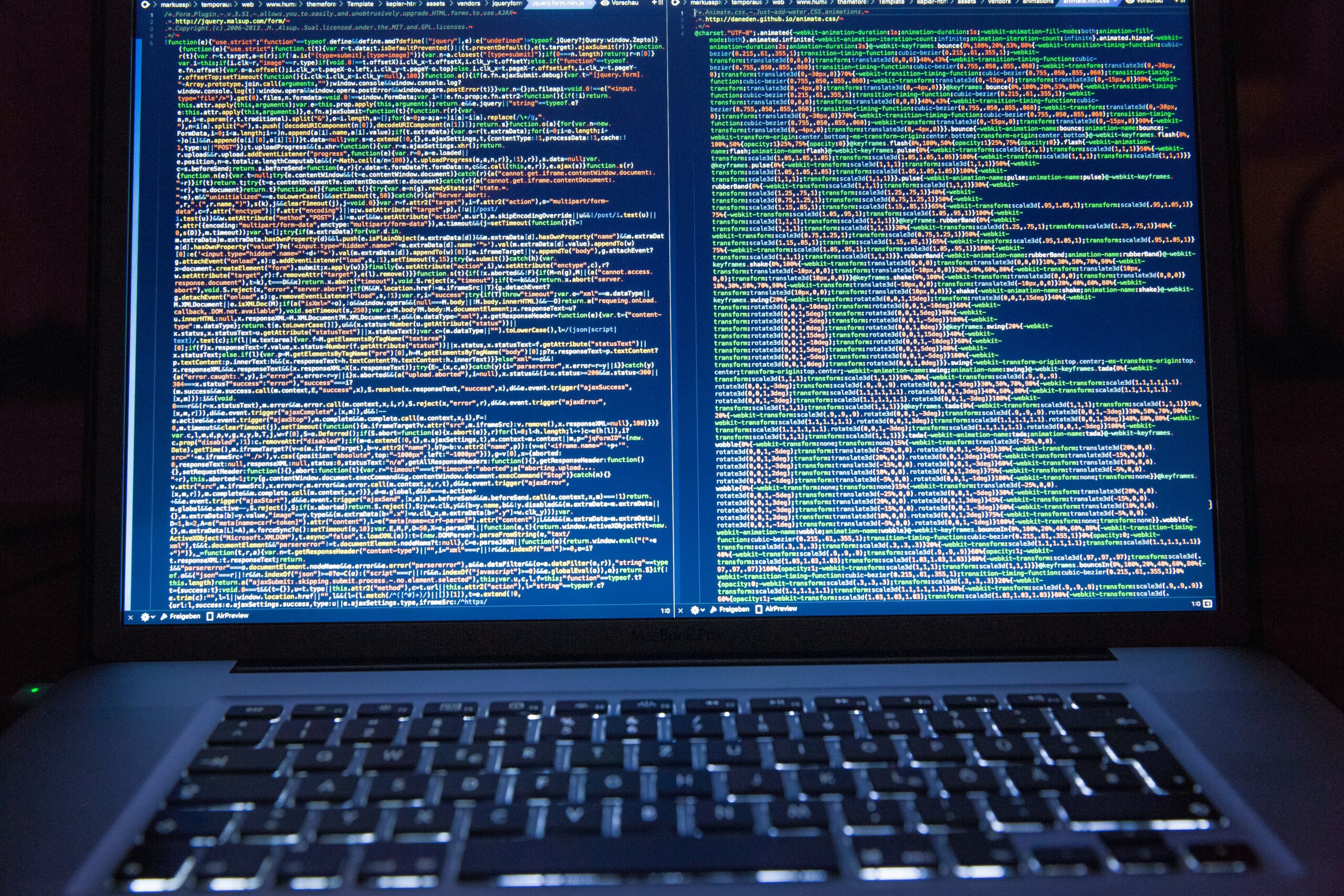

Wyobraź sobie, że musiałeś patrzeć na coś takiego przez cały dzień. Zabawne, prawda…?

Teraz wyobraź sobie, że istnieje sposób na posortowanie wszystkich tych danych w ciągu kilku sekund, aby uzyskać uporządkowany zestaw. Na tym polega skrobanie danych.

W skrócie, web scraping to sposób na wyodrębnienie danych ze stron internetowych. Zwykle odbywa się to automatycznie przez komputery, ale można to również zrobić ręcznie.

Można to zrobić na kilka różnych sposobów, ale podstawową ideą jest załadowanie strony internetowej, a następnie przeanalizowanie kodu HTML w celu znalezienia żądanych danych. Po znalezieniu żądanych danych możesz zapisać je w pliku lub bazie danych do późniejszego wykorzystania.

Web scraping może być przydatny do wielu różnych zadań, takich jak uzyskanie listy wszystkich nazw produktów i cen ze sklepu internetowego lub wyodrębnienie danych z forum internetowego, aby zobaczyć, co ludzie mówią na określony temat.

Czy skrobanie stron internetowych jest bezpłatne?

Większość narzędzi do skrobania stron internetowych jest bezpłatna, chociaż istnieją pewne płatne opcje. Płatne opcje zwykle oferują więcej funkcji i są łatwiejsze w użyciu, ale bezpłatne opcje zazwyczaj dobrze wykonają zadanie.

Szybka wskazówka

Czy web scraping jest legalny?

To najczęściej zadawane pytanie, a odpowiedź brzmi… to zależy. Ogólnie rzecz biorąc, zbieranie publicznych danych ze stron internetowych jest całkowicie w porządku. Jeśli jednak zbierasz dane, które mają być prywatne (takie jak czyjeś dane kontaktowe), możesz mieć problemy prawne.

To częste pytanie, a odpowiedź brzmi… to zależy. Ogólnie rzecz biorąc, zbieranie publicznych danych ze stron internetowych jest całkowicie w porządku. Jeśli jednak zbierasz dane, które mają być prywatne (takie jak czyjeś dane kontaktowe), możesz mieć problemy prawne.

Zawsze dobrze jest sprawdzić warunki korzystania z witryny, którą przeglądasz, aby upewnić się, że nie naruszasz żadnych zasad.

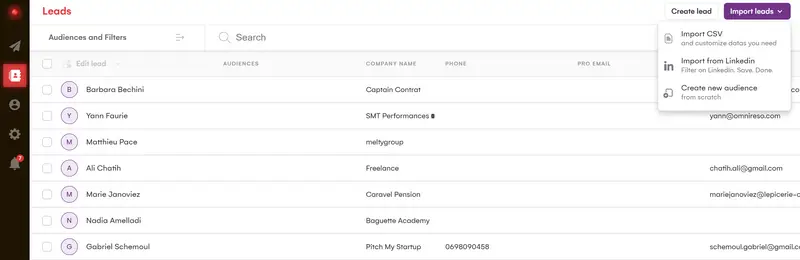

W LaGrowthMachine opracowaliśmy własne metody skrobania przy użyciu kilku źródeł danych i różnych technologii, co pozwala nam mieć jedną z najlepszych funkcji wzbogacania danych na rynku.

Odzyskujemy do 28 różnych pozycji danych z naszych leadów (zawsze zgodnie z podejściem przyjaznym dla RGPD), co pozwoli Ci zautomatyzować według bardzo precyzyjnych zmiennych i będzie bardzo naturalne w swoim podejściu.

Chociaż praktyka ta nie jest nowa, ma tendencję do stawania się bardziej powszechna i bardziej rozległa.

Stał się podstawowym atutem dla marketerów wzrostu i MŚP, którzy chcą połączyć wydajność i reaktywność.

Ok, więc o to chodzi w tym zamieszaniu, ale w jaki sposób web scraping faktycznie przynosi korzyści Twojej firmie?

Dlaczego potrzebujesz skrobania stron internetowych?

Najbardziej oczywistą zaletą web scrapingu jest to, że może zaoszczędzić dużo czasu.

Wyobraź sobie, że za każdym razem, gdy chcesz przeprowadzić badania rynkowe, musisz ręcznie kopiować i wklejać dane ze stron internetowych. Zajęłoby to wieczność! Ale dzięki web scrapingowi możesz uzyskać wszystkie potrzebne dane w ciągu zaledwie kilku minut.

Kolejną dużą zaletą jest to, że może pomóc w uzyskaniu danych, których uzyskanie w inny sposób byłoby trudne lub niemożliwe. Na przykład, jeśli chcesz zbadać nowy rynek, web scraping może pomóc Ci szybko i łatwo uzyskać listę wszystkich firm na tym rynku.

Co więcej, web scraping może być używany do różnych zadań, niektóre z najczęstszych zastosowań to:

- Generowanie leadów: Pozyskiwanie danych ze stron internetowych może być świetnym sposobem na znalezienie nowych leadów. Na przykład możesz zeskrobać dane z katalogu firm, aby znaleźć wszystkie firmy z Twojej branży, które znajdują się w określonym mieście.

- Badanie rynku: Web scraping może być używany do zbierania danych o określonej branży lub rynku. Dane te można następnie przeanalizować, aby lepiej zrozumieć rynek jako całość.

- Analiza konkurencji: Monitorowanie konkurencji jest ważne w każdej firmie. Zbierając dane z ich witryn internetowych, możesz lepiej zrozumieć ich produkty, ceny i strategie marketingowe.

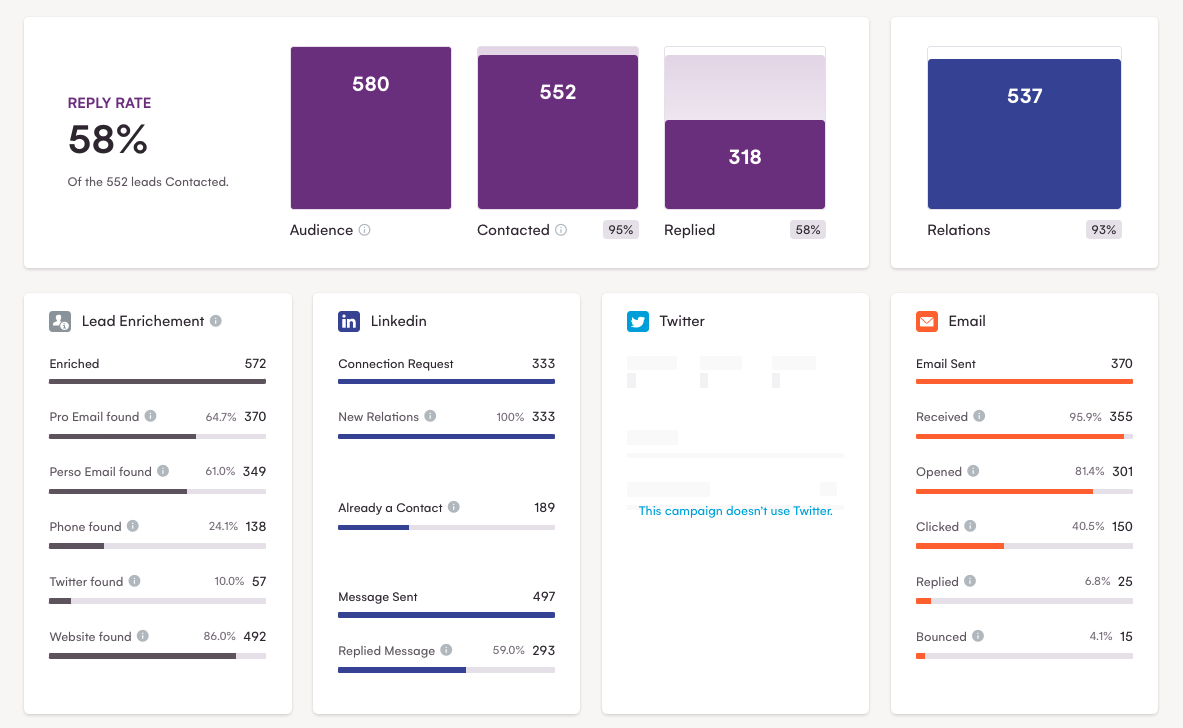

Idąc dalej, dzięki zebranym danym możesz skonfigurować wielokanałowe kampanie w LaGrowthMachine.

Jak widać, ta metoda jest bardzo skuteczna, z prawie 60% odsetkiem odpowiedzi!

Teraz, gdy wprowadziliśmy Cię do web scrapingu i pokazaliśmy niektóre z jego zalet, przyjrzyjmy się podstawom jego działania.

Jak działa web scraping?

Skrobanie stron internetowych jest zwykle wykonywane automatycznie przez komputery, ale można je również wykonać ręcznie.

Można to zrobić na kilka różnych sposobów, ale podstawową ideą jest załadowanie strony internetowej, a następnie przeanalizowanie kodu HTML w celu znalezienia żądanych danych. Po znalezieniu żądanych danych możesz wyodrębnić je do pliku lub bazy danych w celu późniejszego wykorzystania.

Załóżmy na przykład, że chcesz pobrać dane ze sklepu internetowego, aby uzyskać listę wszystkich nazw produktów i cen.

Najpierw musisz znaleźć i załadować stronę internetową, którą chcesz zeskrobać.

Następnie musisz napisać kod, który przeanalizuje kod HTML strony internetowej i wyodrębni dane, które Cię interesują.

Na koniec musisz zapisać dane do pliku lub bazy danych.

Web scraping można wykonać w różnych językach programowania, ale najpopularniejsze z nich to Python, Java i PHP.

Jeśli dopiero zaczynasz pracę z web scrapingiem, zalecamy użycie narzędzia takiego jak ParseHub lub Scrapy. Narzędzia te ułatwiają zbieranie danych z witryn internetowych bez konieczności pisania kodu.

Jakie są najlepsze praktyki związane ze skrobaniem stron internetowych?

Teraz, gdy znasz już podstawy skrobania sieci, przyjrzyjmy się kilku najlepszym praktykom, o których warto pamiętać.

Sprawdź warunki korzystania z usługi

Jak wspomnieliśmy wcześniej, musisz sprawdzić warunki usługi dla witryny, którą zgarniasz. Zapewni to, że nie łamiesz żadnych zasad i unikniesz potencjalnych problemów – prawnych lub innych – w przyszłości. Dobrym pomysłem jest również uzyskanie zgody właściciela witryny przed zeskrobaniem witryny, ponieważ niektórzy webmasterzy mogą nie być z tego powodu zbyt zadowoleni.

Użyj odpowiednich narzędzi

Dostępnych jest wiele różnych narzędzi do skrobania stron internetowych, dlatego ważne jest, aby wybrać odpowiedni do swoich potrzeb.

A skoro o tym mowa, LaGrowthMachine jest jednym z nich!

W dalszej części tego przewodnika omówimy listę najlepszych narzędzi do skrobania stron internetowych, ale ze względu na ten punkt wymienimy tylko kilka najpopularniejszych:

- Scrapy: Scrapy to framework do zgarniania stron internetowych napisany w Pythonie. Jest to jedno z najpopularniejszych dostępnych narzędzi i jest używane przez wielkie nazwiska, takie jak Google, Yahoo i Facebook.

- ParseHub: ParseHub to skrobak sieciowy, który obsługuje szeroką gamę języków i platform internetowych.

- Octoparse: Octoparse to kolejny skrobak sieciowy, który obsługuje zarówno statyczne, jak i dynamiczne strony internetowe.

Nie przeciążaj serwerów

Kiedy pobierasz dane ze stron internetowych, ważne jest, aby nie przeciążać ich serwerów zbyt dużą liczbą żądań. Może to prowadzić do zablokowania Twojego adresu IP na stronie. Aby tego uniknąć, pamiętaj o rozmieszczeniu próśb i nie rób zbyt wielu na raz.

Postępuj z błędami z wdziękiem

Nieuniknione jest, że w pewnym momencie natkniesz się na błędy. Niezależnie od tego, czy jest to witryna, która nie działa, czy dane, które nie są w oczekiwanym formacie, podczas rozwiązywania tych błędów należy zachować cierpliwość i delikatność. Nie chcesz ryzykować złamania czegokolwiek, bo za bardzo się spieszysz.

Regularnie przeglądaj swoje dane

Ważne jest, aby regularnie przeglądać swoje dane. Czasami strony internetowe zmieniają się, a wyodrębniane dane mogą nie być już dokładne. Regularne przeglądanie danych pomoże zapewnić, że zawsze otrzymujesz dokładne informacje.

Zdrapuj odpowiedzialnie

Ważne jest, aby szanować witryny, które zbierasz. Oznacza to, że nie należy skrobać zbyt dużej ilości danych, nie skrobać zbyt często i nie skrobać poufnych danych. Upewnij się również, że Twój skrobak jest aktualny, aby przypadkowo nie zepsuł żadnej witryny, którą zeskrobujesz.

Wiedz, kiedy przestać

Będą chwile, kiedy nie będziesz w stanie uzyskać żądanych danych ze strony internetowej. Kiedy tak się dzieje, ważne jest, aby wiedzieć, kiedy się zatrzymać i przejść dalej. Nie marnuj czasu, próbując zmusić swojego web scrapera do pracy – istnieją inne strony internetowe z potrzebnymi danymi.

To tylko kilka z najlepszych praktyk, o których należy pamiętać podczas ekstrakcji danych. Przestrzeganie tych wskazówek pomoże zapewnić pozytywne doświadczenia i uniknąć potencjalnych problemów.

5 najlepszych narzędzi do skrobania sieci

Jak wspomnieliśmy wcześniej, dostępnych jest wiele skrobaków internetowych, od złożonych frameworków po proste narzędzia. W tej sekcji omówimy kilka najpopularniejszych narzędzi do skrobania.

Teraz… wspomnieliśmy już o podstawowych narzędziach, takich jak Scrapy i ParseHub, więc szybko omówimy kilka innych.

Pyton

Python jest jednym z najbardziej oczywistych wyborów dla Twoich potrzeb związanych ze skrobaniem sieci. Jest to wszechstronny język skryptowy, który można wykorzystać do… skrobania danych, a także do wielu innych zadań.

Główną zaletą korzystania z oprogramowania do skrobania sieci w Pythonie jest to, że jest stosunkowo łatwe do nauczenia się i używania.

Dodatkowo Python ma szeroką gamę bibliotek i modułów, które można wykorzystać do ekstrakcji danych internetowych, co czyni go niezwykle potężnym narzędziem.

Jedną wadą jest to, że web scrapery Pythona mogą być powolne, szczególnie jeśli próbują zeskrobać duże ilości danych.

Ponadto niektóre strony internetowe mogą blokować jego dostęp, co oznacza, że często web scraping za pomocą Pythona może być bardziej czasochłonny i trudniejszy niż użycie innych narzędzi do web scrapingu.

Ogólnie rzecz biorąc, wyodrębnianie danych z sieci za pomocą Pythona ma zarówno zalety, jak i wady, ale pozostaje popularnym wyborem dla wielu osób, które chcą pobierać dane z sieci.

Import.io

Jest to narzędzie do wyodrębniania danych internetowych, które umożliwia zbieranie danych ze stron internetowych bez konieczności pisania kodu. Jest to jedno z najbardziej przyjaznych dla użytkownika narzędzi do skrobania stron internetowych i bonus: jest świetny dla początkujących!

Zawiera niesamowite funkcje, takie jak:

- Przyjazny dla użytkownika interfejs typu „wskaż i kliknij”

- Możliwość zeskrobywania danych zza loginu

- Automatyczna rotacja adresów IP, aby uniknąć zbanowania

Tym, co sprawia, że import.io jest tak świetny, jest to, że może zbierać dane z wielu stron w witrynie. Jest to przydatne, jeśli chcesz pobrać dane z dużej witryny z wieloma stronami. Oznacza to jednak również, że pobieranie danych z witryn zawierających mnóstwo stron może być powolne.

Kolejną zaletą import.io jest to, że może zeskrobać dane ze stron internetowych, które są „trudne” do zeskrobania: co oznacza, że może ominąć niektóre mechanizmy ochrony używane przez strony internetowe w celu zapobiegania zeskrobaniu. To powiedziawszy, istnieje ryzyko, że narzędzie się zepsuje, gdy strony zmienią swoje mechanizmy ochrony.

Ogólnie rzecz biorąc, import.io to świetne narzędzie do szybkiego zbierania danych z sieci, ale ważne jest, aby zdawać sobie sprawę z jego ograniczeń.

Mozenda

Mozenda to kolejne narzędzie do skrobania stron internetowych, które nie wymaga żadnego kodowania. Zawiera funkcje, takie jak renderowanie stron internetowych, indeksowanie stron internetowych i ekstrakcja danych.

To świetne rozwiązanie, ponieważ jest łatwe w użyciu i można je skonfigurować tak, aby pobierało dane z prawie każdej witryny.

Jedną z głównych zalet korzystania z Mozendy jest to, że jest bardzo szybka i wydajna. Bardzo szybko i łatwo radzi sobie z dużymi ilościami danych.

Ponadto jest bardzo przyjazny dla użytkownika. Interfejs użytkownika jest intuicyjny i łatwy w użyciu. Dostępna jest również szeroka gama zasobów online, które pomogą Ci rozpocząć pracę ze skrobaniem sieci za pomocą tego narzędzia.

Jednak jedną z głównych wad jest to, że jest dość drogi. Jeśli planujesz tylko skrobanie stron internetowych do użytku osobistego, Mozenda może nie być dla Ciebie najlepszą opcją.

To też nie zawsze działa idealnie. Czasami strony internetowe mogą zmienić swoją strukturę lub wygląd, co może powodować problemy ze skrobaniem stron internetowych.

Apify

Jako platforma do skrobania stron internetowych, Apify umożliwia przekształcanie stron internetowych w uporządkowane dane. Oferuje szeroki zakres funkcji, w tym możliwość zdrapywania dynamicznych stron internetowych, tworzenia interfejsów API i indeksowania całych witryn.

Chociaż Apify jest potężnym narzędziem, ma pewne ograniczenia:

Po pierwsze, nie jest darmowy, więc jeśli brakuje Ci gotówki, może to nie być dla Ciebie najlepsza opcja. Konfiguracja i użytkowanie mogą być również trudne, szczególnie dla użytkowników, którzy nie są zaznajomieni z web scrapingiem.

Tak czy inaczej, jest to jeden z najbardziej skalowalnych skrobaków internetowych, których możesz użyć. Platforma może obsługiwać zadrapania na dużą skalę, dzięki czemu jest idealna dla firm, które muszą gromadzić dane na dużą skalę.

Niemniej jednak ta skalowalność ma wadę; Ponieważ Apify może obsługiwać takie zadrapania na dużą skalę, może być bardziej podatny na błędy, a niektóre dane mogą zostać utracone podczas procesu zdrapywania.

Podsumowując, Apify pozostaje popularną platformą do skrobania sieci ze względu na swoją elastyczność i zakres funkcji. Jeśli szukasz łatwej w użyciu platformy do skrobania stron internetowych z szeroką gamą funkcji, Apify może być dla Ciebie dobrą opcją.

DiffBot

Diffbot to oprogramowanie do skrobania stron internetowych, które wykorzystuje sztuczną inteligencję do wyodrębniania danych ze stron internetowych. Oferuje szeroki zakres funkcji, w tym możliwość przeglądania stron internetowych na dużą skalę, indeksowania witryn internetowych i wyodrębniania danych ze stron internetowych JavaScript.

Główną zaletą korzystania z Diffbota jest to, że jest bardzo precyzyjny. Narzędzie jest w stanie wyodrębnić określone dane z dużą dokładnością, co oznacza mniejsze prawdopodobieństwo wystąpienia błędów podczas korzystania z narzędzia. Ma również możliwość zdrapywania danych z wielu stron i obsługi żądań AJAX, co zawsze jest plusem.

Co więcej, jest bardzo przyjazny dla użytkownika. Interfejs użytkownika jest intuicyjny i łatwy w użyciu, a dostępny jest szeroki zakres zasobów online, które pomogą Ci rozpocząć pracę z web scrapingiem za pomocą Diffbot.

Jednak jedną z największych wad Diffbota jest to, że jest dość drogi wraz z brakiem możliwości pobierania danych z witryn, które używają JavaScript do ładowania treści.

Co więcej, musi mieć również dobrze zorganizowaną witrynę internetową, aby mogła w pełni wykorzystać swój potencjał. Jeśli nie, proces zbierania danych może być dość powolny.

Ciesz się skrobaniem sieci… z ostrożnością!

Web scraping może być świetnym sposobem na zbieranie danych z sieci. Jest szybki, wydajny i stosunkowo łatwy do wykonania. Jest jednak kilka rzeczy, o których musisz wiedzieć, zanim zaczniesz skrobać w sieci.

Po pierwsze, w niektórych przypadkach skrobanie stron internetowych może być nielegalne. Jeśli planujesz skrobanie sieci w celach komercyjnych, musisz upewnić się, że masz do tego prawo .

Po drugie, web scraping może być wyzwaniem. Chociaż dostępnych jest wiele narzędzi do skrobania stron internetowych, które są dość przyjazne dla użytkownika i nie wymagają żadnego kodowania, niektóre strony internetowe mogą być trudniejsze do zeskrobania niż inne.

Wreszcie, skrobanie sieci może być czasochłonne. Jeśli planujesz skrobanie dużych witryn internetowych, uzyskanie wszystkich potrzebnych danych może zająć trochę czasu.

Niemniej jednak web scraping może być świetnym sposobem na szybkie i wydajne gromadzenie danych. Po prostu upewnij się, że jesteś świadomy ryzyka, zanim zaczniesz skrobać w sieci.

Miłego skrobania!