Właściwy sposób na Noindex strony

Opublikowany: 2022-12-02Może się to wydawać sprzeczne z intuicją, ale nie każda strona w Twojej witrynie powinna pojawiać się w wynikach wyszukiwania. Optymalizacja wyszukiwarek (SEO) ma na celu zwiększenie widoczności wyszukiwania i ruchu organicznego — a czasami najlepiej osiągnąć ten cel, ograniczając treści, które mogą pojawiać się w wynikach wyszukiwania.

Jeśli drapiesz się po głowie lub sprawdzasz mój blef, czytaj dalej, aby odkryć wartość noindexing strony lub podkatalogu i jak zaimplementować tagi noindex.

Co oznacza Noindex?

Termin „noindex” to specjalna dyrektywa w metatagu robots, która mówi robotom indeksującym, aby wykluczyły stronę ze stron wyników wyszukiwania (SERP). Oznacza to, że osoby wyszukujące nie będą mogły uzyskać dostępu do strony za pomocą wyszukiwania.

Metatagi robotów, będące cenną częścią każdej technicznej strategii SEO, umożliwiają wykluczenie stron, które nie mają wartości dla wyszukiwarek lub zawierają informacje, których nie chcesz wyświetlać w wynikach wyszukiwania, takie jak:

- Strony potwierdzenia i podziękowania

- Strony logowania

- Strona z polityką prywatności lub warunkami korzystania z usługi

- Zawartość bramkowana

- Komunikaty o błędach

Metatag robotów a robots.txt a tag X-Robots

Metatag robots jest często mylony z plikiem robots.txt i tagiem x-robots. Wszystkie trzy dają instrukcje wyszukiwania robotów na temat stron i są częścią protokołu wykluczania robotów (REP). Mówiąc prościej: informują Google, co umieścić w wyszukiwarce Google, a czego trzymać z dala od niej, a także które strony mają zaindeksować. Jednak nie mogą i nie powinny być używane zamiennie.

Metatag robotów

Metatag robots jest dodawany do sekcji <head> określonej strony internetowej i przekazuje tylko instrukcje dotyczące tej konkretnej strony. Często nazywany tagiem noindex lub metatagiem noindex, metatag robots może zrobić coś więcej niż tylko powiedzieć robotowi wyszukiwania, aby nie indeksował strony.

Można go również użyć, aby poprosić roboty indeksujące o nie podążanie za linkami, tłumaczenie strony, blokowanie określonego bota wyszukiwania lub zapobieganie pojawianiu się łącza w pamięci podręcznej w SERP.

Typowe dyrektywy meta tagów robots obejmują:

- Noindex, nofollow — <meta name=”robots” content=”noindex, nofollow”>

Googlebot i inne roboty indeksujące mogą uzyskiwać dostęp do strony, ale nie powinny jej indeksować ani korzystać z zawartych w niej linków. - Noindex, follow — <meta name=”robots” content=”noindex”>

Googlebot i inne roboty indeksujące mogą uzyskiwać dostęp do strony i korzystać z zawartych na niej linków, ale nie powinny indeksować samej strony. Nie musisz umieszczać słowa „follow” w metatagu, ponieważ jest to ustawienie domyślne.

Roboty.txt

Robots.txt to plik, który umożliwia właścicielom witryn informowanie wyszukiwarek, których części witryny nie chcą indeksować. To jak osobisty znak „Nie przeszkadzać” dla Twojej witryny w katalogu głównym Twojej domeny lub subdomeny.

Plik robots.txt najlepiej nadaje się do blokowania dostępu i indeksowania całych podkatalogów, a nie pojedynczych stron. Użyj go, aby uniemożliwić robotom indeksującym dostęp i indeksowanie:

- Wewnętrzne strony wyszukiwania

- Parametry adresu URL

- Fora, na których spam generowany przez użytkowników może powodować problemy

- Wewnętrzne podkatalogi, takie jak te, które są dostępne tylko dla pracowników

Wykonaj poniższe czynności, aby utworzyć plik robots.txt i pamiętaj o umieszczeniu linku do mapy witryny XML.

Jeśli łączysz się ze stroną zawartą w pliku robots.txt, możesz również dodać do niej metatag robots, aby upewnić się, że nie będzie ona wyświetlana w wynikach wyszukiwania. Pamiętaj — plik robots.txt blokuje robotom dostęp do strony, a nie jej indeksowanie. Jeśli strony objęte dyrektywami pliku robots.txt otrzymają linki zewnętrzne, wyszukiwarki mogą je zaindeksować. Aby tego uniknąć, użyj metatagu robots w połączeniu z plikiem robots.txt.

Znacznik X-Robots

Aby zablokować wyświetlanie pliku PDF, wideo lub obrazu w SERP, użyj tagu x-robots. Te same dyrektywy, które określono dla metatagów robots, są używane dla x-robots. Jednak w przeciwieństwie do metatagu robots, który znajduje się w nagłówku HTML strony, tag x-robots jest umieszczany w odpowiedzi nagłówka HTTP.

Dyrektywa wygląda tak:

X-Robots-Tag: noindexKiedy nie indeksować strony

Wzdęcie indeksu krawężnika

Nadmiar indeksu ma miejsce, gdy Google indeksuje strony, które mają niewielką lub żadną wartość dla wyszukiwarek. Te zbędne strony odciągają zasoby od bardziej wartościowych stron. Użyj metatagu robots, aby zarządzać, które strony pojawiają się w wynikach wyszukiwania.

Wyeliminuj kanibalizację słów kluczowych

Kanibalizacja słów kluczowych ma miejsce, gdy dwie strony mają podobne słowo kluczowe i zamiar wyszukiwania, co powoduje, że konkurują ze sobą w SERP.

Jeśli masz dwie strony, które kanibalizują się nawzajem i chcesz zachować obie bez zmiany ich treści, noindex one. To powiedziawszy, powinieneś to robić tylko wtedy, gdy strona, której nie indeksujesz, nie generuje ruchu ze słów kluczowych, których nie ma druga strona. W takiej sytuacji może być konieczne przerobienie treści na jednej lub obu stronach, aby rozwiązać problem kanibalizacji.

Chroń ogrodzone strony docelowe

Gdy oferujesz klientom wartościowy zasób w zamian za informacje kontaktowe, upewnij się, że nie jest on dostępny w żaden inny sposób. Dodaj metatag robots, aby noindex strony nie pojawiał się w SERP.

Wyklucz niepopularne produkty z wyszukiwania

Witryny e-commerce często oferują produkty przeznaczone dla określonych klientów, mimo że nie ma na nie zbyt dużego popytu. Na przykład sprzedawca części samochodowych lub inna firma techniczna może mieć produkty do określonych modeli lub rzadkiego wyposażenia. Jeśli te strony produktów lub kategorii nie generują ruchu organicznego, zazwyczaj nie mogą być indeksowane.

Jak Noindexować stronę internetową

Metatag noindex znajduje się w nagłówku kodu HTML strony. W kodzie nie jest rozróżniana wielkość liter i wygląda on tak:

<meta name="robots" content="noindex">„Roboty” oznaczają, że dyrektywa dotyczy każdego robota, ale roboty można wyróżnić, zastępując „roboty” znanymi nazwami robotów, takimi jak „Googlebot” lub „bingbot”.

Roboty nadal będą podążać za linkami na stronie, chyba że dodasz również polecenie nofollow. Możesz to zrobić, aby uniemożliwić przepływanie przez stronę linków lub uniemożliwić robotowi indeksującemu podążanie za linkiem do treści bramkowanej.

Aby dodać wartość nofollow, oddziel ją od dyrektywy noindex przecinkiem.

<meta name="robots" content="noindex, nofollow">Uwaga: przed przystąpieniem do noindexingu strony sprawdź, czy w Google Search Console pojawia się ruch organiczny. Jeśli tak, określ, w jaki sposób Twoja witryna może nadal przechwytywać ten ruch, zanim strona nie zostanie zindeksowana.

Jak dodać metatag Robots do kodu HTML

- Otwórz kod źródłowy strony, którą chcesz zindeksować.

- Znajdź nagłówek u góry strony. Zaczyna się od <head> i kończy na </head>. W nagłówku prawdopodobnie będzie również inny kod.

- Dodaj metatag robots w nowym wierszu, upewniając się, że pojawia się między tagami <head> i </head>.

Otóż to! Jeśli Twoja strona jest już zindeksowana, możesz poprosić Google o jej ponowne zindeksowanie, wklejając jej adres URL do narzędzia do sprawdzania adresów URL.

Już zindeksowane? Użyj narzędzia do usuwania adresów URL

Gdy dodasz tag noindex do nowej strony z treścią, Googlebot zobaczy tę dyrektywę podczas indeksowania strony i nie będzie jej indeksować.

Jeśli jednak dodasz tag do strony, która została już zindeksowana , strona będzie nadal wyświetlana w wynikach wyszukiwania, dopóki nie zostanie ponownie zindeksowana, a roboty zobaczą nowe instrukcje noindex. Możesz poprosić Google o ponowne zindeksowanie adresu URL w Google Search Console za pomocą narzędzia do sprawdzania adresów URL, ale nie spowoduje to natychmiastowego usunięcia strony z SERP.

Jeśli chcesz natychmiast usunąć stronę z SERP, użyj narzędzia do usuwania w Google Search Console. Dzięki temu strony nie będą pojawiać się w wynikach wyszukiwania Google przez około sześć miesięcy. Do tego czasu metatag noindex powinien działać.

Jak Noindexować stronę na WordPressie

Każda strona w WordPressie jest domyślnie indeksowana. Możesz użyć wtyczki Yoast SEO, aby nieindeksować strony w WordPress bez pisania kodu. Oto jak.

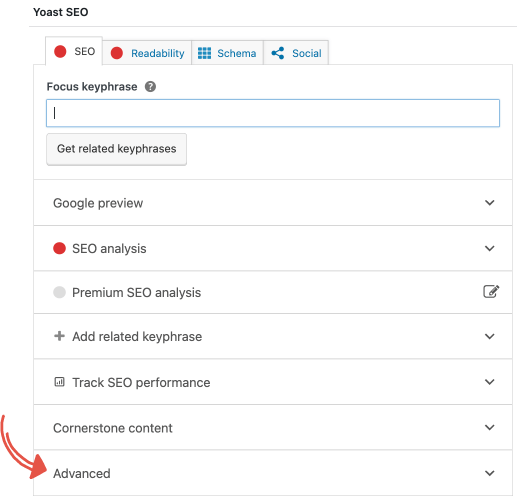

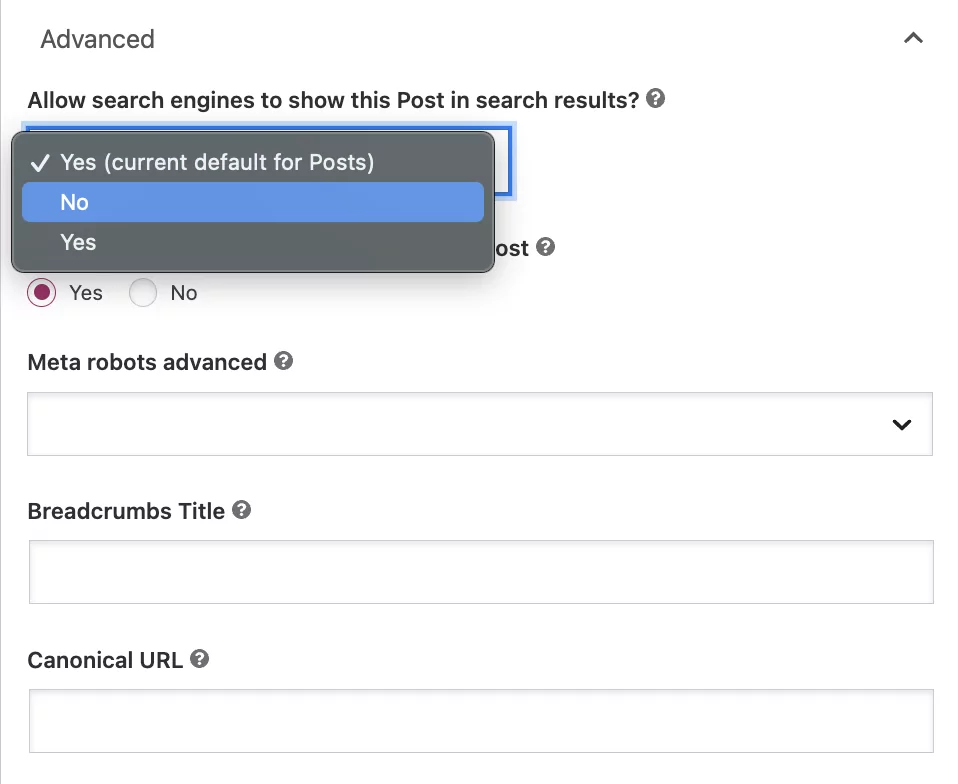

Kliknij kartę „Zaawansowane” w meta polu Yoast SEO.

Pod pytaniem „Zezwalać wyszukiwarkom na pokazywanie tego wpisu w wynikach wyszukiwania?” wybierz „Nie” z listy rozwijanej.

Chociaż to ustawienie instruuje Google, aby nie indeksował posta, roboty nadal będą automatycznie podążać za linkami na stronie, aby zaindeksować inne strony.

Jeśli chcesz dodać dyrektywę nofollow, wybierz przycisk „Nie” pod pytaniem: „Czy wyszukiwarki powinny śledzić linki w tym poście?”

Często zadawane pytania dotyczące metatagów robotów

Czy wszystkie wyszukiwarki przestrzegają dyrektywy noindex?

Możesz oczekiwać, że Google, Bing i inne legalne wyszukiwarki będą przestrzegać metatagu robots.

Czy mogę linkować do stron nieindeksowanych?

TAk. Tag noindex informuje roboty wyszukujące, jak traktować stronę podczas przeszukiwania i indeksowania. Nie wpływa to na możliwość umieszczania linków do stron. Może to być przydatne w przypadku stron kategorii na blogu, które nie powinny pojawiać się w wynikach wyszukiwania, ale mogą dostarczać botom linki do wartościowych stron, które powinny.

Kiedy powinienem używać metatagu robots?

Jeśli masz stronę, która nie oferuje wyszukiwarkom żadnej wartości, na przykład stronę z podziękowaniami lub stronę do wydrukowania, nie indeksuj jej metatagiem robots, aby nie pojawiała się w SERP.

Kiedy nie powinienem używać dyrektywy noindex?

Możesz technicznie rozwiązać problemy z powielonymi treściami i niektóre problemy z budżetem indeksowania za pomocą dyrektyw noindex, ale nie jest to najlepszy sposób na zrobienie tego. Zduplikowaną treść najlepiej obsługiwać za pomocą tagów kanonicznych, które koncentrują kapitał linków z duplikatów na stronie kanonicznej. Jeśli chcesz ograniczyć budżet indeksowania, użyj pliku robots.txt, aby uniemożliwić indeksowanie tej sekcji witryny.

Czy strony nieindeksowane przekazują wartość linków?

TAk. Nawet jeśli strona nie jest zindeksowana, może nadal dzielić się wszelkimi zdobytymi autorytetami w rankingu. Jednak roboty indeksujące muszą mieć możliwość podążania za linkami na stronie, aby przepływały przez nie linki. Jeśli strona jest ustawiona na noindex i nofollow, nie może przekazać wartości linku.

Czy brak indeksowania strony automatycznie usuwa ją z SERPów Google?

Jeśli Twoja strona jest już zaindeksowana, dodanie metatagu robots nie spowoduje automatycznego usunięcia jej z wyników wyszukiwania. Potrzeba trochę czasu, zanim strony, które są już zaindeksowane, znikną z SERP. Roboty wyszukujące muszą ponownie zindeksować strony, aby zobaczyć tag noindex. Aby uzyskać szybsze wyniki, poproś Google o ponowne zindeksowanie strony i skorzystanie z narzędzia do usuwania adresów URL.

Odkryj problematyczne strony dzięki audytowi SEO

Nie pozwól, aby rzadka lub zduplikowana treść wpływała na widoczność w wyszukiwarce. Upewnij się, że dajesz swoim stronom najlepszą szansę na pozycjonowanie. Nasz ponad 200-punktowy audyt SEO wskazuje problemy, takie jak zduplikowane treści, brakujący plik robots.txt, niewłaściwie zastosowane metatagi robotów, rozrost indeksu i inne. Zapisz się na bezpłatną konsultację SEO, aby zobaczyć, w jaki sposób nasza usługa audytu SEO może zmaksymalizować Twoją widoczność online i pomóc w rozwoju Twojej firmy.