Nie przegap jutrzejszych wiadomości z branży mediów społecznościowych

Opublikowany: 2023-04-13Wśród głównych obaw związanych z przejęciem Elona Muska na Twitterze było postrzegane złagodzenie wcześniejszych przepisów dotyczących mowy nienawiści, dezinformacji i innych niepokojących elementów.

Musk, który zdecydowanie popiera zezwalanie na wszelkiego rodzaju wypowiedzi, niezależnie od tego, czy jest to osobiście sprzeczne, czy nie, nadzorował przywrócenie dziesiątek tysięcy kont, które zostały wcześniej zablokowane przez kierownictwo Twittera, a także usunął ograniczenia mające na celu ograniczenie dezinformacji COVID, anulował etykiety ostrzegawcze w chińskich i rosyjskich mediach państwowych, jednocześnie promując różne teorie spiskowe wśród swoich 134 milionów obserwujących.

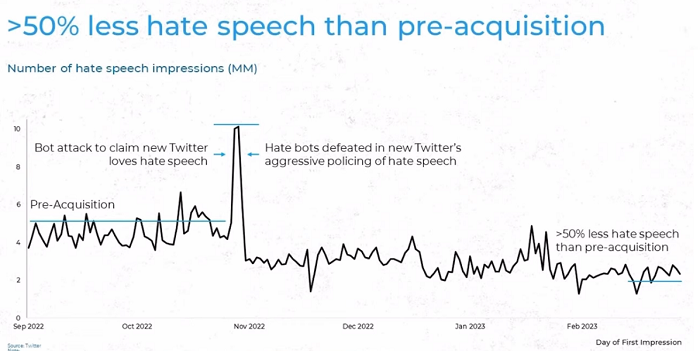

To takie zmiany, które podobno spowodowały, że wielu reklamodawców Twittera unikało aplikacji ze względu na obawy dotyczące potencjalnego związku z mową nienawiści i obraźliwymi materiałami – ale czy mowa nienawiści faktycznie rośnie na Twitterze 2.0, czy też tak jest, jak twierdzą Musk i jego zespół , faktycznie redukując dzięki zaktualizowanym procesom wykrywania i ograniczania takich w aplikacji?

To był kluczowy punkt sporny, który wyłonił się z wywiadu Muska z BBC w tym tygodniu, który Musk transmitował na żywo za pośrednictwem Twitter Spaces. Ogólnie rzecz biorąc, prawie dwugodzinny wywiad nie dostarczył żadnych nowych informacji – Musk omówił swoje pospieszne zwolnienia w aplikacji i potrzebę obniżenia kosztów, aby uratować firmę, Musk twierdził, że jego pies jest teraz dyrektorem generalnym Twittera, i powiedział, że Twitter może osiągnąć próg rentowności w ciągu kilku miesięcy.

Ale mowa nienawiści i jej wpływ na reklamodawców były wyraźnie drażliwym punktem, a Musk podzielił się tą wymianą, aby podkreślić to, co postrzega jako stronniczość mediów wokół tego elementu.

Tym razem z wideo i lepszym dźwiękiem https://t.co/js4nTQSSh3

— Elon Musk (@elonmusk) 12 kwietnia 2023 r

Oczywiście osobiste doświadczenia jednego użytkownika nie wskazują na zakres potencjalnego problemu, jeśli taki istnieje – chociaż, jak wspomniano, Musk i jego zespół twierdzą, że mowa nienawiści jest w rzeczywistości znacznie słabsza, odkąd przejął kontrolę nad aplikacją.

Czy to może być prawda? Ponownie, po przywróceniu tak wielu wcześniej zablokowanych kont, z których wiele zostało zamkniętych z powodu naruszenia zasad platformy dotyczących mowy nienawiści, wydaje się, że ten element nie mógł zostać zmniejszony. Jak więc Musk i spółka wymyślają te statystyki – i do jakich badań odnosi się BBC w związku ze wzrostem liczby nienawistnych treści?

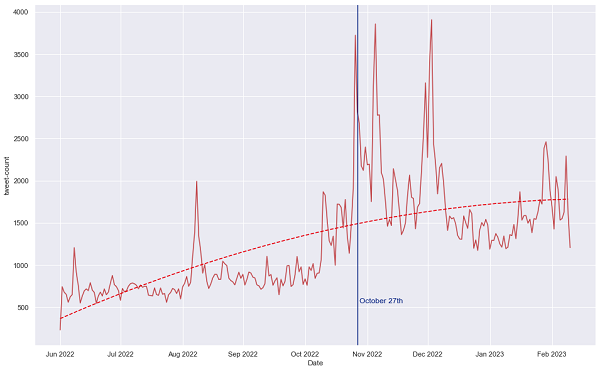

Po pierwsze, od zewnętrznych badań, z których podobno wynika, że mowa nienawiści nasiliła się. Jak wspomniano w wywiadzie dla BBC, Instytut Dialogu Strategicznego (ISD) opublikował w zeszłym miesiącu badanie, z którego wynika, że liczba antysemickich tweetów wzrosła ponad dwukrotnie w okresie trzech miesięcy po przejęciu aplikacji przez Muska.

To zupełnie inny wykres niż ten, który udostępnił Twitter – więc jaka jest tutaj ta wariancja i dlaczego dane ISD pokazują stały wzrost, podczas gdy własne liczby Twittera odzwierciedlają spadek?

W pewnym sensie można powiedzieć, że największy skok na tym wykresie odzwierciedla ten sam incydent, na który wskazują dane Twittera, który, jak twierdzi, jest wzrostem liczby ataków botów mających na celu zdyskredytowanie przywództwa Muska poprzez wzmacnianie obelg w aplikacji.

Rzeczywiście, według raportu ISD:

„Zidentyfikowaliśmy również gwałtowny wzrost liczby nowych kont publikujących mowę nienawiści, co korelowało z przejęciem Muska. W sumie między 27 października a 6 listopada utworzono 3855 kont, które zamieściły co najmniej jeden antysemicki tweet. To ponad trzykrotnie więcej niż liczba potencjalnie nienawistnych kont utworzonych w analogicznym okresie przed przejęciem”.

Prawdopodobnie jest to zgodne z wykrywaniem botów przez Twittera, podczas gdy ISD zauważa również, że Twitter usuwa teraz więcej treści:

„Wydaje się, że odsetek antysemickich treści usuniętych przez Twittera wzrósł w okresie od przejęcia, przy czym 12% antysemickich tweetów było następnie niedostępnych do zbierania, w porównaniu do 6% przed przejęciem. Jednak ten potencjalny wzrost wskaźnika usuwania nie nadąża za wzrostem ogólnej zawartości antysemickiej treści, w wyniku czego mowa nienawiści pozostaje bardziej dostępna na platformie niż przed przejęciem Muska. ”

Odkrycia ISD korelują również z podobnymi danymi z The Center for Countering Digital Hate , które wykazały, że obelgi wobec osób czarnoskórych i transpłciowych znacznie wzrosły wkrótce po tym, jak Musk przejął kontrolę nad aplikacją, a zaangażowanie w mowę nienawiści również wzrosło.

„Średnia liczba polubień, odpowiedzi i retweetów na postach z obelgami wyniosła 13,3 w tygodniach poprzedzających Twitter 2.0 Muska . Według raportu, od czasu przejęcia średnie zaangażowanie w treści szerzące nienawiść wzrosło do 49,5. ”

Ale znowu, te odkrycia były na wczesnym etapie zmiany, do czego przyznaje Twitter. Pytanie brzmi, czy od tego czasu coś się zmieniło – i jak się zmieniły, jeśli Twitter pracuje nad zmniejszeniem ograniczeń dotyczących wypowiedzi?

Dane opublikowane przez Twittera dostarczają dodatkowego kontekstu. W zeszłym miesiącu Twitter opublikował nowe spostrzeżenia Sprinklr, które rzucają więcej światła na jego wysiłki na rzecz ograniczenia mowy nienawiści i sposób obliczania jej liczb.

Według Twittera:

„Sprinklr definiuje mowę nienawiści, oceniając obelgi w złożonym kontekście ich użycia. Do tej pory Twitter miał szersze spojrzenie na potencjalną toksyczność używania obelg. Aby oszacować mowę nienawiści, Twitter i Sprinklr zaczynają od 300 najpopularniejszych obelg w języku angielskim. Liczymy nie tylko to, jak często są tweetowani, ale także jak często są widziani (wyświetlenia). Nasze modele oceniają tweety z obelgami za „toksyczność”, prawdopodobieństwo, że stanowią one mowę nienawiści”.

Zgodnie z tą metodologią większość oszczerstw na Twitterze nie jest w rzeczywistości mową nienawiści, a niektóre terminy są używane w niektórych społecznościach w sposób, który wymaga więcej niuansów w ocenie niż proste zliczanie danych. Na przykład terminy używane w społeczności Czarnych mogą nie być ogólnie postrzegane jako mowa nienawiści, ale zostałyby uznane za takie, gdybyś korzystał ze śledzenia słów kluczowych.

Twitter twierdzi, że jego proces śledzenia bierze to pod uwagę, podczas gdy inni tego nie robią, a gdy użycie takiej terminologii jest używane w nienawistny sposób, Twitter podejmuje działania w celu usunięcia tweeta lub ograniczenia jego zasięgu.

„Analiza firmy Sprinklr wykazała, że mowa nienawiści ma o 67% mniej wyświetleń na tweet niż nietoksyczne tweety z obelgami. Żaden model nigdy nie jest doskonały, a ta praca nigdy się nie kończy. Będziemy nadal zwalczać mowę nienawiści, wprowadzając inne języki, nowe terminy i bardziej precyzyjne metodologie – a wszystko to przy jednoczesnym zwiększeniu przejrzystości”.

Zasadniczo Twitter twierdzi, że liczenie wszystkich wzmianek o potencjalnych obelgach, zgodnie z tymi zewnętrznymi badaniami, nie jest skutecznym sposobem mierzenia wpływu takich wzmianek, ponieważ nie chodzi o same wzmianki, ale kontekst, w którym są używane, a następnie, zasięg, jaki osiągają.

Bez uwzględnienia tych rozważań w jakiejkolwiek ocenie nie może być ona dokładna – co wyjaśniałoby, dlaczego dane Twittera tak bardzo różnią się od wyników analizy przeprowadzonej przez stronę trzecią.

Czy to jest poprawne? Cóż, bez pełnych danych porównawczych trudno powiedzieć, ale rozszerzony proces oceny ma sens, co może oznaczać, że bardziej binarna analiza takich terminów jest błędna, przynajmniej do pewnego stopnia.

Mimo to Twitterowi grozi w Niemczech grzywna w wysokości miliardów dolarów za nieusuwanie nawoływania do nienawiści w odpowiednim czasie, zgodnie z lokalnymi przepisami, i ciekawe będzie, jakie dokładnie przykłady podają niemieckie władze w tej sprawie.

Wydaje się więc, że nadal istnieją pewne obawy – ale rozszerzony kontekst, do którego odnosi się Twitter, wraz ze zwiększonymi wysiłkami na rzecz ograniczenia mowy nienawiści, ma jakiś sens.

Bez wątpienia z biegiem czasu uzyskamy więcej danych na ten temat, ale ogólny obraz przedstawia bardziej złożony obraz, niż mogą sugerować niektóre ustalenia.