Jak skalować wykorzystanie dużych modeli językowych w marketingu

Opublikowany: 2023-05-19Generatywna sztuczna inteligencja i duże modele językowe zmienią branżę marketingową, jaką znamy.

Aby pozostać konkurencyjnym, musisz zrozumieć technologię i jej wpływ na nasze działania marketingowe, powiedział Christopher Penn, główny analityk danych w TrustInsights.ai, przemawiając na konferencji MarTech.

Dowiedz się, jak skalować użycie dużych modeli językowych (LLM), poznaj wartość szybkiej inżynierii i dowiedz się, jak marketerzy mogą przygotować się na nadchodzące wydarzenia.

Założenie dużych modeli językowych

Od momentu uruchomienia ChatGPT jest popularnym tematem w większości branż. Nie możesz przejść do trybu online bez zobaczenia, jak wszyscy to robią. Jednak niewiele osób rozumie technologię, która za tym stoi, powiedział Penn.

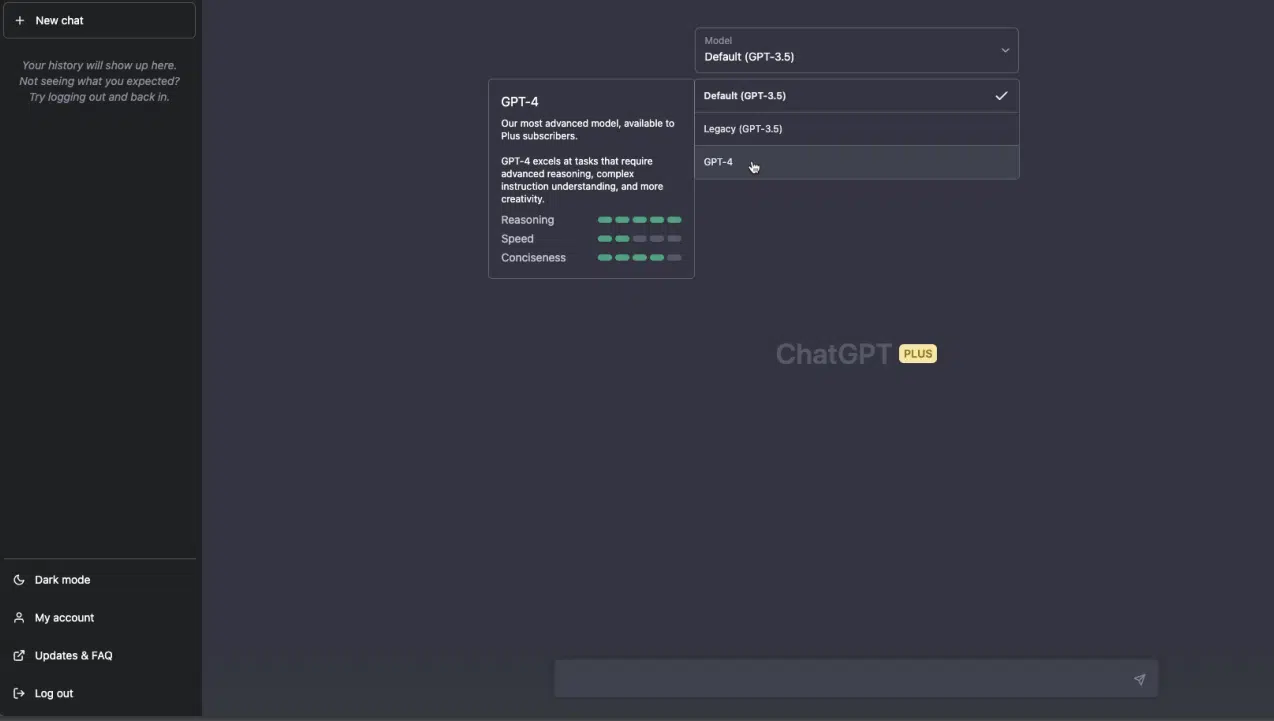

ChatGPT to chatbot AI oparty na GPT-3.5 i GPT-4 LLM OpenAI.

LLM są zbudowane na założeniu z 1957 roku angielskiego językoznawcy Johna Ruperta Firtha: „Poznasz słowo po towarzystwie, w którym się znajduje”.

Oznacza to, że znaczenie słowa można zrozumieć na podstawie słów, które zwykle pojawiają się obok niego. Mówiąc najprościej, słowa są definiowane nie tylko przez definicję słownikową, ale także przez kontekst, w jakim są używane.

Ta przesłanka jest kluczem do zrozumienia przetwarzania języka naturalnego.

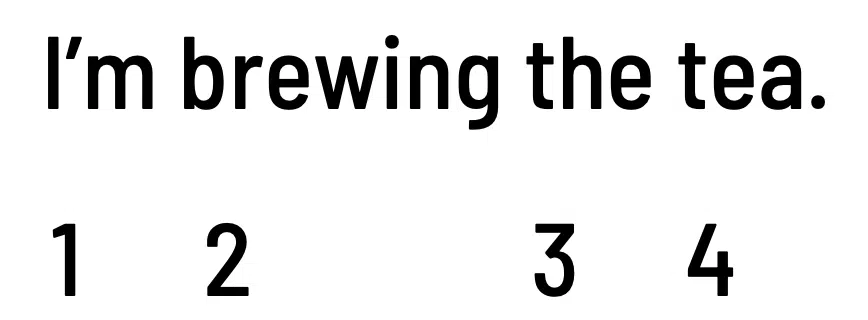

Na przykład spójrz na następujące zdania:

- „Parzę herbatę”.

- „Rozlewam herbatę”.

To pierwsze odnosi się do gorącego napoju, podczas gdy drugie to slangowe określenie plotek. „Herbata” w tych przypadkach ma bardzo różne znaczenia.

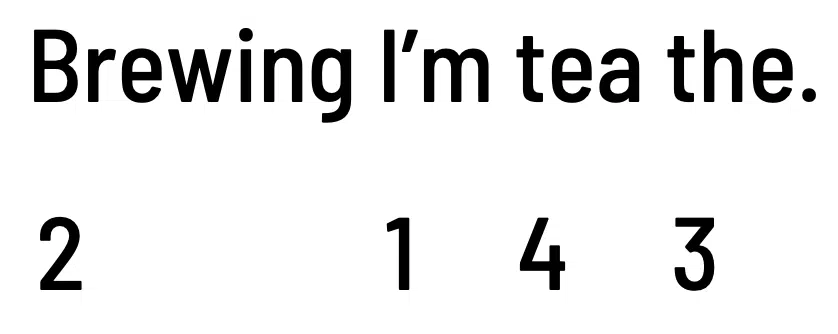

Kolejność słów też ma znaczenie.

- „Parzę herbatę”.

- „Herbata, którą parzę”.

Powyższe zdania mają różne tematy, mimo że używają tego samego czasownika „warzenie”.

Jak działają duże modele językowe

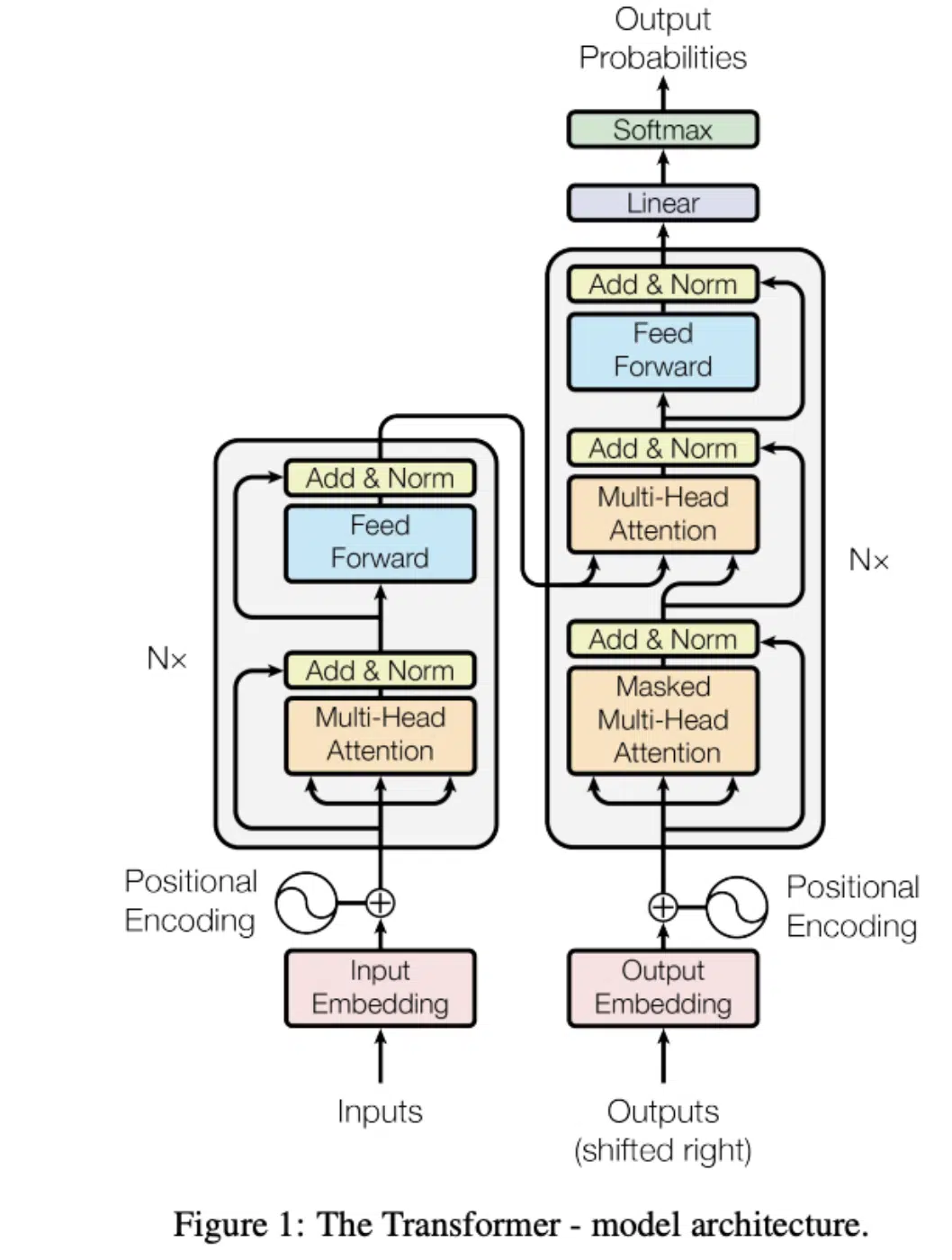

Poniżej znajduje się schemat systemu transformatorów, model architektury, w którym budowane są duże modele językowe.

Mówiąc najprościej, transformator pobiera dane wejściowe i zamienia je (tzn. „transformuje”) na coś innego.

LLM mogą być używane do tworzenia, ale są lepsze w przekształcaniu jednej rzeczy w coś innego.

OpenAI i inne firmy produkujące oprogramowanie zaczynają od pochłonięcia ogromnego zbioru danych, w tym milionów dokumentów, artykułów naukowych, artykułów prasowych, recenzji produktów, komentarzy na forach i wielu innych.

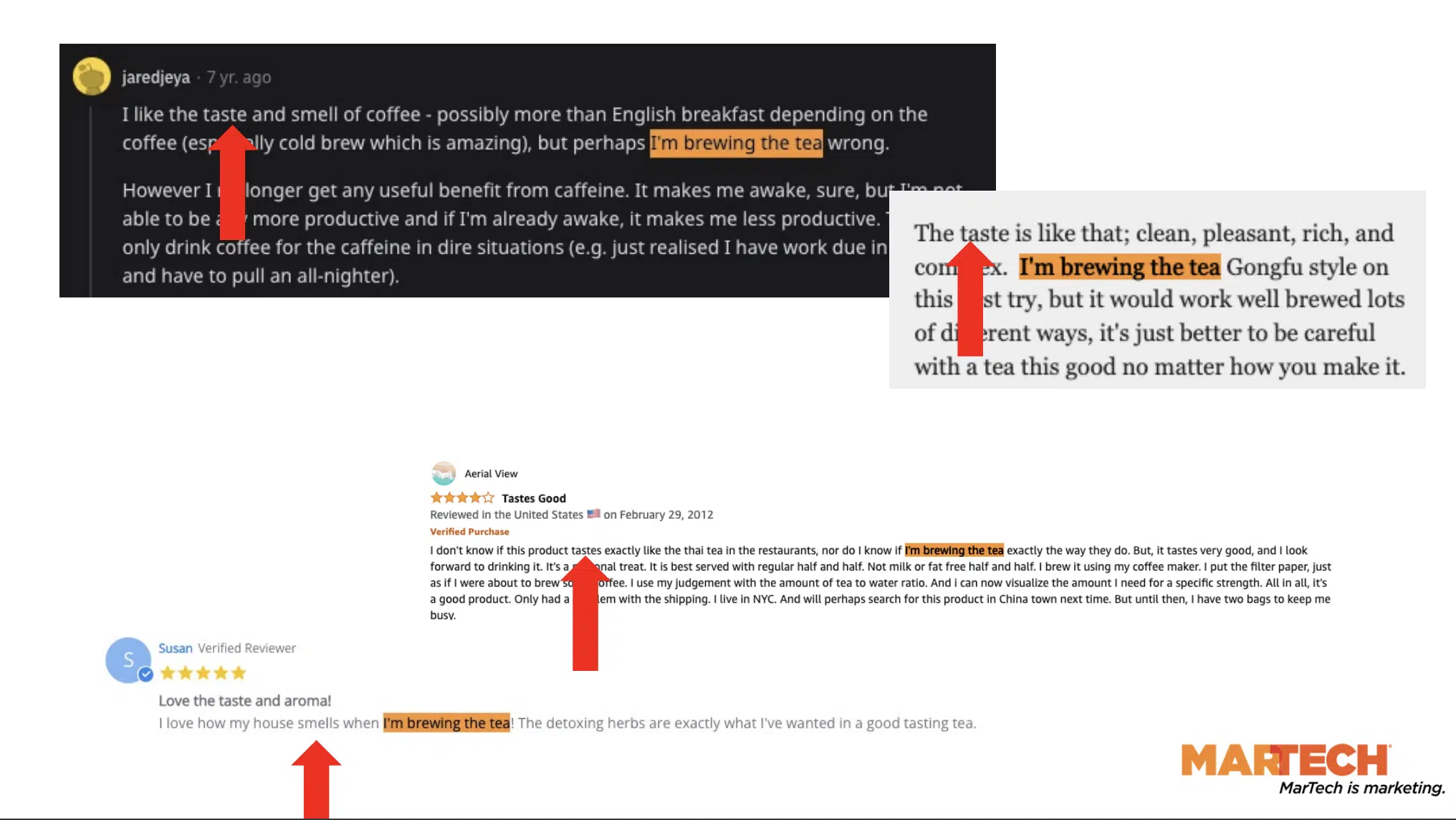

Zastanów się, jak często wyrażenie „parzę herbatę” może pojawiać się we wszystkich tych połkniętych tekstach.

Powyższe recenzje produktów Amazon i komentarze Reddit to tylko niektóre przykłady.

Zwróć uwagę na „towarzystwo”, które utrzymuje to wyrażenie — to znaczy wszystkie słowa pojawiające się obok „Parzę herbatę”.

„Smak”, „zapach”, „kawa”, „aromat” i inne nadają kontekst tym LLM.

Maszyny nie potrafią czytać. Aby przetworzyć cały ten tekst, używają osadzania, pierwszego kroku w architekturze transformatora.

Osadzanie umożliwia modelom przypisanie każdemu słowu wartości liczbowej, a ta wartość liczbowa występuje wielokrotnie w korpusie tekstowym.

Pozycja słowa również ma znaczenie dla tych modeli.

W powyższym przykładzie wartości liczbowe pozostają takie same, ale w innej kolejności. To jest kodowanie pozycyjne.

Mówiąc prościej, duże modele językowe działają w następujący sposób:

- Maszyny pobierają dane tekstowe.

- Przypisz wartości liczbowe wszystkim słowom.

- Spójrz na częstotliwości statystyczne i rozkłady między różnymi słowami.

- Spróbuj dowiedzieć się, jakie będzie następne słowo w sekwencji.

Wszystko to wymaga znacznej mocy obliczeniowej, czasu i zasobów.

Zdobądź MarTech! Codziennie. Bezpłatny. W Twojej skrzynce odbiorczej.

Zobacz warunki.

Szybka inżynieria: umiejętność, której trzeba się nauczyć

Im więcej kontekstu i instrukcji zapewniamy LLM, tym większe prawdopodobieństwo, że przyniosą one lepsze wyniki. To jest wartość szybkiej inżynierii.

Penn myśli o podpowiedziach jako o barierach ochronnych dla tego, co wyprodukują maszyny. Maszyny wychwytują słowa z naszych danych wejściowych i przyczepiają się do nich w celu uzyskania kontekstu podczas opracowywania danych wyjściowych.

Na przykład, pisząc monity ChatGPT, zauważysz, że szczegółowe instrukcje zwykle zwracają bardziej satysfakcjonujące odpowiedzi.

Pod pewnymi względami monity są jak kreatywne briefy dla pisarzy. Jeśli chcesz, aby twój projekt został wykonany poprawnie, nie dasz swojemu pisarzowi jednowierszowej instrukcji.

Zamiast tego wyślesz przyzwoity brief obejmujący wszystko, o czym chcesz, aby napisali i jak chcesz, aby zostały napisane.

Skalowanie wykorzystania LLM

Kiedy myślisz o chatbotach AI, możesz od razu pomyśleć o interfejsie internetowym, w którym użytkownicy mogą wprowadzać monity, a następnie czekać na odpowiedź narzędzia. To jest to, do czego wszyscy są przyzwyczajeni.

„W żadnym wypadku nie jest to koniec gry dla tych narzędzi. To jest plac zabaw. To tutaj ludzie mogą majstrować przy narzędziu” – powiedział Penn. „Nie tak przedsiębiorstwa zamierzają wprowadzić to na rynek”.

Pomyśl o szybkim pisaniu jak o programowaniu. Jesteś programistą piszącym instrukcje do komputera, aby coś zrobił.

Po dostosowaniu monitów do konkretnych przypadków użycia możesz wykorzystać interfejsy API i zachęcić prawdziwych programistów do umieszczenia tych monitów w dodatkowym kodzie, aby można było programowo wysyłać i odbierać dane na dużą skalę.

W ten sposób LLM będą skalować i zmieniać firmy na lepsze.

Ponieważ narzędzia te są wdrażane wszędzie, bardzo ważne jest, aby pamiętać, że każdy jest programistą.

Ta technologia będzie dostępna w pakiecie Microsoft Office — Word, Excel i PowerPoint — oraz w wielu innych narzędziach i usługach, z których korzystamy na co dzień.

„Ponieważ programujesz w języku naturalnym, niekoniecznie tradycyjni programiści będą mieli najlepsze pomysły” — dodał Penn.

Ponieważ LLM są napędzane przez pisanie, specjaliści od marketingu lub PR – a nie programiści – mogą opracować innowacyjne sposoby korzystania z narzędzi.

Dodatkowa wskazówka dla marketerów w wyszukiwarkach

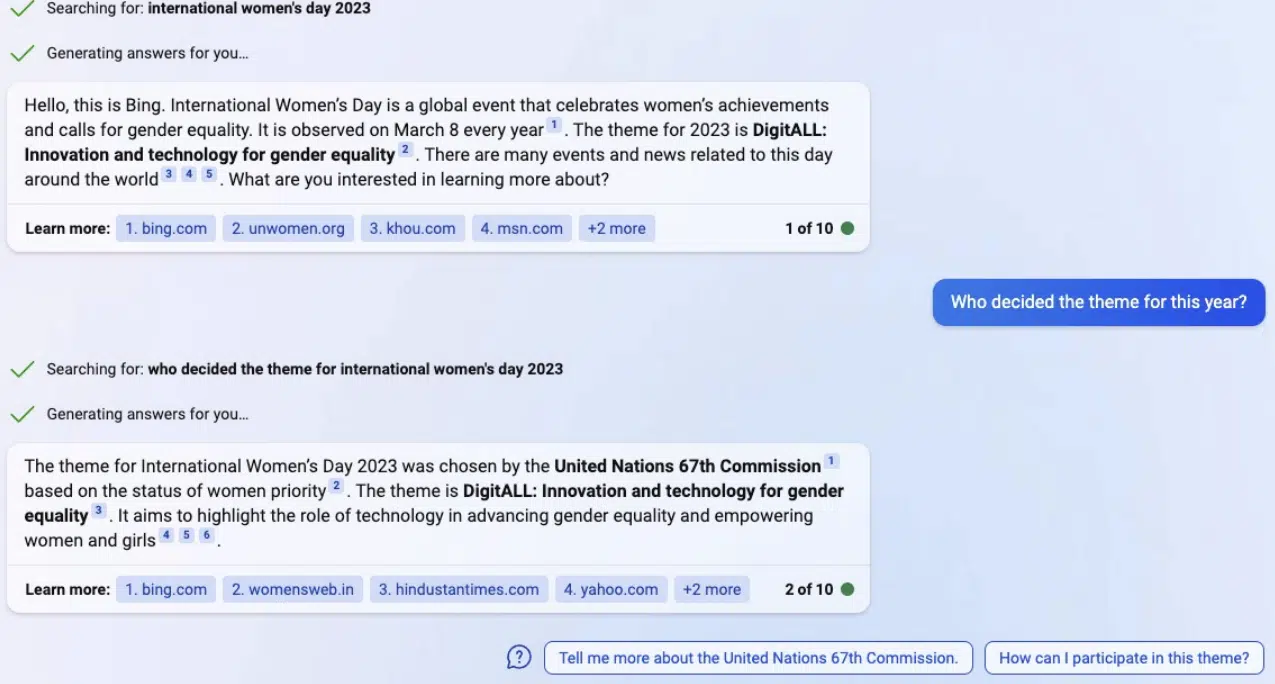

Zaczynamy dostrzegać wpływ dużych modeli językowych na marketing, w szczególności na wyszukiwanie.

W lutym Microsoft zaprezentował nowy Bing, obsługiwany przez ChatGPT. Użytkownicy mogą rozmawiać z wyszukiwarką i uzyskiwać bezpośrednie odpowiedzi na swoje pytania bez klikania jakichkolwiek linków.

„Należy oczekiwać, że te narzędzia odgryzą kęs wyszukiwania niemarkowego, ponieważ odpowiadają na pytania w sposób, który nie wymaga kliknięć” — powiedział Penn.

„Jako profesjonaliści SEO już się z tym borykaliśmy, z polecanymi fragmentami i wynikami wyszukiwania bez kliknięć… ale dla nas będzie jeszcze gorzej”.

Zaleca skorzystanie z Bing Webmaster Tools lub Google Search Console i przyjrzenie się procentowi ruchu, jaki Twoja witryna uzyskuje z niemarkowych, informacyjnych wyszukiwań, ponieważ jest to największy obszar ryzyka dla SEO.

Powiązane historie

Nowość w MarTechu