Czy samodzielna klasyfikacja postów społecznościowych rozwiązałaby kluczowe problemy związane z moderowaniem wypowiedzi online?

Opublikowany: 2022-12-16Moderacja treści jest obecnie gorącym tematem w kręgach mediów społecznościowych, ponieważ Elon Musk zajmuje się reformowaniem Twittera, jednocześnie publikując wcześniejsze działania moderacyjne, jako ilustrację tego, jak aplikacje społecznościowe zyskały zbyt dużą władzę, aby kontrolować niektóre dyskusje.

Ale pomimo tego, że Musk podkreśla dostrzegane wady procesu, pytanie brzmi: jak to naprawić? Jeśli decyzjom dotyczącym treści nie można skutecznie powierzyć małych zespołów wykonawczych odpowiedzialnych za same platformy, to jaka jest alternatywa?

Eksperyment Meta z panelem ekspertów zewnętrznych ogólnie zakończył się sukcesem, ale nawet wtedy jej Rada Nadzorcza nie może orzekać w sprawie każdej decyzji dotyczącej treści, a Meta nadal jest ostro krytykowana za postrzeganą cenzurę i stronniczość, pomimo tych alternatywnych środków odwołania.

Na pewnym poziomie jakiś element podejmowania decyzji nieuchronnie spadnie na zarządzanie platformą, chyba że można wymyślić inną ścieżkę.

Czy alternatywne kanały, oparte na osobistych preferencjach, mogą być innym sposobem na rozwiązanie takich problemów?

Niektóre platformy to rozważają. Jak donosi The Washington Post, TikTok bada obecnie koncepcję, którą nazywa „poziomami treści”, aby zapobiec pojawianiu się „dojrzałych” treści w kanałach młodszych widzów.

TikTok jest pod coraz większą kontrolą na tym froncie, szczególnie w odniesieniu do niebezpiecznych trendów wyzwań, w których niektórzy młodzi ludzie zostali zabici w wyniku udziału w ryzykownych czynach.

Elon Musk również zachwalał podobne podejście do kontroli treści w ramach swojej szerszej wizji „Twitter 2.0”.

Słuszna uwaga.

— Elon Musk (@elonmusk) 29 października 2022 r

Możliwość wyboru wersji Twittera, którą chcesz, jest prawdopodobnie lepsza, podobnie jak w przypadku oceny dojrzałości filmów.

Ocena samego tweeta może być wybrana samodzielnie, a następnie zmodyfikowana na podstawie opinii użytkowników.

W wariancie Muska użytkownicy sami klasyfikowaliby swoje tweety podczas ich przesyłania, a czytelnicy mogli wtedy również zastosować własną ocenę dojrzałości, aby pomóc przenieść potencjalnie szkodliwe treści do osobnej kategorii.

Końcowy wynik w obu przypadkach oznaczałby, że użytkownicy mogliby wtedy wybierać spośród różnych poziomów doświadczenia w aplikacji – od „bezpiecznego”, który odfiltrowałby bardziej skrajne komentarze i dyskusje, do „niefiltrowanego” (Pusk prawdopodobnie poszedłby z „hardcore”), co zapewni Ci pełne wrażenia.

Teoretycznie brzmi to interesująco – ale w rzeczywistości, czy użytkownicy faktycznie sami sklasyfikowaliby swoje tweety i czy poprawiliby te oceny wystarczająco często, aby była to realna opcja dla tego typu filtrowania?

Oczywiście platforma może wprowadzić kary za nieklasyfikowanie lub nieprawidłową klasyfikację tweetów. Być może, w przypadku recydywistów, wszystkie ich tweety są automatycznie filtrowane do bardziej ekstremalnej segmentacji, podczas gdy inni mogą uzyskać maksymalny zasięg odbiorców, wyświetlając ich treść w obu lub we wszystkich strumieniach.

Wymagałoby to od użytkowników większej pracy ręcznej przy wyborze klasyfikacji w ramach procesu składu, ale może to rozwiałoby pewne obawy?

Ale z drugiej strony, to nadal nie powstrzymałoby wykorzystywania platform społecznościowych do wzmacniania mowy nienawiści i podsycania niebezpiecznych ruchów.

W większości przypadków, gdy Twitter lub inne aplikacje społecznościowe zostały przeniesione do cenzurowania użytkowników, było to spowodowane groźbą wyrządzenia krzywdy, a nie dlatego, że ludzie są koniecznie urażeni komentarzami.

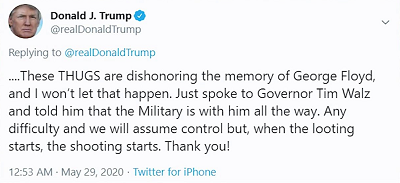

Na przykład, gdy były prezydent Donald Trump opublikował:

Obawa nie polegała tak bardzo na tym, że ludzie byliby urażeni jego komentarzem „kiedy zacznie się grabież, zaczyna się strzelanina”, ale bardziej na tym, że zwolennicy Trumpa mogliby potraktować to jako zasadniczo licencję na zabijanie, przy czym prezydent skutecznie poparłby użycie śmiercionośnej siły w celu odstraszenia szabrowników.

Platformy społecznościowe, logicznie rzecz biorąc, nie chcą, aby ich narzędzia były wykorzystywane do szerzenia potencjalnych szkód w ten sposób, a pod tym względem autocenzura lub ustalanie oceny wiekowej dla Twoich postów nie rozwiąże tego kluczowego problemu, po prostu ukryj takie komentarze przed użytkownikami, którzy zdecydują się ich nie widzieć.

Innymi słowy, jest to bardziej zaciemnianie niż poprawa bezpieczeństwa - ale wielu wydaje się wierzyć, że głównym problemem nie jest to, że ludzie mówią i chcą mówić takie rzeczy w Internecie, ale to, że inni są tym urażeni.

To nie jest problem i chociaż ukrywanie potencjalnie obraźliwych materiałów może mieć pewną wartość w zmniejszaniu ekspozycji, szczególnie w przypadku TikTok, dla młodszych odbiorców, nadal nie powstrzyma to ludzi przed wykorzystywaniem ogromnego potencjału aplikacji społecznościowych do szerzenia nienawiści i niebezpieczne wezwania do działania, które rzeczywiście mogą prowadzić do rzeczywistych szkód.

Zasadniczo jest to fragmentaryczna oferta, rozmycie odpowiedzialności, które w niektórych przypadkach będzie miało pewien wpływ, ale nie dotyczy podstawowej odpowiedzialności platform społecznościowych za zapewnienie, że narzędzia i systemy, które stworzyły, nie są wykorzystywane do niebezpiecznych zamiar.

Bo są, są i będą. Platformy społecznościowe były wykorzystywane do podsycania niepokojów społecznych, powstań politycznych, zamieszek, wojskowych zamachów stanu i nie tylko.

Właśnie w tym tygodniu wszczęto nowe postępowanie prawne przeciwko Meta za zezwolenie na „ pełne przemocy i nienawistne posty w Etiopii na Facebooku, rozpalające krwawą wojnę domową w tym kraju ”. Pozew domaga się 2 miliardów dolarów odszkodowania dla ofiar wynikającej z tego przemocy.

Nie chodzi tylko o opinie polityczne, z którymi się nie zgadzasz, platformy mediów społecznościowych mogą być wykorzystywane do napędzania prawdziwych, niebezpiecznych ruchów.

W takich przypadkach żadna samocertyfikacja prawdopodobnie nie pomoże – na platformach zawsze będzie spoczywał pewien obowiązek ustalenia zasad, aby zapewnić uwzględnienie tego rodzaju najgorszych scenariuszy.

To lub zasady muszą zostać ustanowione na wyższym poziomie przez rządy i agencje zaprojektowane do mierzenia ich wpływu i podejmowania odpowiednich działań.

Ostatecznie jednak sedno sprawy nie dotyczy platform społecznościowych pozwalających ludziom mówić, co chcą i dzielić się tym, co im się podoba, do czego dąży wielu zwolenników „wolności słowa”. Na pewnym poziomie zawsze będą istniały ograniczenia, zawsze będą istniały poręcze, a czasami mogą one wykraczać poza prawa danego kraju, biorąc pod uwagę potencjał wzmacniania stanowisk społecznych.

Nie ma łatwych odpowiedzi, ale pozostawienie tego woli ludzi raczej nie przyniesie lepszej sytuacji na wszystkich frontach.