Post Panda 업데이트에서 대규모 웹사이트에 대한 6가지 우선 순위 사이트 감사

게시 됨: 2011-12-13나는 Google Panda, Great Purge가 실제로 인터넷을 더 나은 정보 소스로 만들고 있다고 믿습니다. 그러나 그것에 의해 타격을 받은 거대한 웹사이트에서는 처리해야 할 다른 괴물입니다.

대부분의 경우 Panda 업데이트 이후의 대규모 웹사이트에 대한 SEO는 일반적으로 정보 아키텍처를 처리하고 페이지 구조를 수정하여 트래픽, 이탈률 및 SERP를 크게 개선합니다.

하지만; 거대한 웹사이트를 처리해야 하는 웹 전략가 또는 SEO는 더 적은 시간에 개선을 보기 위해 먼저 해결해야 하는 우선 순위에 대한 시간과 제한에 항상 직면해 있습니다. 물론 상사는 항상 "어제"처럼 즉시 결과를 얻을 수 있기를 원할 것입니다.

그래서 저는 우선 순위를 식별하는 데 도움이 되도록 다음과 같이 기업 웹 사이트에 대한 6가지 우선 순위 사이트 감사를 준비했습니다.

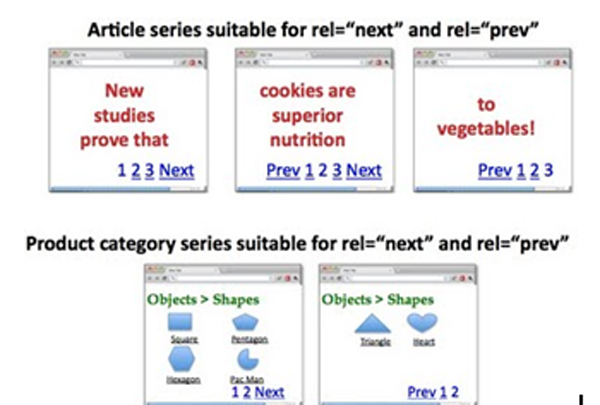

I. 주소 페이지 매김 페이지 인덱싱 및 링크 주스 패스 통합

페이지 매김은 페이지 복제에 관심이 없는 개발자의 잘못된 코딩 습관의 결과인 경우가 많습니다.

구현 방법: rel=”prev” 및 rel=”next”?

1페이지: http://www.example.com/page1.html

<link rel=”canonical” href=”http://www.example.com/page1.html” />

<link rel="next" href="http://www.example.com/page2.html" />

2페이지: http://www.example.com/page2.html

<link rel=”canonical” href=”http://www.example.com/page2.html” />

<link rel=”prev” href=”http://www.example.com/page1.html” />

<link rel="next" href="http://www.example.com/page2.html" />

….

마지막 페이지:

<link rel=”canonical” href=”http://www.example.com/lastpage.html” />

<link rel="prev" href="http://www.example.com/secondtothelastpage.html" />

옵션:

"모두 보기" 페이지 포함은 구성 요소 페이지보다 Google이 색인을 생성하기를 원하는 좋은 전략이 될 수 있습니다. 전체 보기 페이지를 가리키는 rel=”canonical”을 사용하여 이를 수행할 수 있습니다. 하지만; 페이지의 대기 시간이 길다면 rel=”prev” 및 rel=”next” 전략을 고수하는 것이 좋습니다.

Ⅱ. GWT에서 메타 제목 및 메타 설명 중복 문제 수정

GWT의 메타 제목 및 설명에 대한 중복 문제를 해결하려면 그렇게 생성된 제목과 설명을 다시 코딩해야 합니다.

페이지가 매겨진 페이지에 좋은 제목을 구현하는 방법은 무엇입니까?

페이지 1: 키워드가 포함된 제목

페이지 2: 페이지 2/4, 키워드가 포함된 제목

페이지 3: 페이지 3/4, 키워드가 포함된 제목

실제로 다음이 있습니다.

<머리>

<link rel=”canonical” href=”http://www.example.com/page2.html” />

<link rel=”prev” href=”http://www.example.com/page1.html” />

<link rel="next" href="http://www.example.com/page2.html" />

<title> 2/4페이지, 키워드가 포함된 제목</title>

</head>

더 우수하고 고유한 메타 설명을 구현하는 방법은 무엇입니까?

2 쪽:

<title>2/4페이지, 키워드가 포함된 제목</title>

<meta name=”description” content=”>11-20 목록(30개 중) 여기에 키워드가 포함된 제목” />

*제목의 브랜드 키워드는 다른 지역 또는 롱테일 키워드를 수용하기 위해 제거될 수 있습니다.

또는

구성 요소 페이지의 메타 설명을 비워두기만 하면 로봇이 우리가 항상 원했던 상위 페이지로 트래픽과 가중치를 유도할 수 있습니다.

III. 정보 검색 우선 순위 및 "noindex,follow"의 사용을 강화하기 위해 중요 페이지의 Sitemap 재제출

사이트맵을 다시 제출하는 것은 검색 엔진에서 적절하게 색인을 생성하고 평가할 사이트의 가장 중요한 페이지의 우선 순위를 지정하기 위한 것임을 모두 알고 있습니다.

덜 중요한 페이지에 "noindex,follow"를 구현하는 방법은 무엇입니까?

<meta name=”robots” content='noindex, follow' /> 삽입 또는 Google Bot에 대해 보다 구체적으로 사용하려면 <meta name=”googlebot” content='noindex, follow' />를 사용하세요.

- 중요한 것은 구성 요소 페이지(페이지 2,3 등)에 "noindex,follow"를 사용하여 Google에서 종종 얇은 콘텐츠로 해석하는 거의 중복 콘텐츠를 제거해야 합니다.

- 일부 페이지 세트에 대한 구성 요소 페이지가 필요하다고 판단되면 "noindex,follow"를 제거할 수 있습니다.

기업 웹사이트의 모든 페이지를 인덱싱하는 데 노력을 집중하는 것은 좋은 방법이 아니라 청중이 방문하도록 할 수 있는 중요한 페이지에만 집중하는 것이 좋습니다.

역사:

구글이 웹사이트가 권위 있는 웹사이트라고 믿게 만들기 위해 수십만 페이지 또는 수백만 페이지를 만드는 관행은 오늘날 더 이상 적용되지 않습니다. PANDA는 웹사이트에서 "얇은 콘텐츠"를 생성하는 데에도 소름이 돋을 것입니다.

IV. 바운스율 낮추기

BOUNCE RATE는 검색 결과에서 사용자와 사이트의 관련성을 나타내는 Google 지표입니다. Search Opt Media Inc.는 이것이 요즘 순위에 상당한 영향을 미친다고 생각합니다. 더 이상 무시할 수 없었습니다.

그것을 해결하는 방법?

페이지의 내용과 관련된 페이지 제목을 목표로 합니다. 누군가가 검색 결과를 클릭하면 최소한 제목을 읽었을 것입니다. 이제 귀하의 H1이 그것과 매우 다르다면 사람들은 그들이 찾고 있는 것을 제공하지 않는다고 가정하고 귀하의 사이트를 즉시 떠날 것입니다.

더욱이 검색 결과와 관련된 좋은 콘텐츠의 제공이 정말로 요구됩니다.

구현하는 방법?

제목, H1, 메타 설명 및 문서 사본은 검색 결과에서 관련 내용을 표시해야 합니다.

중요: 콘텐츠 작성자는 이를 심각하게 받아들여야 합니다.

V. 사이트 속도 증가

Mayday, Caffeine 및 PANDA 업데이트는 특히 사이트 속도에 대한 사용자 경험에 관한 것입니다. 다시 말하지만, 이것은 웹사이트에서 우수한 사용자 경험을 제공한다는 전제를 기반으로 합니다. 사이트가 빨라질수록 사용자가 사이트에 더 오래 머무를수록 재방문율이 높아지고 모든 것이 차트에 올라갑니다. 이것이 구글이 원하는 것입니다.

사이트 속도는 서버 측 문제일 수도 있고 애플리케이션 측 문제일 수도 있습니다. 나는 당신이 당신의 웹 사이트 속도를 높이기 위해해야 할 일을 아래에 열거했습니다.

사이트 속도에 큰 영향을 미치는 웹 사이트의 특정 "부분"을 테스트하고 식별하는 방법은 무엇입니까?

사용할 도구:

- http://www.webpagetest.org

- http://www.websiteoptimization.com/services/analyze/

- http://tools.pingdom.com/

- https://addons.mozilla.org/en-US/firefox/addon/firebug/

- https://addons.mozilla.org/en-US/firefox/addon/YSlow/

- https://code.google.com/speed/page-speed/download.html

Search Opt Media Inc. 는 사이트 속도 성능 테스트 및 보정을 위해 위의 도구를 식별했습니다. # 1-6은 좋은 도구입니다!

서버 측 문제에 대해 다음을 권장합니다.

1. CDN 사용 – 이미 사용하고 있는 것 같습니다.

2. 캐싱 시스템 사용

VI. Google 웹마스터 도구(GWT)에서 찾은 404페이지 모두 정리

GWT에서 404페이지와 404페이지로 연결되는 페이지 삭제를 요청합니다. Xenu의 Link Sleuth를 사용하여 깨진 링크와 404 페이지를 식별할 수 있습니다. 그런 다음 수정하십시오.

큰 웹사이트를 감사하는 사이트 의 모든 우선순위 문제를 말했지만 결과는 엄청났습니다!