ソーシャル ポストの自己分類は、オンライン スピーチのモデレートにおける主な問題を改善しますか?

公開: 2022-12-16コンテンツ モデレーションは現在、ソーシャル メディア サークルでホットなトピックです。Elon Musk が Twitter の改革に取り組んでいると同時に、ソーシャル メディア アプリが特定の議論を制御する力を獲得しすぎていることを示す例として、過去のモデレーション アクションを公開しています。

しかし、マスク氏はプロセス中に認識された欠陥を強調しているにもかかわらず、今の問題は、それをどのように修正するかということです. コンテンツの決定を、事実上、プラットフォーム自体を担当する幹部の小さなチームの手に委ねることができない場合、代替手段は何ですか?

外部の専門家のパネルによるメタの実験は、一般的には成功していますが、それでも、その監視委員会はすべてのコンテンツの決定を裁定することはできず、メタは、この代替手段にもかかわらず、認識された検閲と偏見について依然として激しい批判を受けています。アピールの。

あるレベルでは、意思決定の一部の要素は、別の経路が考えられない限り、必然的にプラットフォーム管理に当てはまります。

個人的な好みに基づく代替フィードは、そのような問題に対処する別の方法になるでしょうか?

一部のプラットフォームはこれを検討しています。 ワシントンポストが報じたように、 TikTokは現在、「成熟した」コンテンツが若い視聴者のフィードに表示されないようにするために、「コンテンツレベル」と呼ばれるコンセプトを模索しています.

TikTokは、特に危険な挑戦の傾向に関して、この面でますます精査されてきており、危険な行為に参加した結果、一部の若者が殺されています.

イーロン マスクも、「Twitter 2.0」に対する彼のより広いビジョンの一部として、同様のコンテンツ コントロール アプローチを宣伝しています。

いい視点ね。

— イーロン・マスク (@elonmusk) 2022 年 10 月 29 日

映画の成熟度の評価と同じように、必要な Twitter のバージョンを選択できる方がよいでしょう。

ツイート自体の評価は自分で選択し、ユーザーのフィードバックによって変更できます。

Musk のバリエーションでは、ユーザーはツイートをアップロードするときに自分のツイートを自己分類し、読者は自分の成熟度評価などを適用して、潜在的に有害なコンテンツを別のカテゴリに移動することもできます。

両方の場合の最終結果は、ユーザーがアプリでのさまざまなレベルのエクスペリエンスから選択できることを意味します – より極端なコメントや議論を除外する「安全」から「フィルターなし」まで (Musk はおそらく'hardcore') を使用すると、完全な体験が得られます。

理論的にはどれが興味深いように思えますが、実際には、ユーザーは実際に自分のツイートを自己分類し、このタイプのフィルタリングの実行可能なオプションにするのに十分な頻度でこれらの評価を正しく取得するでしょうか?

もちろん、プラットフォームは、ツイートを正しく分類しない、または分類できなかった場合に処罰を実装できます。 おそらく、再犯者の場合、すべてのツイートがより極端なセグメンテーションに自動的にフィルター処理されますが、他の人はコンテンツを両方またはすべてのストリームに表示することで、最大の視聴者リーチを得ることができます.

構成プロセス内で分類を選択する際に、ユーザーにとってより多くの手動作業が必要になりますが、それによっていくつかの懸念が軽減されるのではないでしょうか?

しかし、繰り返しになりますが、ソーシャルプラットフォームがヘイトスピーチを増幅し、危険な動きを助長するために使用されるのを止めることはできません.

Twitter やその他のソーシャル アプリがユーザーを検閲するように変更されたほとんどの場合、それは害を及ぼす恐れがあるためであり、人々がコメントによって気分を害したからではありません。

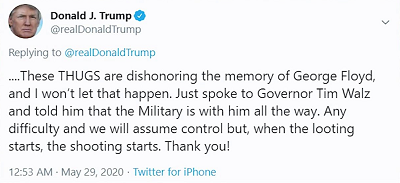

たとえば、ドナルド・トランプ前大統領が投稿したとき:

懸念は、彼の「略奪が始まれば発砲が始まる」という彼のコメントに人々が嫌悪感を抱くということではなく、トランプの支持者がこれを本質的に、大統領が効果的に支持することで、これを殺害のライセンスと見なす可能性があるということでした。略奪者を抑止するための致命的な力の使用。

論理的には、ソーシャル プラットフォームは、潜在的な害をこのように広めるためにツールが使用されることを望んでいません。この点で、自己検閲や投稿の成熟度評価の選択は、その重要な問題を解決しません。そのようなコメントを表示しないことを選択したユーザーから、そのようなコメントを非表示にするだけです。

言い換えれば、これはセキュリティの向上というより難読化です - しかし、多くの人は、人々がオンラインでそのようなことを言ったり、言いたいと思ったりすることではなく、他の人がそのようなことで気分を害することにあると考えているようです.

それは問題ではありません。潜在的に不快な素材を隠すことは、特にTikTokの場合、若い視聴者にとって露出を減らすのにある程度の価値があるかもしれませんが、人々がソーシャルアプリの巨大なリーチの可能性を利用して憎悪を広めるのを止めることはできません.そして危険な行動喚起であり、実際に現実世界に害を及ぼす可能性があります。

本質的に、それは断片的な提供であり、場合によってはある程度の影響を与える責任の希薄化ですが、ソーシャルプラットフォームが作成したツールやシステムが危険な目的で使用されないようにするための中核的な責任には対処しません.目的。

彼らはそうであり、これからもそうであり続けるからです。 ソーシャル プラットフォームは、市民の不安、政治的暴動、暴動、軍事クーデターなどを助長するために使用されてきました。

ちょうど今週、「エチオピアでの暴力的で憎悪に満ちた投稿がFacebook上で盛んになり、国の血なまぐさい内戦に火をつける」ことを許可したとして、メタに対して新たな法的措置が開始されました。 訴訟は、結果として生じた暴力の被害者に 20 億ドルの損害賠償を求めています。

反対するのは政治的意見だけではありません。ソーシャル メディア プラットフォームを使用して、実際の危険な運動を促進することができます。

このような場合、いくら自己認証を行っても役に立たない可能性があります。これらのタイプの最悪のシナリオに確実に対処するために、プラットフォームには常にルールを設定する責任があります。

それ、またはルールは、そのような影響を測定するように設計された政府や機関によって、より高いレベルで設定され、それに応じて行動する必要があります.

しかし結局のところ、ここでの核心的な問題は、多くの「言論の自由」支持者が推進しているように、人々が言いたいことを言い、好きなことを共有できるようにするソーシャル プラットフォームに関するものではありません。 あるレベルでは、常に制限があり、常にガードレールがあり、ソーシャル投稿の増幅の可能性を考えると、時にはそれらは国の法律をはるかに超えて広がる可能性があります.

簡単な答えはありませんが、国民の意思に任せていては、すべての面で状況が好転するわけではありません。