L'autoclassificazione dei post sui social migliorerebbe i problemi chiave nella moderazione del discorso online?

Pubblicato: 2022-12-16La moderazione dei contenuti è attualmente un argomento caldo nei circoli dei social media, poiché Elon Musk si occupa di riformare Twitter, pubblicando contemporaneamente azioni di moderazione passate, a dimostrazione di come le app dei social media abbiano acquisito troppo potere per controllare determinate discussioni.

Ma nonostante Musk evidenzi i difetti percepiti nel processo, la domanda ora è: come risolverlo? Se non ci si può fidare delle decisioni sui contenuti nelle mani, effettivamente, di piccoli team di dirigenti responsabili delle piattaforme stesse, allora qual è l'alternativa?

L'esperimento di Meta con un gruppo di esperti esterni è stato, in generale, un successo, ma anche in questo caso, il suo consiglio di sorveglianza non può giudicare ogni decisione sui contenuti e Meta è ancora oggetto di pesanti critiche per la censura e il pregiudizio percepiti, nonostante questo mezzo alternativo di appello.

A un certo livello, alcuni elementi del processo decisionale ricadranno inevitabilmente sulla gestione della piattaforma, a meno che non si possa concepire un altro percorso.

I feed alternativi, basati sulle preferenze personali, potrebbero essere un altro modo per affrontare questo problema?

Alcune piattaforme stanno esaminando questo aspetto. Come riportato dal Washington Post, TikTok sta attualmente esplorando un concetto che chiama "Livelli di contenuto", nel tentativo di impedire che i contenuti "per adulti" appaiano nei feed degli spettatori più giovani.

TikTok è stato oggetto di un controllo sempre più attento su questo fronte, in particolare per quanto riguarda le pericolose tendenze delle sfide, che hanno visto alcuni giovani uccisi a causa della partecipazione ad atti rischiosi.

Elon Musk ha anche pubblicizzato un simile approccio al controllo dei contenuti come parte della sua visione più ampia per "Twitter 2.0".

Buon punto.

— Elon Musk (@elonmusk) 29 ottobre 2022

Essere in grado di selezionare la versione di Twitter che desideri è probabilmente migliore, proprio come lo sarebbe per una valutazione della maturità di un film.

La valutazione del tweet stesso potrebbe essere selezionata autonomamente, quindi modificata dal feedback degli utenti.

Nella variazione di Musk, gli utenti autoclassificherebbero i propri tweet mentre li caricano, con i lettori quindi anche in grado di applicare anche la propria classificazione di maturità, in qualche modo, per aiutare a spostare i contenuti potenzialmente dannosi in una categoria separata.

Il risultato finale in entrambi i casi significherebbe che gli utenti sarebbero quindi in grado di scegliere tra diversi livelli di esperienza nell'app: da "sicuro", che filtrerebbe i commenti e le discussioni più estremi, a "non filtrato" (Musk probabilmente andrebbe con 'hardcore'), che ti darebbe l'esperienza completa.

Il che sembra interessante, in teoria, ma in realtà, gli utenti autoclassificherebbero effettivamente i propri tweet e otterrebbero queste valutazioni corrette abbastanza spesso da renderlo un'opzione praticabile per questo tipo di filtro?

Ovviamente, la piattaforma potrebbe implementare punizioni per la mancata classificazione o per la mancata classificazione corretta dei tuoi tweet. Forse, per i recidivi, tutti i loro tweet vengono automaticamente filtrati nella segmentazione più estrema, mentre altri possono ottenere la massima copertura del pubblico visualizzando i loro contenuti in entrambi o in tutti gli stream.

Richiederebbe più lavoro manuale per gli utenti, nella selezione di una classificazione all'interno del processo di composizione, ma forse questo potrebbe alleviare alcune preoccupazioni?

Ma ancora una volta, questo non impedirebbe comunque alle piattaforme social di essere utilizzate per amplificare l'incitamento all'odio e alimentare movimenti pericolosi.

Nella maggior parte dei casi in cui Twitter, o altre app social, sono state spostate per censurare gli utenti, è stato a causa della minaccia di danno, non perché le persone siano necessariamente offese dai commenti fatti.

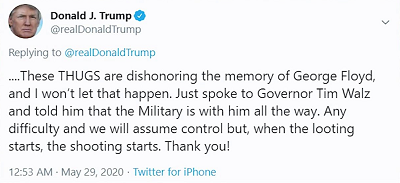

Ad esempio, quando l'ex presidente Donald Trump ha pubblicato:

La preoccupazione non era tanto che le persone sarebbero state offese dal suo commento "quando inizia il saccheggio, iniziano le sparatorie", la preoccupazione era più che i sostenitori di Trump potessero prenderlo come, essenzialmente, una licenza per uccidere, con il presidente che effettivamente approvava l'uso della forza mortale per scoraggiare i saccheggiatori.

Le piattaforme social, logicamente, non vogliono che i loro strumenti vengano utilizzati per diffondere potenziali danni in questo modo e, a questo proposito, l'autocensura o la selezione di un livello di maturità per i tuoi post non risolverà quel problema chiave, lo farà basta nascondere tali commenti agli utenti che scelgono di non vederli.

In altre parole, è più offuscamento che miglioramento della sicurezza, ma molti sembrano credere che il problema principale non sia che le persone dicono e vogliono dire queste cose online, ma che altri ne sono offesi.

Non è questo il problema e, sebbene nascondere materiale potenzialmente offensivo potrebbe avere un certo valore nel ridurre l'esposizione, in particolare, nel caso di TikTok, per il pubblico più giovane, non impedirà comunque alle persone di utilizzare l'enorme potenziale di copertura delle app social per diffondere odio e pericolosi inviti all'azione, che possono effettivamente portare a danni nel mondo reale.

In sostanza, è un'offerta frammentaria, una diluizione della responsabilità che avrà un certo impatto, in alcuni casi, ma non affronterà la responsabilità fondamentale delle piattaforme social per garantire che gli strumenti e i sistemi che hanno creato non vengano utilizzati per scopi pericolosi scopo.

Perché lo sono e continueranno ad esserlo. Le piattaforme social sono state utilizzate per alimentare disordini civili, rivolte politiche, rivolte, colpi di stato militari e altro ancora.

Proprio questa settimana è stata avviata una nuova azione legale contro Meta per aver permesso a ' post violenti e odiosi in Etiopia di fiorire su Facebook, infiammando la sanguinosa guerra civile del Paese '. La causa sta facendo causa per $ 2 miliardi di danni per le vittime della violenza che ne è derivata.

Non si tratta solo di opinioni politiche con cui non sei d'accordo, le piattaforme di social media possono essere utilizzate per alimentare movimenti reali e pericolosi.

In tali casi, è probabile che nessuna quantità di autocertificazione sia di aiuto: ci sarà sempre un certo onere sulle piattaforme per stabilire le regole, al fine di garantire che questi tipi di scenari peggiori vengano affrontati.

Quello, o le regole devono essere stabilite a un livello più alto, da governi e agenzie designate per misurare l'impatto di tali, e agire di conseguenza.

Ma alla fine, il problema centrale qui non riguarda le piattaforme social che consentono alle persone di dire ciò che vogliono e condividere ciò che vogliono, come stanno spingendo molti sostenitori della "libertà di parola". A un certo livello, ci saranno sempre limiti, ci saranno sempre guardrail e, a volte, potrebbero estendersi oltre le leggi del paese, dato il potenziale di amplificazione dei posti sociali.

Non ci sono risposte facili, ma lasciare che sia la volontà della gente difficilmente porterà a una situazione migliore su tutti i fronti.