Siapa yang bertanggung jawab atas kualitas data? Matriks tanggung jawab untuk tim analitik

Diterbitkan: 2022-06-11Karena data berkualitas buruk dapat membuat tindakan lebih lanjut menjadi tidak berguna (seperti menghitung atribusi, mengirimkan tawaran ke layanan periklanan, atau membuat laporan), memastikan kualitas data terus menjadi tantangan terbesar dalam analitik digital. Adalah umum untuk mengatakan bahwa analis bertanggung jawab atas semua masalah terkait data. Tapi apakah ini benar?

Siapa yang bertanggung jawab atas kualitas data di perusahaan? Berlawanan dengan kepercayaan populer, bukan hanya para analis. Misalnya, pemasar bekerja dengan tag UTM, insinyur menerapkan kode pelacakan, dll. Jadi, tidak mengherankan jika terjadi kekacauan saat bekerja dengan data: setiap karyawan memiliki banyak tugas, dan tidak jelas siapa yang melakukan apa, siapa yang bertanggung jawab atas apa, dan siapa yang harus dimintai hasilnya.

Dalam artikel ini, kami mencoba memahami siapa yang bertanggung jawab atas kualitas data di setiap tahap dan cara mengelolanya.

Daftar Isi

- alur kerja data

- 1. Mengumpulkan data primer

- 2. Mengimpor data ke dalam gudang data

- 3. Mempersiapkan tampilan SQL

- 4. Menyiapkan data siap bisnis

- 5. Menyiapkan data mart

- 6. Memvisualisasikan data

- takeaways kunci

- Tautan yang berguna

alur kerja data

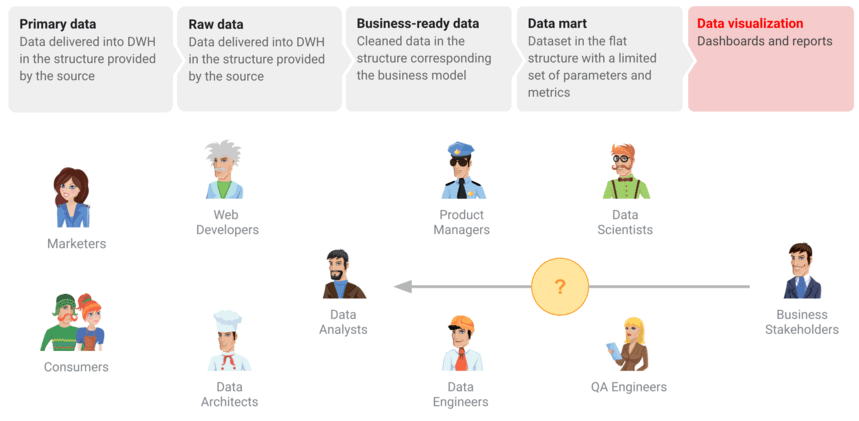

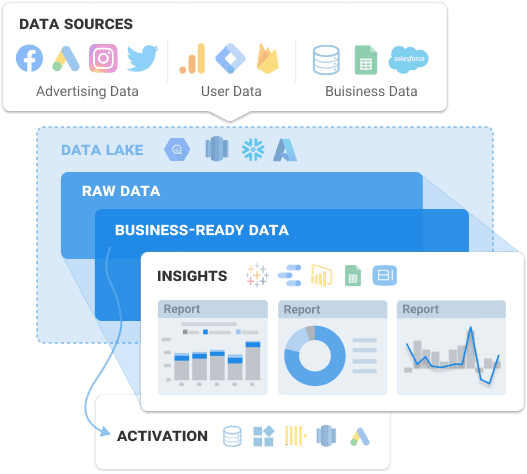

Bahkan dalam satu perusahaan, dunia data dapat dipenuhi dengan perbedaan dan kesalahpahaman. Untuk memberdayakan pengguna bisnis dengan data berkualitas dan menghindari kehilangan data berharga, Anda perlu merencanakan pengumpulan semua data pemasaran yang diperlukan. Dengan menyiapkan alur kerja data, Anda mendemonstrasikan bagaimana data terkait untuk kolega di semua departemen sehingga menjadi mudah untuk menghubungkan titik-titik. Namun, itu hanya langkah pertama. Mari kita lihat apa langkah lain dalam menyiapkan data untuk laporan dan dasbor:

- Siapkan pengumpulan data primer.

- Mengumpulkan data mentah ke dalam penyimpanan data atau database.

- Ubah data mentah menjadi data siap-bisnis, dengan markup, yang dibersihkan dan dalam struktur yang dapat dipahami oleh bisnis.

- Siapkan data mart — struktur datar yang berfungsi sebagai sumber data untuk memvisualisasikan data.

- Visualisasikan data untuk dasbor.

Namun, terlepas dari semua persiapan, pengambil keputusan sering kali menghadapi laporan atau dasbor dengan data berkualitas buruk. Dan hal pertama yang mereka lakukan adalah beralih ke analis dengan pertanyaan: Mengapa ada perbedaan? atau Apakah datanya relevan di sini?

Namun, kenyataannya adalah bahwa spesialis yang berbeda terlibat dalam proses ini: insinyur data terlibat dalam menyiapkan sistem analitik, pemasar menambahkan tag UTM, pengguna memasukkan data. Mari kita lihat secara detail tahapan apa yang harus Anda lalui dan bagaimana penerapannya untuk menyediakan data berkualitas tinggi kepada pengguna.

Klien kami

tumbuh 22% lebih cepat

Tumbuh lebih cepat dengan mengukur apa yang paling berhasil dalam pemasaran Anda

Analisis efisiensi pemasaran Anda, temukan area pertumbuhan, tingkatkan ROI

Dapatkan demo1. Mengumpulkan data primer

Meskipun langkah ini terlihat paling mudah, ada beberapa kendala tersembunyi. Pertama-tama, Anda harus merencanakan untuk mengumpulkan semua data dari semua sumber, dengan memperhitungkan semua titik kontak pelanggan. Terkadang langkah perencanaan ini dilewati, tetapi melakukannya tidak masuk akal dan berisiko. Mengambil pendekatan tidak terstruktur menyebabkan mendapatkan data yang tidak lengkap atau salah.

Tantangan utamanya adalah Anda harus mengumpulkan data yang terfragmentasi dari berbagai platform dan layanan periklanan yang Anda gunakan. Karena memproses array data besar dalam waktu sesingkat mungkin rumit dan intensif sumber daya, mari kita lihat kemungkinan kemacetan yang mungkin muncul:

- Tidak semua halaman memiliki penampung GTM yang terpasang, dan oleh karena itu data tidak dikirim ke Google Analytics.

- Akun baru di platform periklanan dibuat, tetapi analis tidak diberi tahu dan data tidak dikumpulkan darinya.

- API tidak mendukung parameter dinamis dalam tag UTM dan tidak mengumpulkan atau mentransfernya.

- Kartu yang terhubung ke proyek Google Cloud memiliki dana atau kredit yang tidak mencukupi.

- Validasi data yang dimasukkan oleh pengguna salah.

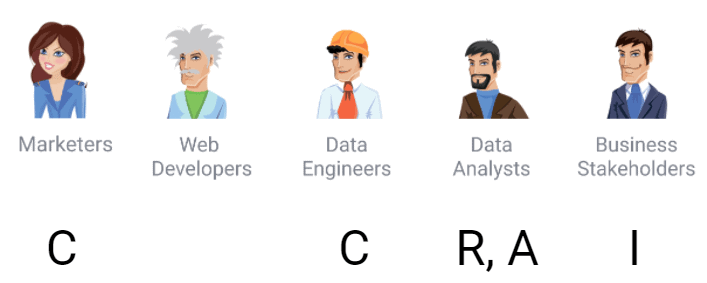

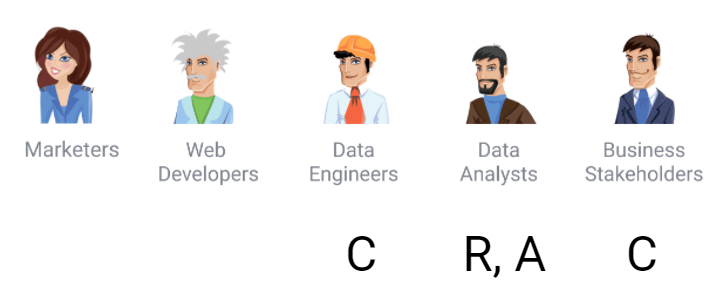

Selama langkah ini, di antara semua tantangan lainnya, Anda harus mempertimbangkan untuk mengontrol akses ke data. Untuk ini, kami merekomendasikan penggunaan matriks RACI klasik yang mendefinisikan peran untuk proses dan menekankan siapa yang melakukan, mengontrol, mengelola, dan bertanggung jawab atas apa. Berikut adalah kemungkinan peran:

- R (Bertanggung jawab) — seseorang yang bertanggung jawab dan merupakan pelaksana dari proses tertentu

- C (Consulted) — orang yang berkonsultasi dan menyediakan data yang diperlukan untuk mengimplementasikan proses

- A (Akuntabilitas atau Penyetuju) — seseorang yang bertanggung jawab atas hasil pekerjaan

- I (Informed) — orang yang harus diberitahu tentang kemajuan pekerjaan

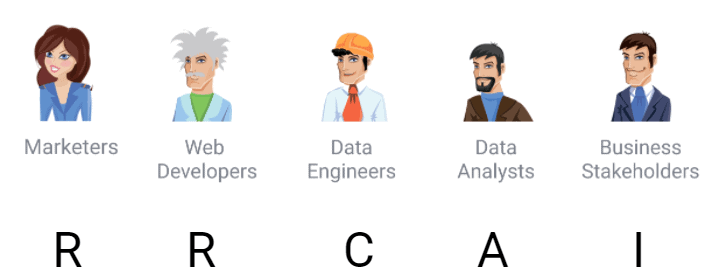

Menurut matriks RACI, peran dan tanggung jawab pengumpulan data terlihat seperti ini:

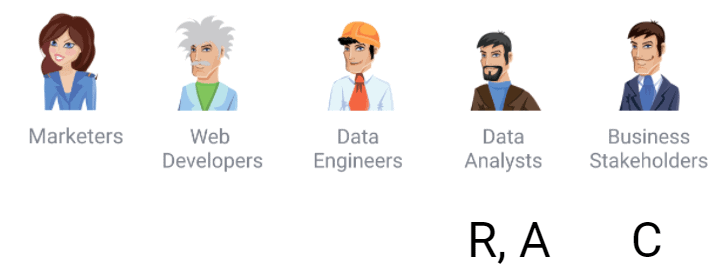

2. Mengimpor data ke dalam gudang data

Langkah selanjutnya adalah memutuskan di mana akan menyimpan semua data yang diperoleh. Jika Anda ingin mendapatkan kontrol penuh atas data mentah Anda tanpa mengubahnya, sebaiknya gunakan penyimpanan tunggal dengan impor data otomatis. Karena menggunakan server Anda sendiri untuk menyimpan setiap byte data akan menghabiskan banyak biaya, kami sarankan untuk menggunakan solusi cloud yang menghemat sumber daya Anda dan menyediakan akses ke data di mana saja.

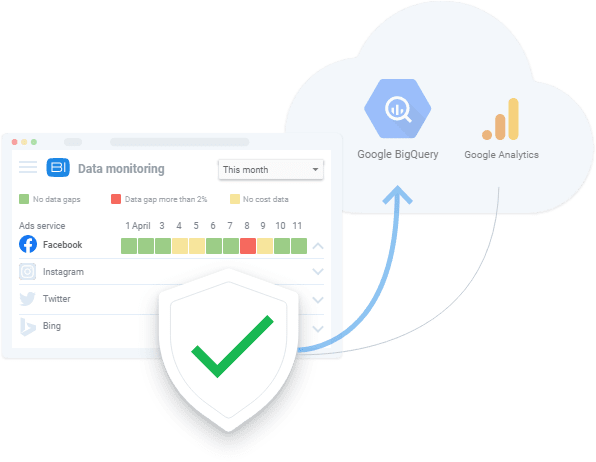

Opsi terbaik untuk tugas ini adalah Google BigQuery, karena mempertimbangkan kebutuhan pemasar dan dapat digunakan untuk menyimpan data mentah dari situs web, sistem CRM, platform periklanan, dll. Saat ini, ada banyak sekali solusi perangkat lunak pemasaran. Kami merekomendasikan OWOX BI, yang secara otomatis mengumpulkan data ke dalam gudang data (atau data lake) dari berbagai layanan dan situs web.

Mari kita lihat kesalahan klasik apa yang dapat terjadi saat mengumpulkan data mentah:

- API layanan periklanan telah berubah. Dengan demikian, format data juga telah berubah.

- API layanan eksternal tidak tersedia. Pemangku kepentingan melihat angka-angka tertentu di akun pribadi mereka, tetapi API dari layanan periklanan yang sama memberikan data lain. Data ini tidak cocok karena, seperti dalam sistem terdistribusi mana pun, sumber data untuk API layanan periklanan berbeda dengan sumber data untuk portal web.

- Data di antarmuka web dan API layanan eksternal berbeda. Format dokumentasi dan pemrosesan data bisa berbeda. Misalnya, kesalahan yang menarik di salah satu layanan periklanan populer adalah bahwa pengeluaran adalah nol baik ketika tidak ada maupun ketika sebenarnya nol. Semua insinyur dan analis data tahu bahwa nol dan Null adalah nilai yang berbeda dan diproses secara berbeda. Dalam satu kasus, pengeluaran ini mungkin muncul dan harus diminta lagi, dan nol berarti bahwa pengeluaran tersebut benar-benar tidak ada dan dihitung sebagai nol.

- API layanan eksternal menyediakan data yang salah.

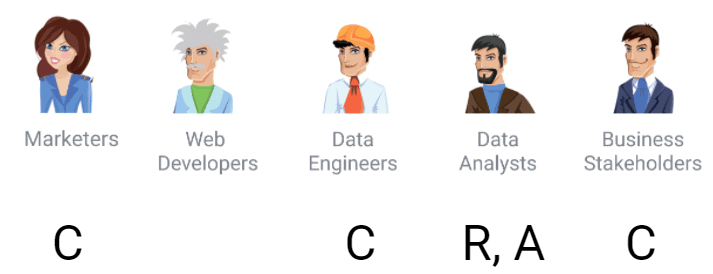

Menurut matriks, dalam proses ini, pemasar adalah konsultan dan sumber pengetahuan: misalnya, pengetahuan tentang akun apa yang Anda butuhkan untuk mengunduh data, apa tag UTM, dan markup pada kampanye iklan.

Ada juga pengembang yang ingin mengetahui perubahan apa yang akan terjadi pada penampung jika Google Pengelola Tag digunakan, karena mereka bertanggung jawab atas kecepatan unduhan situs web.

Pada titik ini, insinyur data sudah melakukan peran yang bertanggung jawab karena mereka mengonfigurasi jalur pipa data. Dan analis bertanggung jawab atas hasil pekerjaan. Bahkan jika satu karyawan melakukan fungsi ini, sebenarnya akan ada dua peran. Jadi jika perusahaan hanya memiliki satu analis, kami tetap merekomendasikan penerapan matriks berdasarkan peran. Kemudian, dengan pertumbuhan perusahaan, Anda akan memiliki deskripsi pekerjaan untuk kolega baru, dan akan menjadi jelas apa tanggung jawab untuk peran tertentu.

Pemangku kepentingan pada tahap ini tertarik untuk mengetahui data apa yang tersedia dan masalah apa yang ada dengan kualitasnya, karena mengidentifikasi prioritas dan sumber daya yang ditujukan untuk mengumpulkan data. Misalnya, fitur Pemantauan Data OWOX BI diterapkan secara luas oleh klien kami.

3. Mempersiapkan tampilan SQL

Persiapan data adalah langkah selanjutnya. Ini sering disebut persiapan data mart — ini adalah struktur datar yang berisi parameter dan metrik yang akan ditampilkan di dasbor. Seorang analis yang memiliki keterbatasan alat, anggaran, dan waktu seringkali melewatkan tahap penyiapan data bisnis dan langsung menyiapkan data mart. Sepertinya data mentah yang dikumpulkan di gudang data. Kemudian, ada sejuta kueri SQL yang berbeda bersama dengan skrip Python dan R — dan kekacauan ini akan menghasilkan sesuatu di dasbor.

Jika Anda terus melewatkan persiapan data siap-bisnis, itu akan menyebabkan kesalahan berulang yang perlu diperbaiki di setiap sumber. Hal-hal lain yang bisa salah termasuk:

- Kesalahan reguler dalam data primer

- Logika bisnis diduplikasi di semua kueri SQL

- Banyak waktu yang dibutuhkan untuk menemukan penyebab perbedaan data

- Waktu untuk menyempurnakan data mart yang ada menjadi sebanding dengan waktu untuk menulis ulang permintaan

- Logika laporan yang tidak dapat dipahami oleh pelanggan

Contoh kesalahan yang paling sederhana dan paling umum adalah definisi pengguna baru dan pengguna kembali . Sebagian besar bisnis tidak membuat perbedaan ini dengan cara yang sama seperti Google Analytics. Oleh karena itu, logika definisi tipe pengguna sering diduplikasi dalam laporan yang berbeda. Kesalahan yang sering terjadi juga mencakup logika laporan yang tidak dapat dipahami. Hal pertama yang akan ditanyakan oleh pelanggan bisnis ketika melihat laporan adalah bagaimana laporan itu dibuat, asumsi apa yang mendasarinya, mengapa data itu digunakan, dan sebagainya. Oleh karena itu, persiapan data bisnis adalah tahap yang tidak boleh Anda lewatkan. Membangun data mart dari data mentah seperti tidak mencuci sayur dan buah sebelum memakannya.

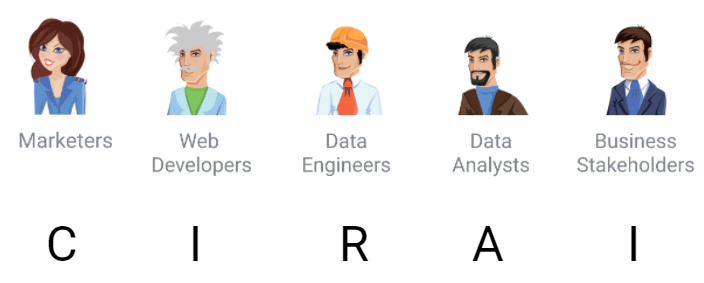

Jika kita menetapkan tanggung jawab sesuai dengan matriks, maka untuk persiapan data, kita akan mendapatkan ini:

4. Menyiapkan data siap bisnis

Data siap-bisnis adalah kumpulan data akhir yang dibersihkan yang sesuai dengan model bisnis. Ini adalah data siap pakai yang dapat dikirim ke layanan visualisasi data apa pun (Power BI, Tableau, Google Data Studio, dll.).

Secara alami, bisnis yang berbeda beroperasi dengan model yang berbeda. Misalnya, definisi "pengguna", "pengguna B2B", "transaksi, "prospek", dll. akan memiliki arti yang berbeda untuk perusahaan yang berbeda. Objek bisnis ini sebenarnya menjawab pertanyaan tentang bagaimana bisnis berpikir tentang model bisnisnya dalam hal data. Ini adalah deskripsi bisnis pada intinya dan bukan struktur peristiwa di Google Analytics.

Model data memungkinkan semua karyawan untuk menyinkronkan dan memiliki pemahaman umum tentang bagaimana data digunakan dan apa yang dipahami tentangnya. Oleh karena itu, mengubah data mentah menjadi data siap-bisnis merupakan tahap penting yang tidak dapat dilewati.

Apa yang bisa salah pada tahap ini:

- Tidak jelas model data mana yang dimiliki/digunakan perusahaan

- Sulit untuk mempersiapkan dan memelihara data simulasi

- Sulit untuk mengontrol perubahan dalam logika transformasi

Di sini, Anda perlu memutuskan model data mana yang akan dipilih dan bagaimana mengontrol perubahan dalam logika transformasi data. Dengan demikian, ini adalah peran peserta dalam proses perubahan:

Stakeholder tidak lagi hanya sekedar menginformasikan tetapi menjadi konsultan. Mereka membuat keputusan seperti apa yang harus dipahami sebagai pengguna baru atau kembali. Tugas analis pada tahap ini adalah melibatkan sebanyak mungkin pemangku kepentingan dalam pengambilan keputusan tersebut. Jika tidak, hal terbaik yang bisa terjadi adalah analis akan diminta untuk mengulang laporannya.

Berdasarkan pengalaman kami, beberapa perusahaan masih belum menyiapkan data siap-bisnis dan membuat laporan berdasarkan data mentah. Masalah utama dengan pendekatan ini adalah debugging tanpa akhir dan penulisan ulang kueri SQL. Dalam jangka panjang, lebih murah dan lebih mudah untuk bekerja dengan data yang telah disiapkan daripada menggunakan data mentah untuk melakukan hal yang sama berulang kali.

OWOX BI secara otomatis mengumpulkan data mentah dari berbagai sumber dan mengubahnya menjadi format yang ramah laporan. Hasilnya, Anda menerima kumpulan data siap pakai yang secara otomatis diubah menjadi struktur yang diinginkan, dengan mempertimbangkan nuansa penting bagi pemasar. Anda tidak perlu menghabiskan waktu untuk mengembangkan dan mendukung transformasi kompleks, mempelajari struktur data, dan menghabiskan waktu berjam-jam mencari penyebab perbedaan.

Pesan demo gratis untuk melihat bagaimana OWOX BI membantu menyiapkan data bisnis dan bagaimana Anda dapat memperoleh manfaat dari manajemen data yang sepenuhnya otomatis hari ini.

5. Menyiapkan data mart

Tahap selanjutnya adalah menyiapkan data mart. Sederhananya, ini adalah tabel yang disiapkan yang berisi data persis yang dibutuhkan oleh pengguna tertentu dari departemen tertentu, yang membuatnya lebih mudah untuk diterapkan.

Mengapa analis membutuhkan data mart, dan mengapa Anda tidak melewatkan tahap ini? Pemasar dan karyawan lain tanpa keterampilan analitis merasa sulit untuk bekerja dengan data mentah. Tugas analis adalah menyediakan semua karyawan akses ke data dalam bentuk yang paling nyaman sehingga mereka tidak perlu menulis kueri SQL yang rumit setiap saat.

Sebuah data mart membantu memecahkan masalah ini. Memang, dengan pengisian yang kompeten, itu akan mencakup irisan data yang diperlukan untuk pekerjaan departemen tertentu. Dan rekan kerja akan tahu persis bagaimana menggunakan database seperti itu dan akan memahami konteks parameter dan metrik yang disajikan di dalamnya.

Kasus utama di mana terjadi kesalahan saat menyiapkan data mart adalah:

- Logika penggabungan data tidak dapat dipahami. Misalnya, mungkin ada data dari aplikasi seluler dan situs web, dan Anda perlu memutuskan cara menggabungkannya dan dengan kunci mana, atau memutuskan cara menggabungkan kampanye iklan dengan aktivitas di aplikasi seluler. Ada banyak pertanyaan. Dengan membuat keputusan ini saat menyiapkan data bisnis, kami membuatnya sekali dan nilainya lebih besar daripada keputusan yang dibuat ad-hoc untuk laporan tertentu di sini dan sekarang. Keputusan ad-hoc semacam itu harus dibuat berulang kali.

- Kueri SQL tidak berjalan karena keterbatasan teknis gudang data. Menyiapkan data bisnis adalah salah satu cara untuk membersihkan data dan membawanya ke dalam struktur simulasi yang akan membuatnya lebih murah untuk memproses dan mempercepat kueri.

- Tidak jelas bagaimana cara memeriksa kualitas data .

Mari kita lihat siapa yang bertanggung jawab untuk apa pada tahap ini menurut matriks:

Jelas bahwa persiapan data adalah tanggung jawab analis data bersama dengan pemangku kepentingan dan insinyur data, yang merupakan konsultan dalam prosesnya. Perhatikan bahwa analis OWOX BI dapat menangani tugas ini untuk Anda. Kami dapat mengumpulkan dan menggabungkan data, memodelkannya untuk model bisnis Anda, dan menyiapkan data mart disertai dengan instruksi mendetail dengan deskripsi logika build, yang memungkinkan Anda membuat perubahan di pihak Anda jika perlu (misalnya, menambahkan bidang baru).

6. Memvisualisasikan data

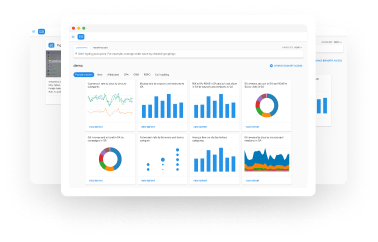

Menyajikan data secara visual dalam laporan dan dasbor adalah tahap akhir di mana semuanya sebenarnya dimulai. Jelas, data harus disajikan dengan cara yang informatif dan ramah pengguna. Belum lagi visualisasi yang otomatis dan dikonfigurasi dengan benar secara signifikan mengurangi waktu untuk menemukan zona risiko, masalah, dan kemungkinan pertumbuhan.

Jika Anda telah menyiapkan data siap-bisnis dan data mart, Anda tidak akan mengalami kesulitan dengan visualisasi. Namun, ada juga bisa muncul kesalahan seperti:

- Data yang tidak relevan di data mart. Jika bisnis tidak yakin tentang kualitas data, bahkan jika data berkualitas tinggi, langkah pertama adalah pelanggan bisnis meminta analis untuk memeriksa ulang semuanya. Ini tidak efisien. Jelas bahwa bisnis ingin dilindungi dari kesalahan dan tidak terburu-buru mengambil kesimpulan. Oleh karena itu, kualitas data yang tinggi merupakan jaminan bahwa seseorang akan menggunakannya nanti.

- Memilih metode visualisasi data yang salah.

- Tidak menjelaskan dengan benar kepada pelanggan logika perhitungan metrik dan parameter. Seringkali, bagi pelanggan bisnis yang tidak menguasai SQL dan metrik untuk menginterpretasikan data dengan benar, mereka perlu melihat arti setiap metrik dalam konteks laporan, cara penghitungannya, dan alasannya. Analis tidak boleh lupa bahwa siapa pun yang menggunakan laporan harus memiliki akses ke penjelasan tentang apa yang ada di balik laporan, asumsi apa yang menjadi inti laporan, dll.

Menurut matriks RACI, analis sudah memiliki peran ganda — pemberi persetujuan dan bertanggung jawab . Pemangku kepentingan adalah konsultan di sini, dan kemungkinan besar mereka telah menjawab sebelumnya pertanyaan tentang keputusan apa yang mereka rencanakan dan hipotesis apa yang ingin mereka uji. Hipotesis ini membentuk dasar untuk desain visualisasi yang digunakan analis.

takeaways kunci

Matriks RACI bukanlah jawaban untuk semua kemungkinan pertanyaan tentang bekerja dengan data, tetapi pasti dapat memudahkan implementasi dan penerapan aliran data di perusahaan Anda.

Karena orang-orang dalam peran yang berbeda terlibat dalam tahapan aliran data yang berbeda, adalah salah untuk berasumsi bahwa analis bertanggung jawab penuh atas kualitas data. Kualitas data juga menjadi tanggung jawab semua kolega yang terlibat dalam markup data, pengiriman, persiapan, atau keputusan manajemen.

Semua data selalu berkualitas buruk, dan tidak mungkin untuk menghilangkan perbedaan data secara permanen, membuat data konsisten, dan menghilangkan noise dan duplikasi. Ini selalu terjadi, terutama dalam realitas data yang berubah begitu cepat dan dinamis seperti pemasaran. Namun, Anda dapat secara proaktif mengidentifikasi masalah ini dan menetapkan tujuan untuk membuat kualitas data Anda diketahui. Misalnya, Anda dapat memperoleh jawaban atas pertanyaan seperti: Kapan data diperbarui? Dalam perincian apa data tersedia? Kesalahan apa dalam data yang kita ketahui? dan Metrik apa yang dapat kami gunakan?

Bagi mereka yang ingin berkontribusi untuk meningkatkan kualitas data perusahaan mereka, kami merekomendasikan tiga langkah sederhana:

- Buat skema aliran data. Misalnya, gunakan Miro dan buat sketsa bagaimana perusahaan Anda menggunakan data. Anda akan terkejut betapa banyak pendapat yang berbeda tentang skema ini dalam satu perusahaan.

- Kumpulkan matriks tanggung jawab dan sepakati siapa yang bertanggung jawab atas apa, setidaknya di atas kertas.

- Menjelaskan model data bisnis.

Memiliki keahlian bertahun-tahun, tim OWOX BI tahu bagaimana tanggung jawab harus dialokasikan dan apa yang dibutuhkan oleh para analis. Berdasarkan pengetahuan ini, kami telah menyiapkan template matriks alokasi tanggung jawab untuk tim analis.

Dapatkan matriksnya

Selain itu, tim OWOX BI dapat membantu Anda mengonfigurasi dan mengotomatiskan semua langkah data yang dijelaskan dalam artikel ini. Jika Anda memerlukan bantuan dengan tugas-tugas ini atau ingin mengaudit analitik dan sistem kualitas data Anda, pesan demo.

Tautan yang berguna

- Data Gelap: Mengapa Apa yang Tidak Anda Ketahui Penting oleh David J. Hand

- Sinyal dan Kebisingan: Mengapa Begitu Banyak Prediksi Gagal--tetapi Beberapa Tidak oleh Nate Silver

- Diprediksi Tidak Rasional oleh Dr. Dan Ariely

- Kera Irasional: Mengapa Kita Terjerat Disinformasi, Teori Konspirasi, dan Propaganda oleh David Robert Grimes

- Pengalaman "Ekosistem Data" oleh Antriksh Goel