Audit de site prioritaire en six points pour les grands sites Web sur une mise à jour post-Panda

Publié: 2011-12-13Je crois que Google Panda, la Grande Purge fait en effet d'Internet une meilleure source d'informations, mais pour ces énormes sites Web touchés, c'est un monstre différent à gérer pour eux.

Dans la plupart des cas, le référencement de sites Web volumineux sur une mise à jour post-Panda traite normalement de son architecture d'informations et, en corrigeant la structure de la page, apporte une amélioration considérable du trafic, du taux de rebond et des SERP.

Cependant; devant gérer d'énormes sites Web, les stratèges Web ou les référenceurs sont toujours confrontés à des contraintes de temps et à une limitation des priorités à traiter en premier afin de voir des améliorations en moins de temps. Bien sûr, les patrons voudront toujours des résultats immédiats comme s'ils devaient être disponibles comme "hier".

J'ai donc préparé un audit de site prioritaire en six points pour les sites Web d'entreprise comme suit pour aider à identifier les priorités :

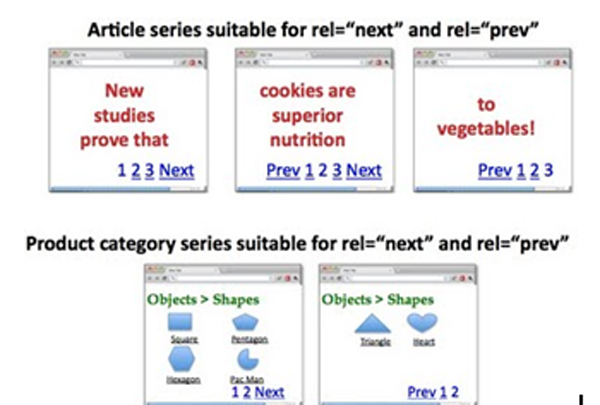

I. Indexation des pages de pagination des adresses et consolidation des passes de jus de liens

La pagination est toujours une tâche délicate concernant les grands sites qui est souvent le résultat d'habitudes de codage erronées par des développeurs qui ne sont pas concernés par la duplication des pages.

Comment implémenter : rel=”prev” et rel=”next” ?

Page 1 : http://www.example.com/page1.html

<link rel=”canonical” href=”http://www.example.com/page1.html” />

<link rel=”next” href=”http://www.example.com/page2.html” />

Page 2 : http://www.example.com/page2.html

<link rel=”canonical” href=”http://www.example.com/page2.html” />

<link rel=”prev” href=”http://www.example.com/page1.html” />

<link rel=”next” href=”http://www.example.com/page2.html” />

….

Dernière page:

<link rel=”canonical” href=”http://www.example.com/lastpage.html” />

<link rel=”prev” href=”http://www.example.com/secondtothelastpage.html” />

Option:

L'inclusion de la page "tout afficher" peut également être une bonne stratégie que nous souhaitons que Google indexe plutôt que les pages de composants. Nous pouvons le faire en utilisant rel = "canonical" pointant vers la page de visualisation complète. TOUTEFOIS; si la latence des pages est élevée, mieux vaut s'en tenir à la stratégie rel=”prev” et rel=”next”.

II. Résoudre les problèmes de duplication des méta-titres et des méta-descriptions dans GWT

Pour résoudre les problèmes de doublons sur les méta-titres et descriptions dans GWT, nous devons recoder les titres et descriptions générés en tant que tels.

Comment implémenter de bons Titres sur des pages paginées ?

Page 1 : Titre ici avec mots-clés

Page 2 : Page 2 sur 4, Titre ici avec mots-clés

Page 3 : Page 3 sur 4, Titre ici avec mots-clés

En effet, nous avons :

<tête>

<link rel=”canonical” href=”http://www.example.com/page2.html” />

<link rel=”prev” href=”http://www.example.com/page1.html” />

<link rel=”next” href=”http://www.example.com/page2.html” />

<title> Page 2 sur 4, Titre ici avec mots-clés</title>

</head>

Comment implémenter des Meta Descriptions meilleures et uniques ?

Page 2:

<title>Page 2 sur 4, Titre ici avec mots-clés</title>

<meta name=”description” content=”>Listes de 11-20 (sur 30) Titre ici avec mots-clés” />

* Les mots-clés de marque sur le titre peuvent être supprimés pour s'adapter à d'autres mots-clés locaux ou de longue traine

Ou

Vous pouvez simplement laisser vides les méta-descriptions des pages de composants pour laisser les robots diriger le trafic et le poids vers les premières pages que nous avons toujours voulues.

III. Resoumission du plan du site des pages importantes pour renforcer la hiérarchisation de la recherche d'informations et l'utilisation de "noindex, follow"

Nous sommes tous conscients que la resoumission des sitemaps sert à la priorisation des pages les plus importantes du site à indexer et à peser correctement par les moteurs de recherche.

Comment implémenter « noindex,follow » sur les pages les moins importantes ?

Insertion des <meta name=”robots” content='noindex, follow' /> ou pour être plus précis pour les Google Bots, utilisez <meta name=”googlebot” content='noindex, follow' />

- Il est important de noter que l'utilisation de "noindex, follow" sur les pages de composants (pages 2, 3, etc.) doit être mise en œuvre pour éliminer les contenus presque dupliqués souvent interprétés par Google comme des contenus légers.

- Si les pages de composants d'un ensemble de pages sont jugées nécessaires, le "noindex, follow" peut être supprimé

Prenez note que ce n'est pas une bonne pratique de concentrer vos efforts sur TOUTES les pages d'un site Web d'entreprise, mais plutôt de vous concentrer simplement sur les pages importantes où vous pouvez vouloir amener votre public à visiter.

Histoire:

La pratique de créer des centaines de milliers de pages ou même des millions de pages à l'époque juste pour faire croire à Google que le site Web est un site Web d'autorité n'est plus applicable de nos jours. PANDA vous fera même grincer des dents en créant ces "contenus légers" sur votre site Web.

IV. Baisser le TAUX DE REBOND

BOUNCE RATE est un indicateur de la pertinence du site Google pour les utilisateurs sur leurs résultats de recherche. Search Opt Media Inc. estime que cela a beaucoup d'impact sur le classement de nos jours. Cela ne pouvait plus être ignoré.

Comment y remédier ?

Visez des titres de page qui se rapportent au contenu de la page. Lorsque quelqu'un clique sur un résultat de recherche, il aura au moins lu le titre. Maintenant, si votre H1 est très différent de cela, il y a de fortes chances que les gens quittent votre site tout de suite, en supposant qu'il n'offre pas ce qu'ils recherchent.

Plus encore, l'offre d'un bon contenu pertinent pour le résultat de la recherche est vraiment demandée.

Comment mettre en œuvre ?

Le titre, H1, les méta-descriptions et la copie du document doivent afficher le contenu pertinent des résultats de recherche.

IMPORTANT : les rédacteurs de contenu doivent prendre cela au sérieux.

V. Augmenter la VITESSE DU SITE

Les mises à jour Mayday, Caffeine et PANDA concernent l'expérience utilisateur, en particulier la vitesse du site. Encore une fois, cela est basé sur le principe d'offrir une excellente expérience utilisateur sur le site Web. Plus le site devient rapide, plus les utilisateurs restent longtemps sur votre site, plus les visites de retour sont élevées et tout suivra pour être dans les charts. C'est ce que veut Google.

La vitesse du site peut être un problème côté serveur ou un problème côté application. J'ai énuméré ci-dessous les choses que vous devez faire pour accélérer votre site Web.

Comment tester et identifier des « parties » spécifiques du site Web qui affectent fortement la vitesse du site ?

Outils à utiliser :

- http://www.webpagetest.org

- http://www.websiteoptimization.com/services/analyze/

- http://tools.pingdom.com/

- https://addons.mozilla.org/en-US/firefox/addon/firebug/

- https://addons.mozilla.org/en-US/firefox/addon/YSlow/

- https://code.google.com/speed/page-speed/download.html

Search Opt Media Inc. a identifié les outils ci-dessus pour tester et calibrer les performances de la vitesse du site. Les numéros 1 à 6 sont de bons outils !

Sur le problème côté serveur, je recommanderais ce qui suit ci-dessous :

1. Utilisez CDN - Je pense que vous l'utilisez déjà.

2. Utiliser le système de mise en cache

VI. Nettoyer les 404 pages trouvées dans Google Webmaster Tools (GWT)

Demande de suppression des pages 404 sur GWT ainsi que des pages renvoyant aux pages 404. Vous pouvez utiliser Xenu's Link Sleuth pour identifier les liens brisés et les pages 404. Après cela, corrigez-les.

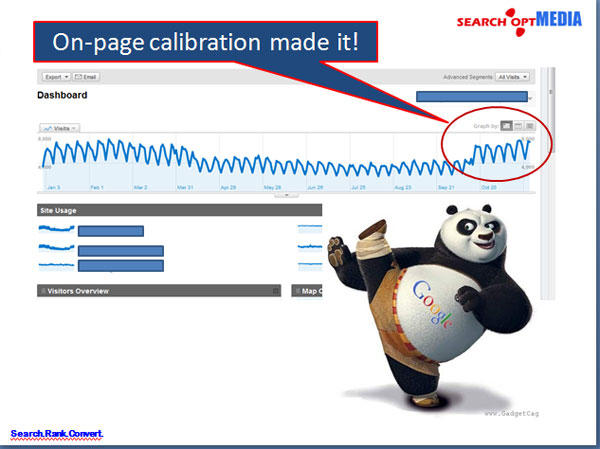

Après avoir dit toutes les questions prioritaires sur l' audit de site de grands sites Web , le résultat est formidable !