L'auto-classification des publications sur les réseaux sociaux résoudrait-elle les principaux problèmes de modération de la parole en ligne ?

Publié: 2022-12-16La modération de contenu est un sujet brûlant dans les cercles des médias sociaux à l'heure actuelle, alors qu'Elon Musk s'emploie à réformer Twitter, tout en publiant simultanément les actions de modération passées, comme une illustration de la façon dont les applications de médias sociaux ont acquis trop de pouvoir pour contrôler certaines discussions.

Mais bien que Musk ait mis en évidence les défauts perçus dans le processus, la question est maintenant de savoir comment y remédier ? Si les décisions de contenu ne peuvent pas être confiées à de petites équipes de cadres responsables des plates-formes elles-mêmes, alors quelle est l'alternative ?

L'expérience de Meta avec un panel d'experts externes a, en général, été un succès, mais même dans ce cas, son conseil de surveillance ne peut pas se prononcer sur chaque décision de contenu, et Meta fait toujours l'objet de vives critiques pour la censure et les préjugés perçus, malgré ces moyens alternatifs. d'appel.

À un certain niveau, certains éléments de la prise de décision incomberont inévitablement à la gestion de la plate-forme, à moins qu'une autre voie ne puisse être conçue.

Les flux alternatifs, basés sur les préférences personnelles, pourraient-ils être une autre façon d'aborder ce problème ?

Certaines plateformes se penchent là-dessus. Comme le rapporte le Washington Post, TikTok explore actuellement un concept qu'il appelle "Niveaux de contenu", dans le but d'empêcher le contenu "mature" d'apparaître dans les flux des jeunes téléspectateurs.

TikTok fait l'objet d'un examen de plus en plus minutieux sur ce front, en particulier en ce qui concerne les tendances dangereuses des défis, qui ont vu certains jeunes tués pour avoir participé à des actes à risque.

Elon Musk a également vanté une approche similaire de contrôle du contenu dans le cadre de sa vision plus large de "Twitter 2.0".

Bon point.

– Elon Musk (@elonmusk) 29 octobre 2022

Pouvoir sélectionner la version de Twitter que vous voulez est probablement préférable, tout comme ce serait le cas pour une évaluation de la maturité d'un film.

La note du tweet lui-même pourrait être auto-sélectionnée, puis modifiée par les commentaires des utilisateurs.

Dans la variante de Musk, les utilisateurs classifieraient eux-mêmes leurs tweets au fur et à mesure qu'ils les téléchargeraient, les lecteurs pouvant alors également appliquer leur propre note de maturité, en quelque sorte, pour aider à déplacer le contenu potentiellement dangereux dans une catégorie distincte.

Le résultat final dans les deux cas signifierait que les utilisateurs pourraient alors choisir parmi différents niveaux d'expérience dans l'application - de "sûr", qui filtrerait les commentaires et les discussions les plus extrêmes, à "non filtré" (Musk irait probablement avec 'hardcore'), ce qui vous donnerait une expérience complète.

Ce qui semble intéressant, en théorie - mais en réalité, les utilisateurs classifieraient-ils eux-mêmes leurs tweets, et obtiendraient-ils ces notes correctes assez souvent pour en faire une option viable pour ce type de filtrage ?

Bien sûr, la plate-forme pourrait mettre en place des sanctions pour ne pas classer ou ne pas classer correctement vos tweets. Peut-être que, pour les récidivistes, tous leurs tweets sont automatiquement filtrés dans la segmentation la plus extrême, tandis que d'autres peuvent atteindre une audience maximale en affichant leur contenu dans les deux ou dans tous les flux.

Cela nécessiterait plus de travail manuel pour les utilisateurs, dans la sélection d'une classification dans le processus de composition, mais peut-être que cela pourrait atténuer certaines inquiétudes ?

Mais là encore, cela n'empêcherait toujours pas les plateformes sociales d'être utilisées pour amplifier les discours de haine et alimenter des mouvements dangereux.

Dans la plupart des cas où Twitter, ou d'autres applications sociales, ont été déplacés pour censurer les utilisateurs, c'est à cause de la menace de préjudice, pas parce que les gens sont nécessairement offensés par les commentaires faits.

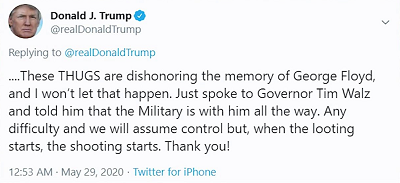

Par exemple, lorsque l'ancien président Donald Trump a publié :

L'inquiétude n'était pas tant que les gens seraient offensés par son commentaire "quand le pillage commence, le tournage commence", l'inquiétude était plus que les partisans de Trump pourraient considérer cela comme, essentiellement, un permis de tuer, le président approuvant effectivement l'usage de la force létale pour dissuader les pillards.

Les plates-formes sociales, logiquement, ne veulent pas que leurs outils soient utilisés pour propager un préjudice potentiel de cette manière, et à cet égard, l'autocensure ou la sélection d'une note de maturité pour vos messages ne résoudra pas ce problème clé, il cachez simplement ces commentaires aux utilisateurs qui choisissent de ne pas les voir.

En d'autres termes, il s'agit plus d'obscurcissement que d'amélioration de la sécurité - mais beaucoup semblent croire que le problème principal n'est pas que les gens disent et veulent dire de telles choses en ligne, mais que d'autres en soient offensés.

Ce n'est pas le problème, et bien que cacher du matériel potentiellement offensant puisse avoir une certaine valeur pour réduire l'exposition, en particulier, dans le cas de TikTok, pour un public plus jeune, cela n'empêchera toujours pas les gens d'utiliser le potentiel de portée massif des applications sociales pour répandre la haine et des appels à l'action dangereux, qui peuvent en effet entraîner des dommages dans le monde réel.

Essentiellement, il s'agit d'une offre au coup par coup, une dilution de la responsabilité qui aura un certain impact, dans certains cas, mais qui n'abordera pas la responsabilité essentielle des plateformes sociales pour s'assurer que les outils et les systèmes qu'elles ont créés ne sont pas utilisés à des fins dangereuses. objectif.

Parce qu'ils le sont et qu'ils le resteront. Les plateformes sociales ont été utilisées pour alimenter les troubles civils, les soulèvements politiques, les émeutes, les coups d'État militaires et plus encore.

Pas plus tard que cette semaine, une nouvelle action en justice a été lancée contre Meta pour avoir autorisé « des publications violentes et haineuses en Éthiopie à prospérer sur Facebook, enflammant la guerre civile sanglante du pays ». Le procès réclame 2 milliards de dollars de dommages-intérêts pour les victimes de la violence qui en a résulté.

Il ne s'agit pas seulement d'opinions politiques avec lesquelles vous n'êtes pas d'accord, les plateformes de médias sociaux peuvent être utilisées pour alimenter des mouvements réels et dangereux.

Dans de tels cas, aucune quantité d'auto-certification n'est susceptible d'aider - il incombera toujours aux plates-formes de définir les règles, afin de garantir que ces types de scénarios les plus défavorables sont traités.

Cela, ou les règles doivent être fixées à un niveau supérieur, par les gouvernements et les agences conçues pour en mesurer l'impact et agir en conséquence.

Mais en fin de compte, le problème central ici n'est pas les plateformes sociales permettant aux gens de dire ce qu'ils veulent et de partager ce qu'ils aiment, comme le demandent de nombreux défenseurs de la « liberté d'expression ». À un certain niveau, il y aura toujours des limites, il y aura toujours des garde-fous, et parfois, ils peuvent bien aller au-delà des lois du pays, étant donné le potentiel d'amplification des postes sociaux.

Il n'y a pas de réponses faciles, mais s'en remettre à la volonté du peuple n'est pas susceptible d'améliorer la situation sur tous les fronts.