Détection d'anomalies : guide pour prévenir les intrusions sur le réseau

Publié: 2023-01-09Les données sont un élément indispensable des entreprises et des organisations, et elles ne sont utiles que lorsqu'elles sont correctement structurées et gérées efficacement.

Selon des statistiques, 95 % des entreprises trouvent aujourd'hui problématique la gestion et la structuration des données non structurées.

C'est là qu'intervient l'exploration de données. C'est le processus de découverte, d'analyse et d'extraction de modèles significatifs et d'informations précieuses à partir de grands ensembles de données non structurées.

Les entreprises utilisent des logiciels pour identifier des modèles dans de grands lots de données afin d'en savoir plus sur leurs clients et leur public cible et de développer des stratégies commerciales et marketing pour améliorer les ventes et réduire les coûts.

Outre cet avantage, la fraude et la détection d'anomalies sont les applications les plus importantes de l'exploration de données.

Cet article explique la détection des anomalies et explore plus en détail comment elle peut aider à prévenir les violations de données et les intrusions sur le réseau pour assurer la sécurité des données.

Qu'est-ce que la détection d'anomalies et ses types ?

Alors que l'exploration de données implique de trouver des modèles, des corrélations et des tendances qui sont liées entre elles, c'est un excellent moyen de trouver des anomalies ou des points de données aberrants au sein du réseau.

Les anomalies dans l'exploration de données sont des points de données qui diffèrent des autres points de données dans l'ensemble de données et s'écartent du modèle de comportement normal de l'ensemble de données.

Les anomalies peuvent être classées en types et catégories distincts, notamment :

- Changements dans les événements : faites référence à des changements soudains ou systématiques par rapport au comportement normal précédent.

- Valeurs aberrantes : petits modèles anormaux apparaissant de manière non systématique dans la collecte de données. Celles-ci peuvent être classées en valeurs aberrantes globales, contextuelles et collectives.

- Dérive : modification graduelle, non directionnelle et à long terme de l'ensemble de données.

Ainsi, la détection d'anomalies est une technique de traitement de données très utile pour détecter les transactions frauduleuses, gérer des études de cas avec un déséquilibre de classe élevée et détecter des maladies pour construire des modèles de science des données robustes.

Par exemple, une entreprise peut vouloir analyser ses flux de trésorerie pour trouver des transactions anormales ou récurrentes sur un compte bancaire inconnu afin de détecter une fraude et de mener une enquête plus approfondie.

Avantages de la détection d'anomalies

La détection des anomalies de comportement des utilisateurs contribue à renforcer les systèmes de sécurité et les rend plus précis et précis.

Il analyse et donne un sens aux diverses informations fournies par les systèmes de sécurité pour identifier les menaces et les risques potentiels au sein du réseau.

Voici les avantages de la détection d'anomalies pour les entreprises :

- Détection en temps réel des menaces de cybersécurité et des violations de données, car ses algorithmes d'intelligence artificielle (IA) analysent en permanence vos données pour détecter un comportement inhabituel.

- Il rend le suivi des activités et des modèles anormaux plus rapide et plus facile que la détection manuelle des anomalies, réduisant ainsi le travail et le temps nécessaires pour résoudre les menaces.

- Minimise les risques opérationnels en identifiant les erreurs opérationnelles, telles que les baisses soudaines de performances, avant même qu'elles ne se produisent.

- Il aide à éliminer les dommages commerciaux majeurs en détectant rapidement les anomalies, car sans système de détection des anomalies, les entreprises peuvent prendre des semaines et des mois pour identifier les menaces potentielles.

Ainsi, la détection des anomalies est un atout considérable pour les entreprises qui stockent de vastes ensembles de données clients et commerciales afin de trouver des opportunités de croissance et d'éliminer les menaces de sécurité et les goulots d'étranglement opérationnels.

Techniques de détection d'anomalies

La détection des anomalies utilise plusieurs procédures et algorithmes d'apprentissage automatique (ML) pour surveiller les données et détecter les menaces.

Voici les principales techniques de détection d'anomalies :

#1. Techniques d'apprentissage automatique

Les techniques d'apprentissage automatique utilisent des algorithmes de ML pour analyser les données et détecter les anomalies. Les différents types d'algorithmes d'apprentissage automatique pour la détection d'anomalies incluent :

- Algorithmes de clustering

- Algorithmes de classification

- Algorithmes d'apprentissage profond

Et les techniques de ML couramment utilisées pour la détection des anomalies et des menaces incluent les machines à vecteurs de support (SVM), le clustering k-means et les encodeurs automatiques.

#2. Techniques de statistique

Les techniques statistiques utilisent des modèles statistiques pour détecter des modèles inhabituels (comme des fluctuations inhabituelles des performances d'une machine particulière) dans les données afin de détecter des valeurs qui dépassent la plage des valeurs attendues.

Les techniques courantes de détection des anomalies statistiques comprennent les tests d'hypothèse, l'IQR, le score Z, le score Z modifié, l'estimation de la densité, la boîte à moustaches, l'analyse des valeurs extrêmes et l'histogramme.

#3. Techniques d'exploration de données

Les techniques d'exploration de données utilisent des techniques de classification et de regroupement des données pour trouver des anomalies dans l'ensemble de données. Certaines techniques courantes d'anomalies d'exploration de données incluent le regroupement spectral, le regroupement basé sur la densité et l'analyse en composantes principales.

Les algorithmes d'exploration de données de clustering sont utilisés pour regrouper différents points de données en clusters en fonction de leur similitude pour trouver des points de données et des anomalies se trouvant en dehors de ces clusters.

D'autre part, les algorithmes de classification allouent des points de données à des classes prédéfinies spécifiques et détectent les points de données qui n'appartiennent pas à ces classes.

#4. Techniques basées sur des règles

Comme leur nom l'indique, les techniques de détection d'anomalies basées sur des règles utilisent un ensemble de règles prédéterminées pour trouver des anomalies dans les données.

Ces techniques sont relativement plus faciles et simples à mettre en place, mais peuvent être inflexibles et ne pas être efficaces pour s'adapter à l'évolution du comportement et des modèles de données.

Par exemple, vous pouvez facilement programmer un système basé sur des règles pour signaler les transactions dépassant un montant spécifique en dollars comme frauduleuses.

#5. Techniques spécifiques à un domaine

Vous pouvez utiliser des techniques spécifiques à un domaine pour détecter des anomalies dans des systèmes de données spécifiques. Cependant, alors qu'ils peuvent être très efficaces pour détecter des anomalies dans des domaines spécifiques, ils peuvent être moins efficaces dans d'autres domaines en dehors de celui spécifié.

Par exemple, en utilisant des techniques spécifiques à un domaine, vous pouvez concevoir des techniques spécifiquement pour trouver des anomalies dans les transactions financières. Mais, ils peuvent ne pas fonctionner pour trouver des anomalies ou des baisses de performances dans une machine.

Besoin d'apprentissage automatique pour la détection d'anomalies

L'apprentissage automatique est très important et très utile dans la détection d'anomalies.

Aujourd'hui, la plupart des entreprises et des organisations nécessitant une détection des valeurs aberrantes traitent d'énormes quantités de données, allant du texte, des informations client et des transactions aux fichiers multimédias tels que les images et le contenu vidéo.

Passer en revue toutes les transactions bancaires et les données générées manuellement chaque seconde pour générer des informations significatives est presque impossible. De plus, la plupart des entreprises sont confrontées à des défis et à des difficultés majeures pour structurer des données non structurées et organiser les données de manière significative pour l'analyse des données.

C'est là que des outils et des techniques comme l'apprentissage automatique (ML) jouent un rôle énorme dans la collecte, le nettoyage, la structuration, l'organisation, l'analyse et le stockage d'énormes volumes de données non structurées.

Les techniques et algorithmes d'apprentissage automatique traitent de grands ensembles de données et offrent la flexibilité d'utiliser et de combiner différentes techniques et algorithmes pour fournir les meilleurs résultats.

En outre, l'apprentissage automatique permet également de rationaliser les processus de détection d'anomalies pour les applications du monde réel et d'économiser des ressources précieuses.

Voici quelques autres avantages et l'importance de l'apprentissage automatique dans la détection d'anomalies :

- Il facilite la détection des anomalies de mise à l'échelle en automatisant l'identification des modèles et des anomalies sans nécessiter de programmation explicite.

- Les algorithmes d'apprentissage automatique sont hautement adaptables à l'évolution des modèles d'ensembles de données, ce qui les rend très efficaces et robustes dans le temps.

- Gère facilement des ensembles de données volumineux et complexes, ce qui rend la détection des anomalies efficace malgré la complexité de l'ensemble de données.

- Assure l'identification et la détection précoces des anomalies en identifiant les anomalies au fur et à mesure qu'elles se produisent, ce qui permet d'économiser du temps et des ressources.

- Les systèmes de détection d'anomalies basés sur l'apprentissage automatique permettent d'atteindre des niveaux de précision plus élevés dans la détection d'anomalies par rapport aux méthodes traditionnelles.

Ainsi, la détection d'anomalies associée à l'apprentissage automatique permet une détection plus rapide et plus précoce des anomalies pour prévenir les menaces de sécurité et les violations malveillantes.

Algorithmes d'apprentissage automatique pour la détection d'anomalies

Vous pouvez détecter les anomalies et les valeurs aberrantes dans les données à l'aide de différents algorithmes d'exploration de données pour la classification, le regroupement ou l'apprentissage des règles d'association.

En règle générale, ces algorithmes d'exploration de données sont classés en deux catégories différentes : les algorithmes d'apprentissage supervisés et non supervisés.

Enseignement supervisé

L'apprentissage supervisé est un type courant d'algorithme d'apprentissage qui se compose d'algorithmes tels que les machines à vecteurs de support, la régression logistique et linéaire et la classification multiclasse. Ce type d'algorithme est entraîné sur des données étiquetées, ce qui signifie que son ensemble de données d'entraînement comprend à la fois des données d'entrée normales et des sorties correctes correspondantes ou des exemples anormaux pour construire un modèle prédictif.

Ainsi, son objectif est de faire des prédictions de sortie pour des données inédites et nouvelles basées sur les modèles d'ensemble de données d'apprentissage. Les applications des algorithmes d'apprentissage supervisé comprennent la reconnaissance d'images et de la parole, la modélisation prédictive et le traitement du langage naturel (TAL).

Apprentissage non supervisé

Apprentissage non supervisé n'est formé sur aucune donnée étiquetée. Au lieu de cela, il découvre des processus complexes et des structures de données sous-jacentes sans fournir les conseils de l'algorithme de formation et au lieu de faire des prédictions spécifiques.

Les applications des algorithmes d'apprentissage non supervisé comprennent la détection d'anomalies, l'estimation de densité et la compression de données.

Explorons maintenant certains algorithmes populaires de détection d'anomalies basés sur l'apprentissage automatique.

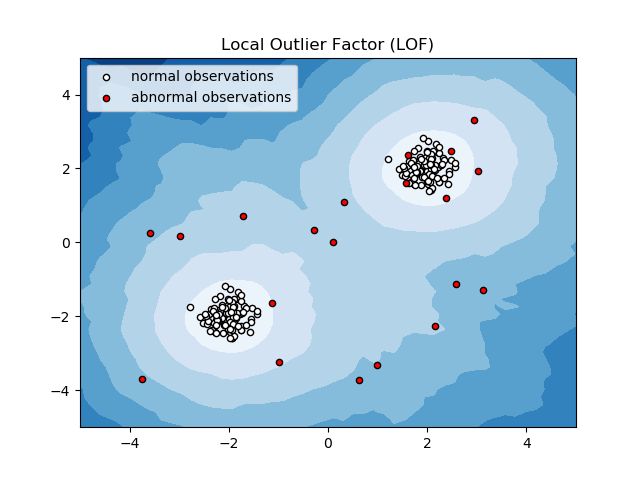

Facteur de valeur aberrante locale (LOF)

Local Outlier Factor ou LOF est un algorithme de détection d'anomalies qui prend en compte la densité de données locales pour déterminer si un point de données est une anomalie.

Il compare la densité locale d'un élément aux densités locales de ses voisins pour analyser les zones de densités similaires et les éléments avec des densités comparativement inférieures à celles de leurs voisins, qui ne sont que des anomalies ou des valeurs aberrantes.

Ainsi, en termes simples, la densité entourant un élément aberrant ou anormal diffère de la densité autour de ses voisins. Par conséquent, cet algorithme est également appelé algorithme de détection des valeurs aberrantes basé sur la densité.

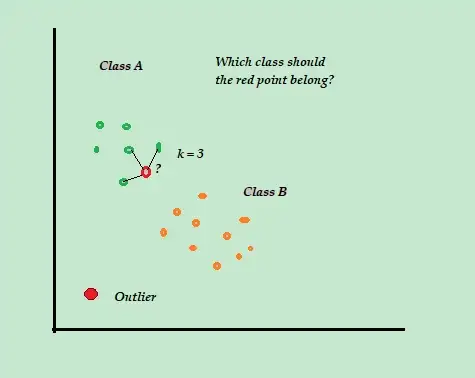

K-Voisin le plus proche (K-NN)

K-NN est l'algorithme de classification et de détection d'anomalies supervisé le plus simple, facile à mettre en œuvre, stocke tous les exemples et données disponibles et classe les nouveaux exemples en fonction des similitudes dans les métriques de distance.

Cet algorithme de classification est également appelé apprenant paresseux car il ne stocke que les données de formation étiquetées, sans rien faire d'autre pendant le processus de formation.

Lorsque le nouveau point de données d'apprentissage non étiqueté arrive, l'algorithme examine les points de données d'apprentissage K les plus proches ou les plus proches pour les utiliser pour classer et déterminer la classe du nouveau point de données non étiqueté.

L'algorithme K-NN utilise les méthodes de détection suivantes pour déterminer les points de données les plus proches :

- Distance euclidienne pour mesurer la distance des données continues.

- Distance de Hamming pour mesurer la proximité ou la "proximité" des deux chaînes de texte pour les données discrètes.

Par exemple, considérez que vos ensembles de données d'entraînement se composent de deux étiquettes de classe, A et B. Si un nouveau point de données arrive, l'algorithme calculera la distance entre le nouveau point de données et chacun des points de données de l'ensemble de données et sélectionnera les points. qui sont le nombre maximum le plus proche du nouveau point de données.

Donc, supposons que K = 3 et que 2 points de données sur 3 soient étiquetés comme A, alors le nouveau point de données est étiqueté comme classe A.

Par conséquent, l'algorithme K-NN fonctionne mieux dans les environnements dynamiques avec des exigences fréquentes de mise à jour des données.

Il s'agit d'un algorithme populaire de détection d'anomalies et d'exploration de texte avec des applications dans la finance et les entreprises pour détecter les transactions frauduleuses et augmenter le taux de détection des fraudes.

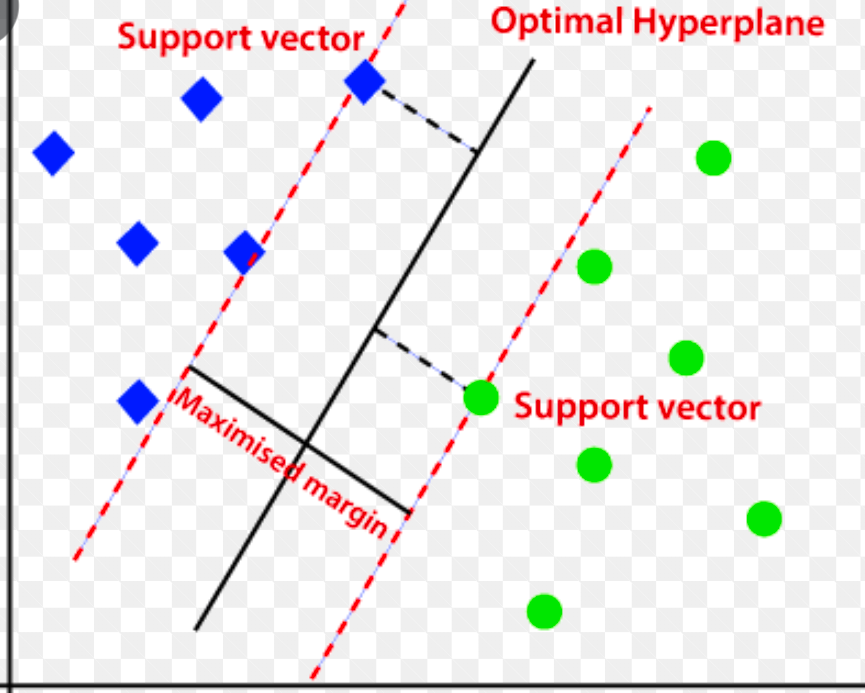

Machine à vecteurs de support (SVM)

La machine à vecteurs de support est un algorithme de détection d'anomalies basé sur l'apprentissage automatique supervisé, principalement utilisé dans les problèmes de régression et de classification.

Il utilise un hyperplan multidimensionnel pour séparer les données en deux groupes (nouveau et normal). Ainsi, l'hyperplan agit comme une frontière de décision qui sépare les observations de données normales et les nouvelles données.

La distance entre ces deux points de données est appelée marges.

Puisque le but est d'augmenter la distance entre les deux points, SVM détermine le meilleur ou l' hyperplan optimal avec la marge maximale pour s'assurer que la distance entre les deux classes est la plus large possible.

En ce qui concerne la détection d'anomalies, SVM calcule la marge de l'observation du nouveau point de données à partir de l'hyperplan pour le classer.

Si la marge dépasse le seuil fixé, il classe la nouvelle observation comme une anomalie. Dans le même temps, si la marge est inférieure au seuil, l'observation est classée comme normale.

Ainsi, les algorithmes SVM sont très efficaces pour gérer des ensembles de données complexes et de grande dimension.

Forêt d'isolement

Isolation Forest est un algorithme de détection d'anomalies d'apprentissage automatique non supervisé basé sur le concept d'un classificateur de forêt aléatoire.

Cet algorithme traite des données sous-échantillonnées de manière aléatoire dans l'ensemble de données dans une structure arborescente basée sur des attributs aléatoires. Il construit plusieurs arbres de décision pour isoler les observations. Et il considère une observation particulière comme une anomalie si elle est isolée dans moins d'arbres en fonction de son taux de contamination.

Ainsi, en termes simples, l'algorithme de la forêt d'isolement divise les points de données en différents arbres de décision, garantissant que chaque observation est isolée d'une autre.

Les anomalies se trouvent généralement loin du cluster de points de données, ce qui facilite l'identification des anomalies par rapport aux points de données normaux.

Les algorithmes de forêt d'isolement peuvent facilement gérer des données catégorielles et numériques. En conséquence, ils sont plus rapides à former et très efficaces pour détecter les anomalies de grande dimension et de grands ensembles de données.

Gamme interquartile

La plage interquartile ou IQR est utilisée pour mesurer la variabilité statistique ou la dispersion statistique afin de trouver des points anormaux dans les ensembles de données en les divisant en quartiles.

L'algorithme trie les données par ordre croissant et divise l'ensemble en quatre parties égales. Les valeurs séparant ces parties sont les Q1, Q2 et Q3 — premier, deuxième et troisième quartiles.

Voici la distribution centile de ces quartiles :

- Q1 signifie le 25e centile des données.

- Q2 signifie le 50e centile des données.

- Q3 signifie le 75e centile des données.

L'IQR est la différence entre les ensembles de données du troisième (75e) et du premier (25e) centile, ce qui représente 50 % des données.

L'utilisation de l'IQR pour la détection d'anomalies nécessite que vous calculiez l'IQR de votre ensemble de données et que vous définissiez les limites inférieure et supérieure des données pour trouver des anomalies.

- Limite inférieure : Q1 – 1,5 * IQR

- Limite supérieure : Q3 + 1,5 * IQR

Généralement, les observations situées en dehors de ces limites sont considérées comme des anomalies.

L'algorithme IQR est efficace pour les ensembles de données avec des données inégalement distribuées et où la distribution n'est pas bien comprise.

Derniers mots

Les risques de cybersécurité et les violations de données ne semblent pas diminuer dans les années à venir - et cette industrie à risque devrait encore se développer en 2023, et les cyberattaques IoT à elles seules devraient doubler d'ici 2025.

De plus, les cybercrimes coûteront aux entreprises et organisations mondiales environ 10,3 billions de dollars par an d'ici 2025.

C'est pourquoi le besoin de techniques de détection d'anomalies est de plus en plus répandu et nécessaire aujourd'hui pour la détection des fraudes et la prévention des intrusions sur le réseau.

Cet article vous aidera à comprendre ce que sont les anomalies dans l'exploration de données, les différents types d'anomalies et les moyens d'empêcher les intrusions sur le réseau à l'aide de techniques de détection d'anomalies basées sur ML.

Ensuite, vous pouvez tout explorer sur la matrice de confusion dans l'apprentissage automatique.