¿La autoclasificación de publicaciones sociales mejoraría los problemas clave en la moderación del discurso en línea?

Publicado: 2022-12-16La moderación de contenido es un tema candente en los círculos de las redes sociales en la actualidad, ya que Elon Musk se dedica a reformar Twitter y, al mismo tiempo, publica acciones de moderación pasadas, como una ilustración de cómo las aplicaciones de las redes sociales han ganado demasiado poder para controlar ciertas discusiones.

Pero a pesar de que Musk destacó las fallas percibidas en el proceso, la pregunta ahora es, ¿cómo solucionarlo? Si no se puede confiar en las decisiones de contenido en manos de pequeños equipos de ejecutivos a cargo de las propias plataformas, ¿cuál es la alternativa?

El experimento de Meta con un panel de expertos externos, en general, ha sido un éxito, pero incluso entonces, su Junta de Supervisión no puede adjudicar todas las decisiones de contenido, y Meta todavía recibe fuertes críticas por la censura y el sesgo percibidos, a pesar de este medio alternativo. de apelación

En algún nivel, algún elemento de la toma de decisiones recaerá inevitablemente en la gestión de la plataforma, a menos que se pueda concebir otro camino.

¿Podrían los feeds alternativos, basados en preferencias personales, ser otra forma de abordar esto?

Algunas plataformas están investigando esto. Según lo informado por The Washington Post, TikTok actualmente está explorando un concepto que llama 'Niveles de contenido', en un esfuerzo por evitar que el contenido 'maduro' aparezca en los feeds de los espectadores más jóvenes.

TikTok ha sido objeto de un escrutinio cada vez mayor en este frente, particularmente en lo que respecta a las tendencias de desafíos peligrosos, que han visto a algunos jóvenes asesinados como resultado de participar en actos de riesgo.

Elon Musk también ha promocionado un enfoque de control de contenido similar como parte de su visión más amplia de 'Twitter 2.0'.

Buen punto.

– Elon Musk (@elonmusk) 29 de octubre de 2022

Ser capaz de seleccionar qué versión de Twitter quieres es probablemente mejor, tanto como lo sería para una calificación de madurez de películas.

La calificación del tweet en sí podría ser autoseleccionada y luego modificada por los comentarios de los usuarios.

En la variación de Musk, los usuarios autoclasificarían sus tweets a medida que los cargan, y los lectores también podrían aplicar su propia calificación de madurez, para ayudar a cambiar el contenido potencialmente dañino a una categoría separada.

El resultado final en ambos casos significaría que los usuarios podrían seleccionar entre diferentes niveles de experiencia en la aplicación, desde 'seguro', que filtraría los comentarios y discusiones más extremos, hasta 'sin filtrar' (Musk probablemente diría con 'hardcore'), que le daría la experiencia completa.

Lo que suena interesante, en teoría, pero en realidad, ¿los usuarios realmente clasificarían sus tweets por sí mismos y obtendrían estas calificaciones correctas con la suficiente frecuencia como para que sea una opción viable para este tipo de filtrado?

Por supuesto, la plataforma podría implementar castigos por no clasificar o no clasificar correctamente tus tuits. Tal vez, para los infractores reincidentes, todos sus tweets se filtren automáticamente en la segmentación más extrema, mientras que otros pueden obtener el máximo alcance de audiencia al mostrar su contenido en ambas o en todas las transmisiones.

Requeriría más trabajo manual para los usuarios, al seleccionar una clasificación dentro del proceso de composición, pero ¿quizás eso podría aliviar algunas preocupaciones?

Pero, de nuevo, esto no impediría que las plataformas sociales se utilicen para amplificar el discurso de odio y alimentar movimientos peligrosos.

En la mayoría de los casos en los que Twitter, u otras aplicaciones sociales, se han movido para censurar a los usuarios, ha sido por la amenaza de daño, no porque las personas se sientan necesariamente ofendidas por los comentarios realizados.

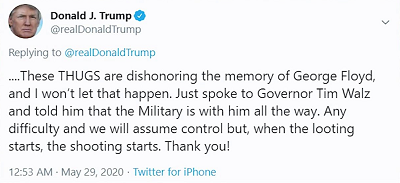

Por ejemplo, cuando el expresidente Donald Trump publicó:

La preocupación no era tanto que la gente se sintiera ofendida por su comentario 'cuando comienza el saqueo, comienza el tiroteo', la preocupación era más que los partidarios de Trump pudieran tomar esto como, esencialmente, una licencia para matar, con el presidente respaldando efectivamente el uso de la fuerza letal para disuadir a los saqueadores.

Las plataformas sociales, lógicamente, no quieren que sus herramientas se utilicen para propagar daños potenciales de esta manera y, en este sentido, la autocensura o la selección de una calificación de madurez para sus publicaciones no resolverá ese problema clave, lo hará. simplemente oculte dichos comentarios de los usuarios que eligen no verlos.

En otras palabras, es más una ofuscación que una seguridad mejorada, pero muchos parecen creer que el problema central no es que la gente diga y quiera decir tales cosas en línea, sino que otros se sientan ofendidos por eso.

Ese no es el problema, y si bien ocultar material potencialmente ofensivo podría tener algún valor para reducir la exposición, particularmente, en el caso de TikTok, para audiencias más jóvenes, aún no impedirá que las personas usen el potencial de alcance masivo de las aplicaciones sociales para difundir el odio. y peligrosos llamados a la acción, que de hecho pueden conducir a daños en el mundo real.

En esencia, es una oferta fragmentaria, una dilución de la responsabilidad que tendrá algún impacto, en algunos casos, pero no abordará la responsabilidad central de las plataformas sociales para garantizar que las herramientas y los sistemas que han creado no se utilicen para fines peligrosos. objetivo.

Porque lo son y lo seguirán siendo. Las plataformas sociales se han utilizado para alimentar disturbios civiles, levantamientos políticos, disturbios, golpes militares y más.

Apenas esta semana, se inició una nueva acción legal contra Meta por permitir que ' publicaciones violentas y odiosas en Etiopía florecieran en Facebook, inflamando la sangrienta guerra civil del país '. La demanda exige $ 2 mil millones en daños para las víctimas de la violencia resultante.

No se trata solo de opiniones políticas con las que no está de acuerdo, las plataformas de redes sociales pueden usarse para impulsar movimientos reales y peligrosos.

En tales casos, es probable que ninguna cantidad de autocertificación ayude: siempre habrá algo de responsabilidad en las plataformas para establecer las reglas, a fin de garantizar que se aborden estos tipos de escenarios del peor de los casos.

Eso, o las reglas deben establecerse a un nivel superior, por parte de los gobiernos y las agencias diseñadas para medir el impacto de las mismas, y actuar en consecuencia.

Pero al final, el problema central aquí no es sobre las plataformas sociales que permiten a las personas decir lo que quieren y compartir lo que les gusta, como muchos defensores de la 'libertad de expresión' están presionando. En algún nivel, siempre habrá límites, siempre habrá barandillas y, en ocasiones, es posible que se extiendan más allá de las leyes del país, dado el potencial de amplificación de los puestos sociales.

No hay respuestas fáciles, pero no es probable que dejarlo a la voluntad de la gente produzca una mejor situación en todos los frentes.