Würde die Selbstklassifizierung von Social Posts die Schlüsselprobleme bei der Moderation von Online-Rede verbessern?

Veröffentlicht: 2022-12-16Inhaltsmoderation ist derzeit ein heißes Thema in Social-Media-Kreisen, da Elon Musk Twitter reformiert und gleichzeitig vergangene Moderationsaktionen veröffentlicht, um zu veranschaulichen, wie Social-Media-Apps zu viel Macht erlangt haben, um bestimmte Diskussionen zu kontrollieren.

Aber obwohl Musk vermeintliche Mängel im Prozess hervorhebt, stellt sich nun die Frage, wie man sie behebt? Wenn Inhaltsentscheidungen effektiv nicht in die Hände kleiner Teams von Führungskräften gelegt werden können, die für die Plattformen selbst verantwortlich sind, was ist dann die Alternative?

Metas Experiment mit einem Gremium externer Experten war im Allgemeinen ein Erfolg, aber selbst dann kann sein Aufsichtsgremium nicht über jede Inhaltsentscheidung urteilen, und Meta wird trotz dieser alternativen Mittel immer noch heftig wegen wahrgenommener Zensur und Voreingenommenheit kritisiert der Beschwerde.

Auf einer bestimmten Ebene wird ein Element der Entscheidungsfindung unweigerlich dem Plattformmanagement zufallen, es sei denn, es ist ein anderer Weg denkbar.

Könnten alternative Feeds, basierend auf persönlichen Vorlieben, eine weitere Möglichkeit sein, solche Probleme anzugehen?

Einige Plattformen prüfen dies. Wie die Washington Post berichtet, untersucht TikTok derzeit ein Konzept, das es „Content Levels“ nennt, um zu verhindern, dass „erwachsene“ Inhalte in den Feeds jüngerer Zuschauer erscheinen.

TikTok wurde an dieser Front zunehmend unter die Lupe genommen, insbesondere im Hinblick auf gefährliche Challenge-Trends, bei denen einige Jugendliche aufgrund der Teilnahme an riskanten Handlungen getötet wurden.

Elon Musk hat im Rahmen seiner umfassenderen Vision für „Twitter 2.0“ einen ähnlichen Ansatz zur Inhaltskontrolle angepriesen.

Guter Punkt.

– Elon Musk (@elonmusk) 29. Oktober 2022

In der Lage zu sein, auszuwählen, welche Version von Twitter Sie möchten, ist wahrscheinlich besser, ähnlich wie es für eine Filmreifebewertung wäre.

Die Bewertung des Tweets selbst könnte selbst ausgewählt und dann durch Benutzerfeedback modifiziert werden.

In Musks Variante würden Benutzer ihre Tweets beim Hochladen selbst klassifizieren, wobei die Leser dann auch in der Lage wären, ihre eigene Alterseinstufung anzuwenden, um potenziell schädliche Inhalte in eine separate Kategorie zu verschieben.

Das Endergebnis in beiden Fällen würde bedeuten, dass Benutzer dann aus verschiedenen Erfahrungsstufen in der App wählen könnten – von „sicher“, was die extremeren Kommentare und Diskussionen herausfiltern würde, bis zu „ungefiltert“ (Musk würde wahrscheinlich gehen mit 'Hardcore'), was Ihnen die volle Erfahrung geben würde.

Was theoretisch interessant klingt – aber würden Benutzer ihre Tweets tatsächlich selbst klassifizieren, und würden sie diese Bewertungen oft genug korrekt erhalten, um es zu einer praktikablen Option für diese Art der Filterung zu machen?

Natürlich könnte die Plattform Strafen einführen, wenn Sie Ihre Tweets nicht oder nicht richtig klassifizieren. Vielleicht werden bei Wiederholungstätern alle ihre Tweets automatisch in die extremere Segmentierung gefiltert, während andere eine maximale Reichweite des Publikums erzielen können, indem ihre Inhalte in beiden oder allen Streams angezeigt werden.

Es würde den Benutzern mehr manuelle Arbeit bei der Auswahl einer Klassifizierung innerhalb des Kompositionsprozesses abverlangen, aber vielleicht könnte das einige Bedenken zerstreuen?

Aber andererseits würde dies immer noch nicht verhindern, dass soziale Plattformen genutzt werden, um Hassreden zu verstärken und gefährliche Bewegungen zu schüren.

In den meisten Fällen, in denen Twitter oder andere soziale Apps zur Zensur von Benutzern verschoben wurden, geschah dies wegen der Androhung von Schaden, nicht weil die Leute notwendigerweise von den abgegebenen Kommentaren beleidigt sind.

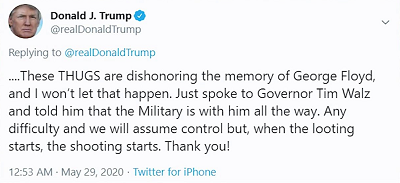

Zum Beispiel, als der ehemalige Präsident Donald Trump postete:

Die Sorge war nicht so sehr, dass die Leute von seinem Kommentar „Wenn die Plünderungen beginnen, beginnen die Schießereien“ beleidigt sein würden, die Sorge war eher, dass Trumps Anhänger dies im Wesentlichen als Lizenz zum Töten auffassen könnten, was der Präsident effektiv befürwortet die Anwendung tödlicher Gewalt, um Plünderer abzuschrecken.

Logischerweise möchten soziale Plattformen nicht, dass ihre Tools dazu verwendet werden, potenziellen Schaden auf diese Weise zu verbreiten, und in dieser Hinsicht wird Selbstzensur oder die Auswahl einer Alterseinstufung für Ihre Beiträge dieses Schlüsselproblem nicht lösen, sondern schon verbergen Sie solche Kommentare einfach vor Benutzern, die sie nicht sehen möchten.

Mit anderen Worten, es ist eher Verschleierung als verbesserte Sicherheit – aber viele scheinen zu glauben, dass das Kernproblem nicht darin besteht, dass die Leute solche Dinge online sagen und sagen wollen, sondern dass andere davon beleidigt sind.

Das ist nicht das Problem, und obwohl das Verbergen von potenziell anstößigem Material einen gewissen Wert haben könnte, um die Exposition zu verringern, insbesondere im Fall von TikTok, für jüngere Zielgruppen, wird es die Menschen dennoch nicht davon abhalten, das enorme Reichweitenpotenzial sozialer Apps zu nutzen, um Hass zu verbreiten und gefährliche Handlungsaufforderungen, die in der Tat zu realen Schäden führen können.

Im Wesentlichen handelt es sich um ein stückweises Angebot, eine Verwässerung der Verantwortung, die in einigen Fällen einige Auswirkungen haben wird, aber nicht die Kernverantwortung sozialer Plattformen anspricht, um sicherzustellen, dass die von ihnen erstellten Tools und Systeme nicht für gefährliche Zwecke verwendet werden Zweck.

Denn sie sind es und sie werden es auch weiterhin sein. Soziale Plattformen wurden genutzt, um zivile Unruhen, politische Aufstände, Unruhen, Militärputsche und mehr anzuheizen.

Erst diese Woche wurden neue rechtliche Schritte gegen Meta eingeleitet, weil sie zugelassen haben, dass „ gewalttätige und hasserfüllte Posts in Äthiopien auf Facebook gedeihen und den blutigen Bürgerkrieg des Landes entfachen “. Die Klage fordert Schadensersatz in Höhe von 2 Milliarden US-Dollar für die Opfer der daraus resultierenden Gewalt.

Es geht nicht nur um politische Meinungen, denen Sie nicht zustimmen, Social-Media-Plattformen können genutzt werden, um echte, gefährliche Bewegungen zu schüren.

In solchen Fällen hilft wahrscheinlich keine noch so große Selbstzertifizierung – es wird immer eine gewisse Pflicht auf den Plattformen geben, die Regeln festzulegen, um sicherzustellen, dass diese Art von Worst-Case-Szenarien angegangen werden.

Das oder die Regeln müssen auf einer höheren Ebene von Regierungen und Behörden festgelegt werden, die darauf ausgelegt sind, die Auswirkungen solcher Maßnahmen zu messen und entsprechend zu handeln.

Aber am Ende geht es hier nicht um soziale Plattformen, die es den Menschen ermöglichen, zu sagen, was sie wollen, und zu teilen, was ihnen gefällt, wie es viele Befürworter der „Redefreiheit“ fordern. Auf einer bestimmten Ebene wird es immer Grenzen geben, es wird immer Leitplanken geben, und manchmal können sie angesichts des Verstärkungspotenzials sozialer Posten durchaus über die Gesetze des Landes hinausgehen.

Es gibt keine einfachen Antworten, aber es dem Willen der Menschen zu überlassen, wird wahrscheinlich nicht zu einer besseren Situation an allen Fronten führen.